我有一张来自ToF相机(Kinect V2)的深度图像。我不知道像素大小,但我知道深度图像的分辨率为512x424。我还知道我拥有70.6x60度的视场角。

我之前在这里询问了如何获取像素大小。在Matlab中,代码如下所示。

亮度越高的像素,物体越近。

close all

clear all

%Load image

depth = imread('depth_0_30_0_0.5.png');

frame_width = 512;

frame_height = 424;

horizontal_scaling = tan((70.6 / 2) * (pi/180));

vertical_scaling = tan((60 / 2) * (pi/180));

%pixel size

with_size = horizontal_scaling * 2 .* (double(depth)/frame_width);

height_size = vertical_scaling * 2 .* (double(depth)/frame_height);

图像本身是一个旋转了30度的立方体,可以在这里看到:

。

。现在我想计算像素到摄像机平面的水平角度和垂直角度。

我尝试使用三角测量来完成这个任务,首先在水平方向上计算一个像素到另一个像素的Z距离,然后再在垂直方向上进行计算。我使用卷积来实现这个过程:

%get the horizontal errors

dx = abs(conv2(depth,[1 -1],'same'));

%get the vertical errors

dy = abs(conv2(depth,[1 -1]','same'));

接下来我通过 atan 函数进行计算,代码如下:

horizontal_angle = rad2deg(atan(with_size ./ dx));

vertical_angle = rad2deg(atan(height_size ./ dy));

horizontal_angle(horizontal_angle == NaN) = 0;

vertical_angle(vertical_angle == NaN) = 0;

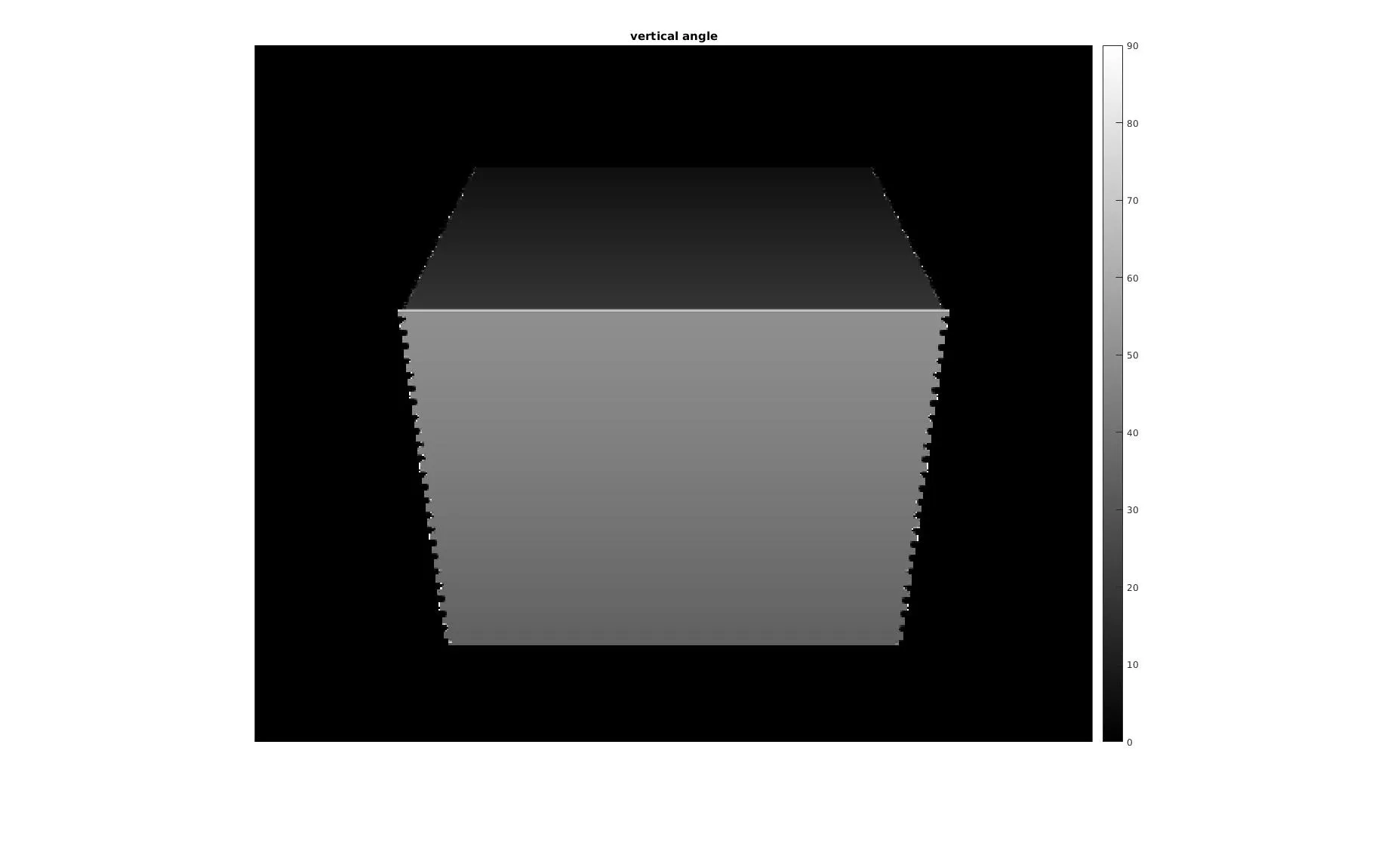

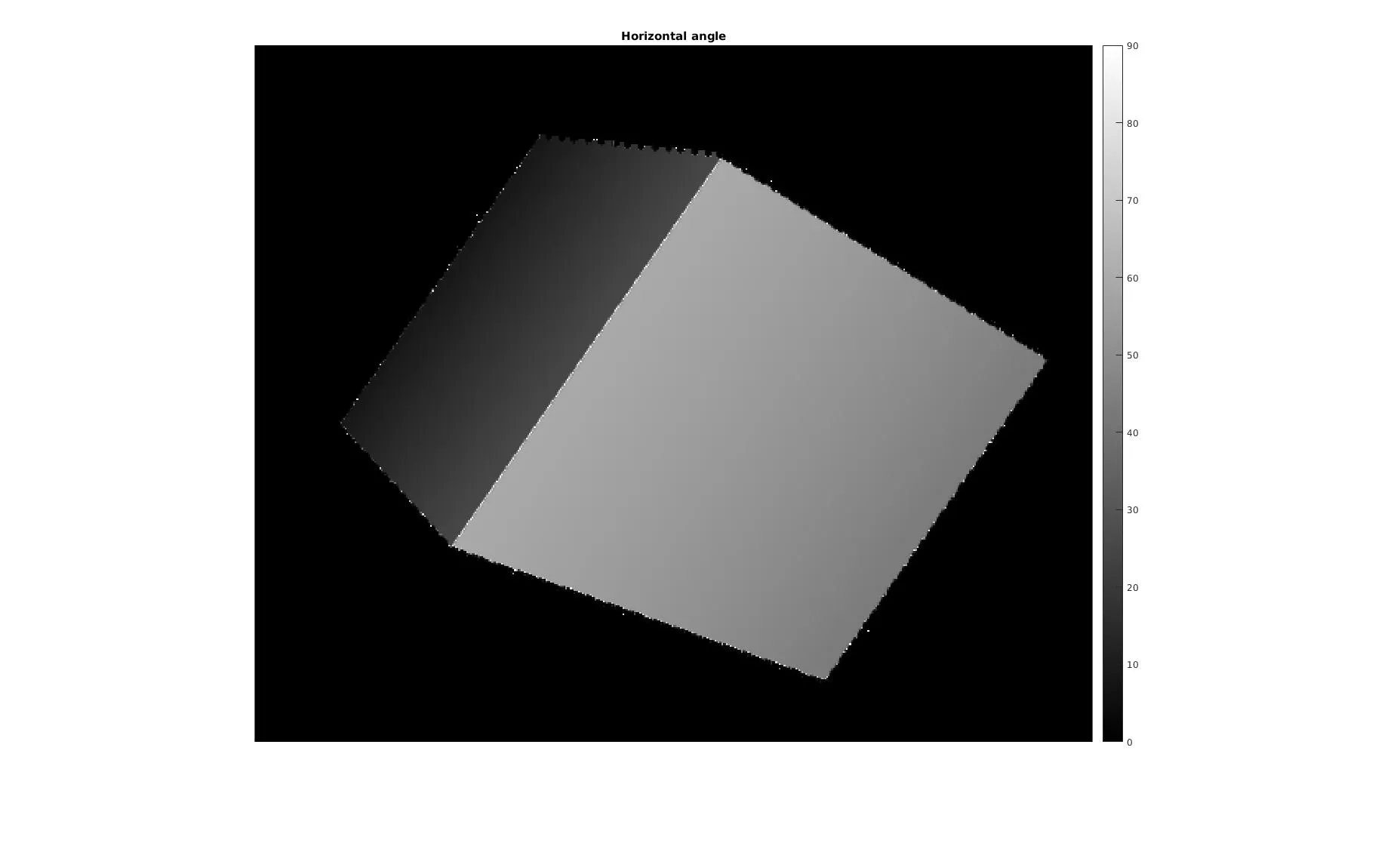

这里展示了一个有希望的结果,如下所示:

。

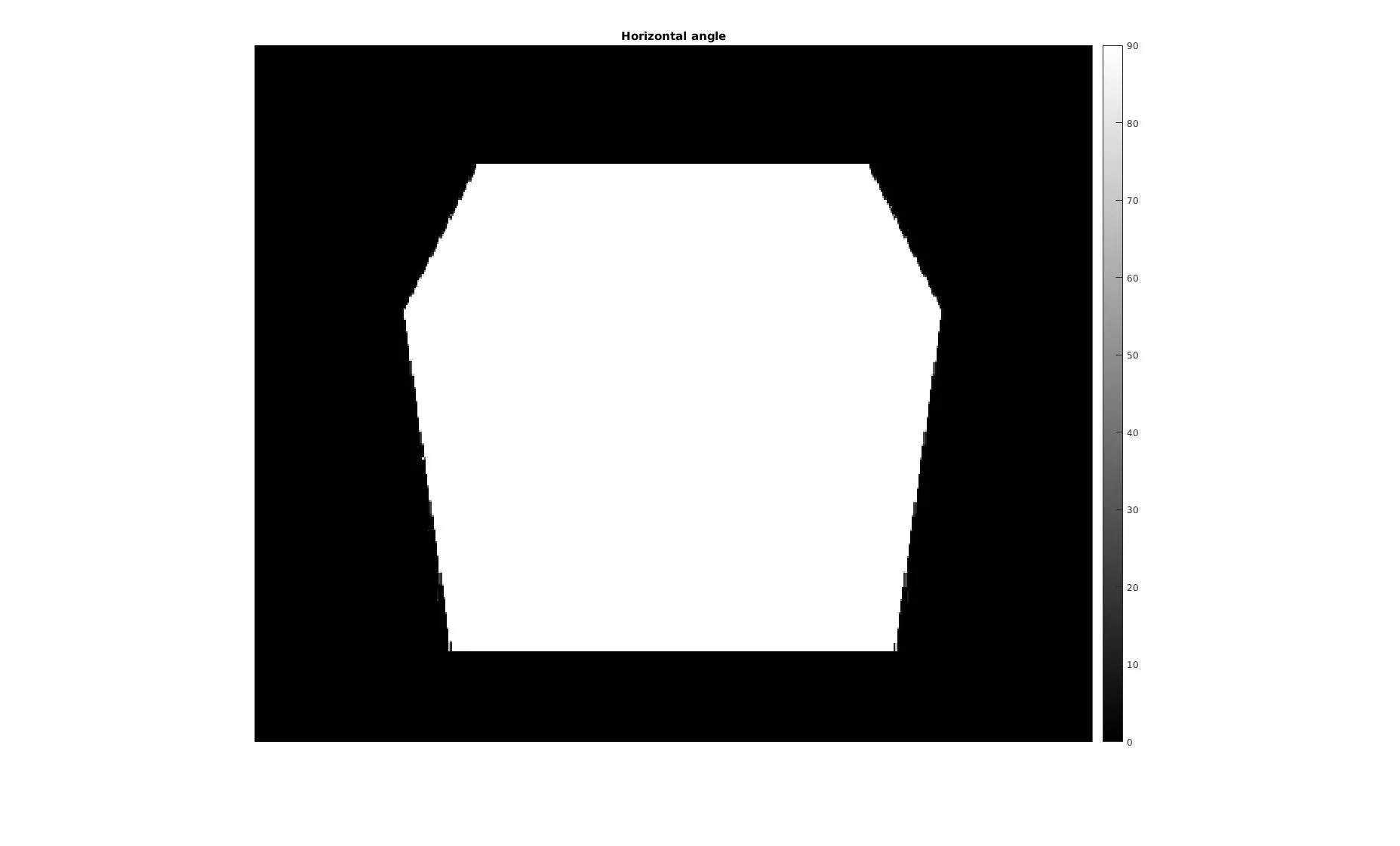

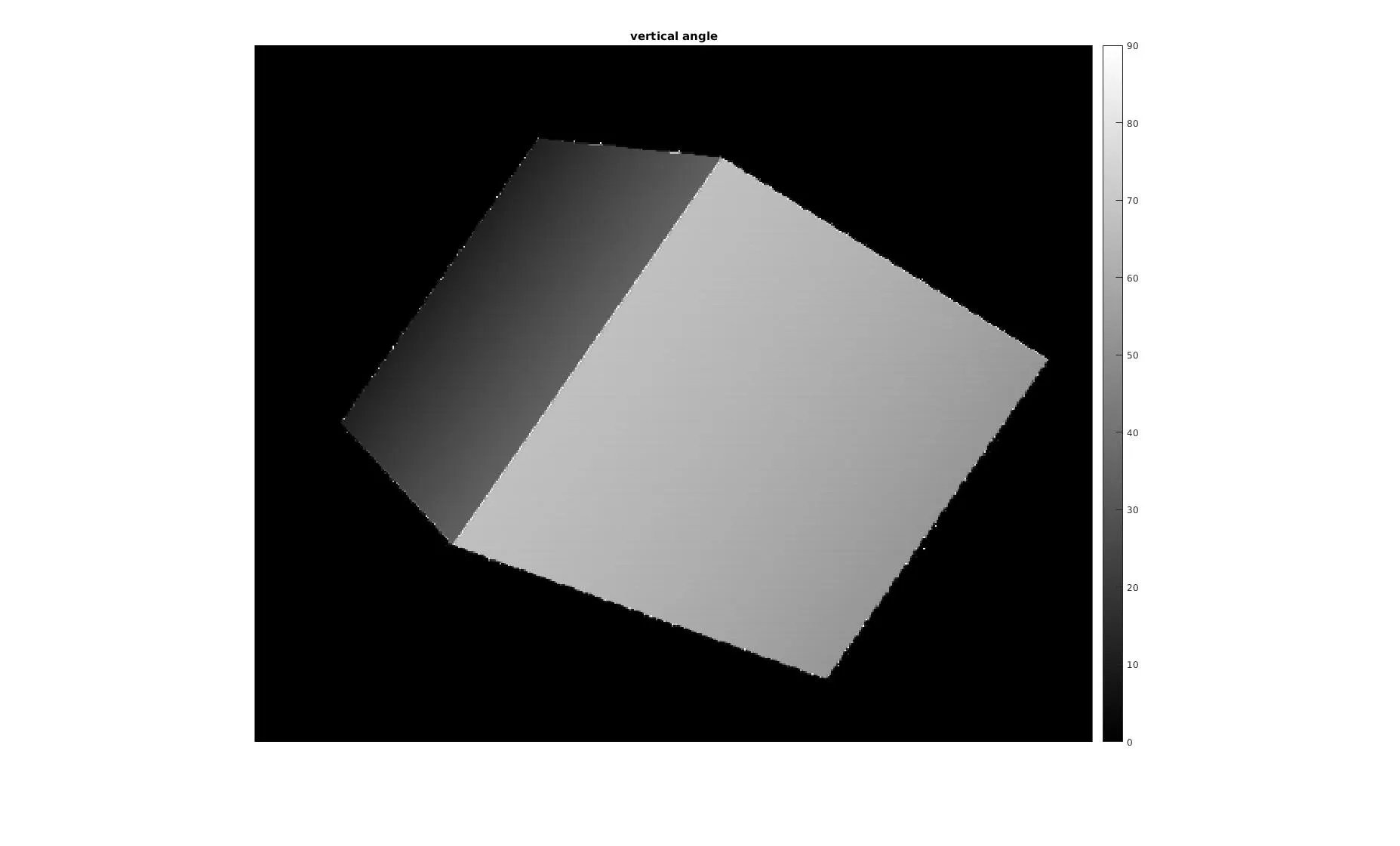

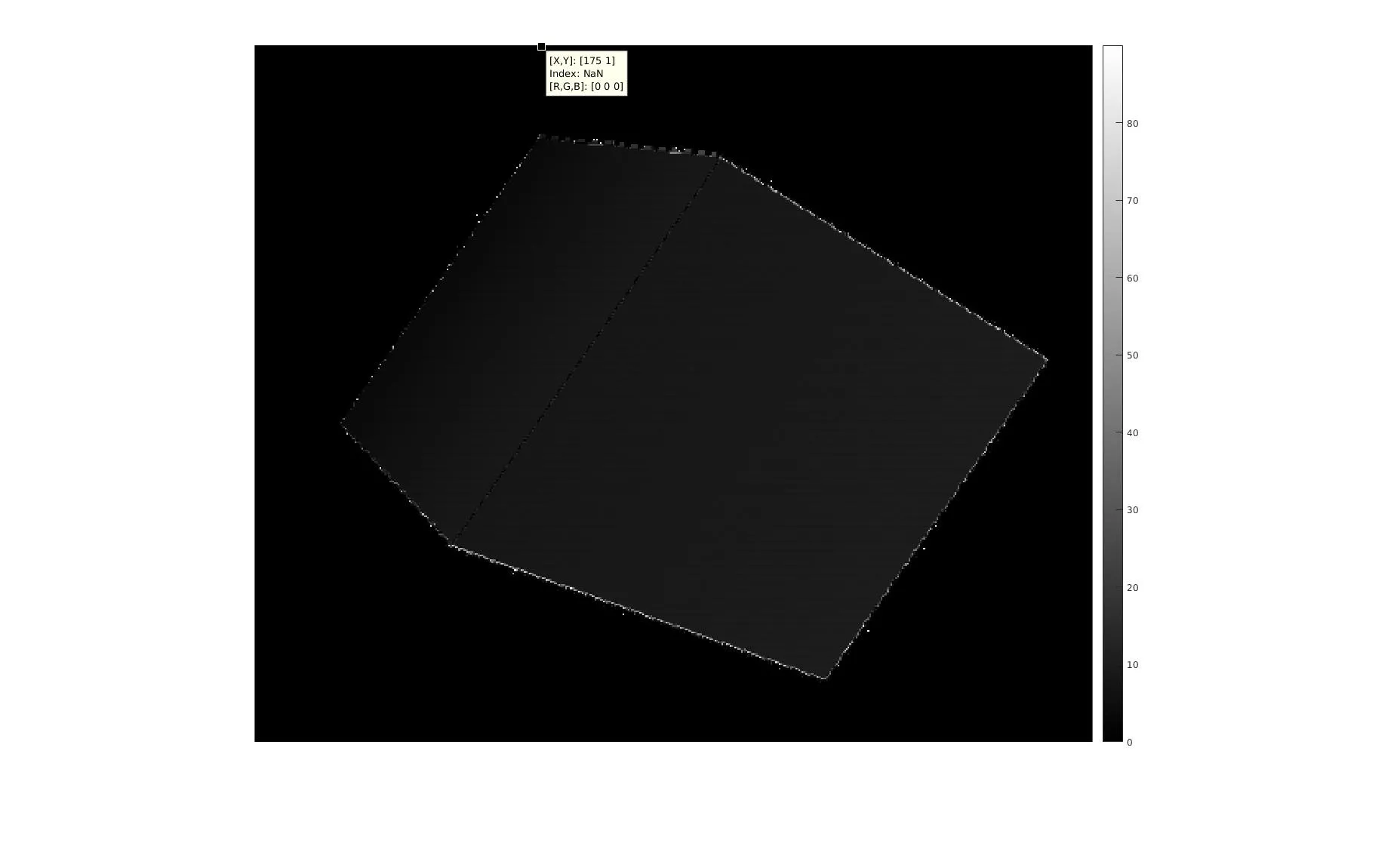

。然而,使用像这样稍微复杂一点的图像,它被旋转了60°和30°,会得到相同角度的水平和垂直角度的图像,如下所示:

。

。从两幅图像中相互减去后,可以得到以下图像-表明这两者之间存在差异:

。

。因此,我的问题是:如何证明这个概念?数学是否正确,只是测试用例选择不当?在两幅图像之间从水平到垂直角度的角度差太小了吗?计算中是否有任何错误?