问题

我正在尝试使用连续的历史数据(5年)来预测下一年的值。

数据结构

我的输入数据input_04_08长这样,其中第一列是一年中的天数(1到365),第二列是记录的输入值。

1,2

2,2

3,0

4,0

5,0

我的输出数据output_04_08看起来像这样,是一列数据,记录了该年的那一天的输出。

27.6

28.9

0

0

0

我会将值归一化到0到1之间,这样传递给网络的第一个样本看起来就像

Number of training patterns: 1825

Input and output dimensions: 2 1

First sample (input, target):

[ 0.00273973 0.04 ] [ 0.02185273]

方法

前馈神经网络

我已在PyBrain中实现了以下代码。

input_04_08 = numpy.loadtxt('./data/input_04_08.csv', delimiter=',')

input_09 = numpy.loadtxt('./data/input_09.csv', delimiter=',')

output_04_08 = numpy.loadtxt('./data/output_04_08.csv', delimiter=',')

output_09 = numpy.loadtxt('./data/output_09.csv', delimiter=',')

input_04_08 = input_04_08 / input_04_08.max(axis=0)

input_09 = input_09 / input_09.max(axis=0)

output_04_08 = output_04_08 / output_04_08.max(axis=0)

output_09 = output_09 / output_09.max(axis=0)

ds = SupervisedDataSet(2, 1)

for x in range(0, 1825):

ds.addSample(input_04_08[x], output_04_08[x])

n = FeedForwardNetwork()

inLayer = LinearLayer(2)

hiddenLayer = TanhLayer(25)

outLayer = LinearLayer(1)

n.addInputModule(inLayer)

n.addModule(hiddenLayer)

n.addOutputModule(outLayer)

in_to_hidden = FullConnection(inLayer, hiddenLayer)

hidden_to_out = FullConnection(hiddenLayer, outLayer)

n.addConnection(in_to_hidden)

n.addConnection(hidden_to_out)

n.sortModules()

trainer = BackpropTrainer(n, ds, learningrate=0.01, momentum=0.1)

for epoch in range(0, 100000000):

if epoch % 10000000 == 0:

error = trainer.train()

print 'Epoch: ', epoch

print 'Error: ', error

result = numpy.array([n.activate(x) for x in input_09])

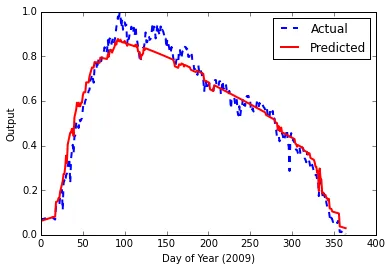

这给了我以下结果,最终误差为0.00153840123381

毫无疑问,这看起来很不错。然而,阅读更多有关LSTM(长短时记忆)神经网络及其在时间序列数据中的适用性方面的内容后,我正在尝试构建一个。

LSTM网络

以下是我的代码

input_04_08 = numpy.loadtxt('./data/input_04_08.csv', delimiter=',')

input_09 = numpy.loadtxt('./data/input_09.csv', delimiter=',')

output_04_08 = numpy.loadtxt('./data/output_04_08.csv', delimiter=',')

output_09 = numpy.loadtxt('./data/output_09.csv', delimiter=',')

input_04_08 = input_04_08 / input_04_08.max(axis=0)

input_09 = input_09 / input_09.max(axis=0)

output_04_08 = output_04_08 / output_04_08.max(axis=0)

output_09 = output_09 / output_09.max(axis=0)

ds = SequentialDataSet(2, 1)

for x in range(0, 1825):

ds.newSequence()

ds.appendLinked(input_04_08[x], output_04_08[x])

fnn = buildNetwork( ds.indim, 25, ds.outdim, hiddenclass=LSTMLayer, bias=True, recurrent=True)

trainer = BackpropTrainer(fnn, ds, learningrate=0.01, momentum=0.1)

for epoch in range(0, 10000000):

if epoch % 100000 == 0:

error = trainer.train()

print 'Epoch: ', epoch

print 'Error: ', error

result = numpy.array([fnn.activate(x) for x in input_09])

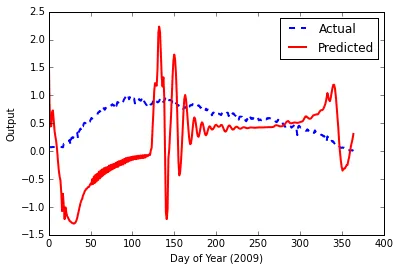

这导致最终误差为0.000939719502501,但是这次当我输入测试数据时,输出图表看起来很糟糕。

可能出现的问题

我在这里查看了几乎所有与PyBrain相关的问题,但是以下问题并没有帮助我解决问题:

我阅读了一些博客文章,这些文章对我的理解有所帮助,但显然还不够

自然地,我也阅读了PyBrain文档,但在这里顺序数据集方面找不到太多帮助。欢迎任何想法/技巧/方向。