我目前正在研究光线追踪技术,我认为我已经做得很好了,但是我还没有涉及到摄像机。

到目前为止,我使用的是平面片段作为视平面,位于

除此之外,我主要在点

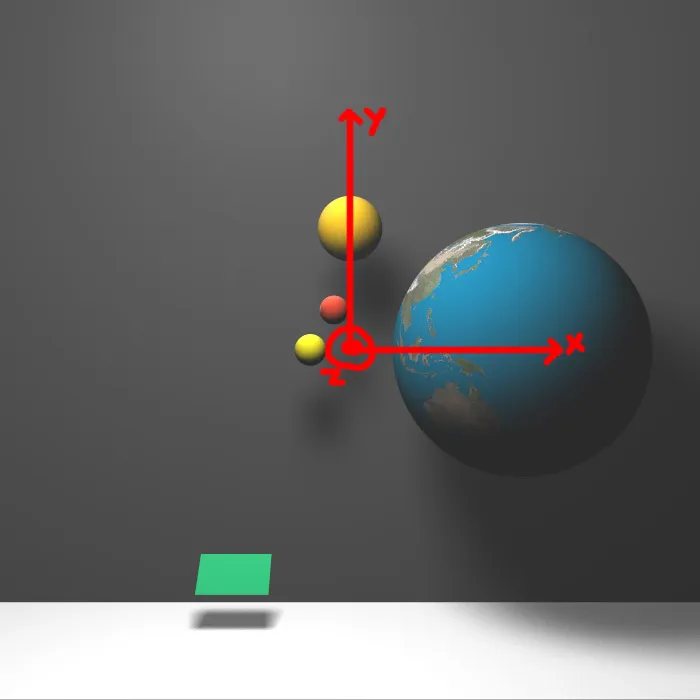

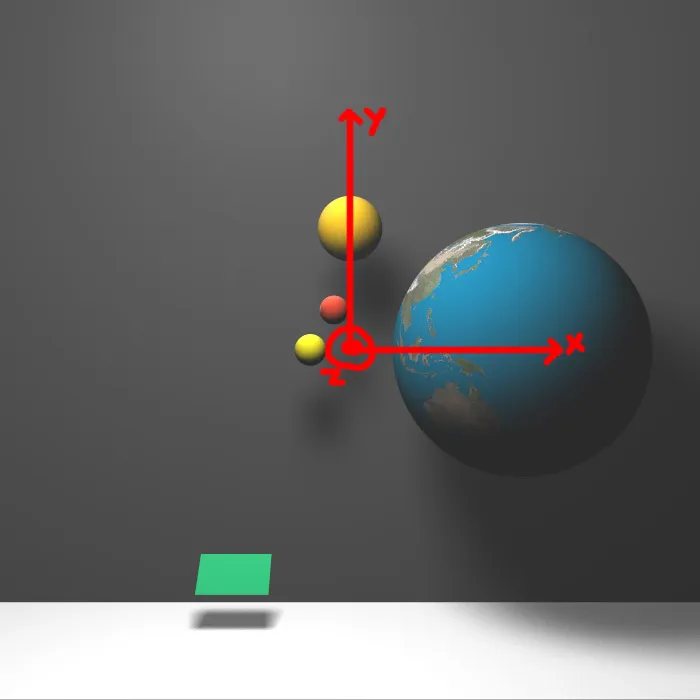

我从点 这是我创建的一张图片,希望您能通过查看图片猜测出眼睛和视平面的位置。

这是我创建的一张图片,希望您能通过查看图片猜测出眼睛和视平面的位置。

我的问题从这里开始。现在是移动我的相机的时候了,但我不知道如何将二维视平面坐标映射到规范化坐标。是否有用于此的转换矩阵?

我认为这种方法需要知道视平面上像素的三维坐标。我不确定这是否是使用的正确方法。那么,您有什么建议呢?

到目前为止,我使用的是平面片段作为视平面,位于

(-宽度/2,高度/2,200)和(宽度/2,-高度/2,200)之间[ 200只是z的固定数字,可以更改]。除此之外,我主要在点

e(0,0,1000)上使用相机,并使用透视投影。我从点

e向像素发送光线,并在计算出像素颜色后将其打印到图像的相应像素上。 这是我创建的一张图片,希望您能通过查看图片猜测出眼睛和视平面的位置。

这是我创建的一张图片,希望您能通过查看图片猜测出眼睛和视平面的位置。我的问题从这里开始。现在是移动我的相机的时候了,但我不知道如何将二维视平面坐标映射到规范化坐标。是否有用于此的转换矩阵?

我认为这种方法需要知道视平面上像素的三维坐标。我不确定这是否是使用的正确方法。那么,您有什么建议呢?