2个回答

9

计算数据框 df 的两行 i 和 j 之间的欧氏距离:

np.linalg.norm(df.loc[i] - df.loc[j])

要计算相邻行之间的差异,即0和1,1和2,2和3等...

np.linalg.norm(df.diff(axis=0).drop(0), axis=1)

如果您想在所有行之间进行计算,即0和1、0和2、...、1和1、1和2等,则必须循环遍历所有i和j的组合(请记住,对于44062行,存在970707891个这样的组合,因此使用for循环会非常慢):

import itertools

for i, j in itertools.combinations(df.index, 2):

d_ij = np.linalg.norm(df.loc[i] - df.loc[j])

编辑:

相反,您可以使用scipy.spatial.distance.cdist来计算两个输入集合之间的距离:

from scipy.spatial.distance import cdist

cdist(df, df, 'euclid')

这将为您返回一个对称的(44062乘以44062)矩阵,其中包含数据框中所有行之间的欧几里得距离。问题在于,您需要很多内存才能使其工作(至少需要8 * 44062 ** 2字节的内存,即约16GB)。因此,更好的选择是使用pdist。

from scipy.spatial.distance import pdist

pdist(df.values, 'euclid')

该函数将返回一个数组(大小为970707891),其中包含df的行之间所有成对欧几里得距离。

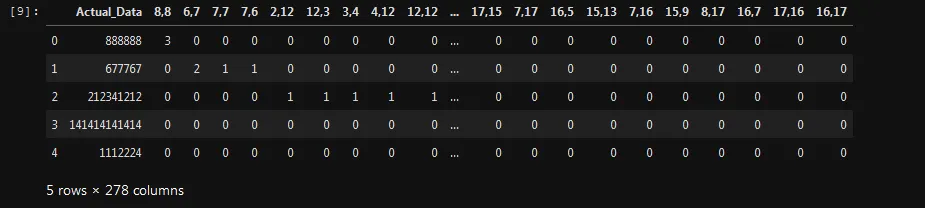

顺便提一下,在计算距离时请忽略“Actual_Data”列。例如,您可以执行以下操作:data = df.drop('Actual_Data',axis=1).values,然后 cdist(data, data, 'euclid') 或 pdist(data, 'euclid')。您还可以像下面这样创建另一个包含距离的数据框:

data = df.drop('Actual_Data', axis=1).values

d = pd.DataFrame(itertools.combinations(df.index, 2), columns=['i','j'])

d['dist'] = pdist(data, 'euclid')

i j dist

0 0 1 ...

1 0 2 ...

2 0 3 ...

3 0 4 ...

...

- Andreas K.

2

在计算欧几里得距离后,如何获得44062x44062的矩阵? - Quicklearner.gk

如果我删除实际数据,如何从这个数据框中获取44062个值的44062? - Quicklearner.gk

2

例如,只使用您数据的子集。

df_data = [[888888, 3, 0, 0],

[677767, 0, 2, 1],

[212341212, 0, 0, 0],

[141414141414, 0, 0, 0],

[1112224, 0, 0, 0]]

# Creating the data

df = pd.DataFrame(data=data, columns=['Actual_Data', '8,8', '6,6', '7,7'], dtype=np.float64)

# Which looks like

# Actual_Data 8,8 6,6 7,7

# 0 8.888880e+05 3.0 0.0 0.0

# 1 6.777670e+05 0.0 2.0 1.0

# 2 2.123412e+08 0.0 0.0 0.0

# 3 1.414141e+11 0.0 0.0 0.0

# 4 1.112224e+06 0.0 0.0 0.0

# Computing the distance matrix

dist_matrix = df.apply(lambda row: [np.linalg.norm(row.values - df.loc[[_id], :].values, 2) for _id in df.index.values], axis=1)

# Which looks like

# 0 [0.0, 211121.00003315636, 211452324.0, 141413252526.0, 223336.000020149]

# 1 [211121.00003315636, 0.0, 211663445.0, 141413463647.0, 434457.0000057543]

# 2 [211452324.0, 211663445.0, 0.0, 141201800202.0, 211228988.0]

# 3 [141413252526.0, 141413463647.0, 141201800202.0, 0.0, 141413029190.0]

# 4 [223336.000020149, 434457.0000057543, 211228988.0, 141413029190.0, 0.0]

# Reformatting the above into readable format

dist_matrix = pd.DataFrame(

data=dist_matrix.values.tolist(),

columns=df.index.tolist(),

index=df.index.tolist())

# Which gives you

# 0 1 2 3 4

# 0 0.000000e+00 2.111210e+05 2.114523e+08 1.414133e+11 2.233360e+05

# 1 2.111210e+05 0.000000e+00 2.116634e+08 1.414135e+11 4.344570e+05

# 2 2.114523e+08 2.116634e+08 0.000000e+00 1.412018e+11 2.112290e+08

# 3 1.414133e+11 1.414135e+11 1.412018e+11 0.000000e+00 1.414130e+11

# 4 2.233360e+05 4.344570e+05 2.112290e+08 1.414130e+11 0.000000e+00

更新

正如评论中指出的那样,问题是内存溢出,因此我们必须分批处理问题。

# Collecting the data

# df = ....

# Set this number to a lower value if you get the same `memory` errors.

batch = 200 # #'s of row's / user's used to compute the matrix

# To be conservative, let's write the intermediate results to file type.

dffname = []

for ifile,_slice in enumerate(np.array_split(range(df.shape[0]), batch)):

# Let's compute distance for `batch` #'s of points in data frame

tmp_df = df.iloc[_slice, :].apply(lambda row: [np.linalg.norm(row.values - df.loc[[_id], :].values, 2) for _id in df.index.values], axis=1)

tmp_df = pd.DataFrame(tmp_df.values.tolist(), index=df.index.values[_slice], columns=df.index.values)

# You can change it from csv to any other files

tmp_df.to_csv(f"{ifile+1}.csv")

dffname.append(f"{ifile+1}.csv")

# Reading back the dataFrames

dflist = []

for f in dffname:

dflist.append(pd.read_csv(f, dtype=np.float64, index_col=0))

res = pd.concat(dflist)

- DOOM

3

我认为在计算中应该忽略“Actual_data”列。此外,您应该考虑到数据框中有44062行,因此您的解决方案可能会非常缓慢。 - Andreas K.

内存错误 追溯(最近的调用最先)

<ipython-input-27-965652f0dca4> in <module>

1 from scipy.spatial.distance import cdist

2

----> 3 cdist(a, a, 'euclid')~\Anaconda3\lib\site-packages\scipy\spatial\distance.py中的cdist(XA,XB,metric,* args,** kwargs)

2727 out = kwargs.pop("out", None)

2728 if out is None:

-> 2729 dm = np.empty((mA, mB), dtype=np.double)

2730 else:

2731 if out.shape != (mA, mB):应用此方法后,我得到了上述错误cdist(a, a, 'euclid') - Quicklearner.gk

@Quicklearner,你的内存已经用完了,正如我在我的答案中所写的...一个44062乘以44062的浮点数数组至少需要大约16GB的内存。使用pdist代替它,它只需要一半的内存。 - Andreas K.

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

zero_data.apply(lambda row: distance(*row.values), axis=1)吗? - DOOM