我很好奇 Graphviz 用于回归时决策树节点中的 value 字段是什么。我知道在使用决策树分类时,它代表每个类别中通过分裂而分离的样本数,但是对于回归问题,我不确定它的含义。

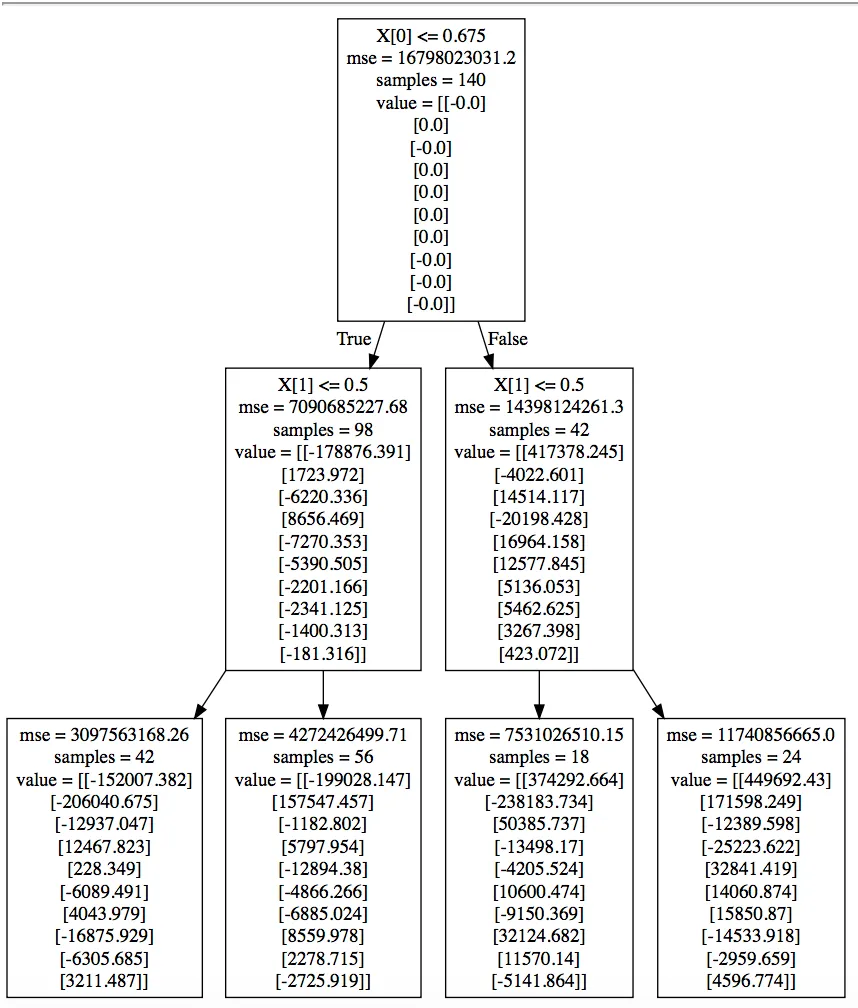

我的数据有两个维度的输入和十个维度的输出。以下是我的回归问题的一棵树的示例: 使用此代码生成并使用webgraphviz进行可视化。

我的数据有两个维度的输入和十个维度的输出。以下是我的回归问题的一棵树的示例: 使用此代码生成并使用webgraphviz进行可视化。

# X = (n x 2) Y = (n x 10) X_test = (m x 2)

input_scaler = pickle.load(open("../input_scaler.sav","rb"))

reg = DecisionTreeRegressor(criterion = 'mse', max_depth = 2)

reg.fit(X,Y)

pred = reg.predict(X_test)

with open("classifier.txt", "w") as f:

f = tree.export_graphviz(reg, out_file=f)