我正在开展一个项目,其中我将使用单应性作为分类器中的特征。我的问题在于自动计算单应性,我正在使用SIFT描述符找到两个图像之间要计算单应性的点,但是SIFT给出了非常糟糕的结果,因此我无法在我的工作中使用它们。

我使用的是OpenCV 2.4.3。

起初我使用的是SURF,但是我得到了类似的结果,因此我决定使用SIFT,它们速度较慢但更精确。我的第一个猜测是数据集中的图像分辨率太低,但我在最先进的数据集(Pointing 04)上运行了我的算法,并且我获得了几乎相同的结果,因此问题在于我所做的而不是在于我的数据集。

在每个图像中找到的SIFT关键点之间的匹配是使用FlannBased匹配器完成的,我尝试了BruteForce,但结果基本相同。

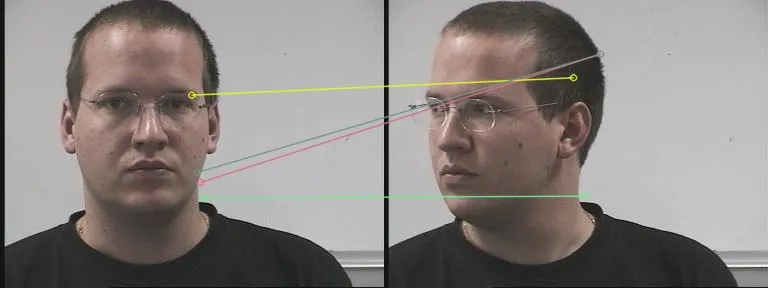

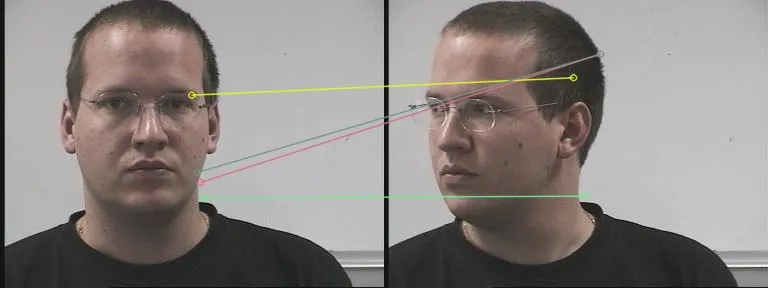

这是我发现的匹配的示例(来自Pointing 04数据集的图像) 上面的图像显示了我的程序找到的匹配有多差。只有1个点是正确的匹配。我需要(至少)4个正确的匹配来完成我的任务。

上面的图像显示了我的程序找到的匹配有多差。只有1个点是正确的匹配。我需要(至少)4个正确的匹配来完成我的任务。

以下是我使用的代码:

这是从每个图像中提取SIFT描述符的函数。

这是匹配两张图像描述符的函数。

任何关于如何提高匹配性能的帮助都将不胜感激,谢谢。

我使用的是OpenCV 2.4.3。

起初我使用的是SURF,但是我得到了类似的结果,因此我决定使用SIFT,它们速度较慢但更精确。我的第一个猜测是数据集中的图像分辨率太低,但我在最先进的数据集(Pointing 04)上运行了我的算法,并且我获得了几乎相同的结果,因此问题在于我所做的而不是在于我的数据集。

在每个图像中找到的SIFT关键点之间的匹配是使用FlannBased匹配器完成的,我尝试了BruteForce,但结果基本相同。

这是我发现的匹配的示例(来自Pointing 04数据集的图像)

上面的图像显示了我的程序找到的匹配有多差。只有1个点是正确的匹配。我需要(至少)4个正确的匹配来完成我的任务。

上面的图像显示了我的程序找到的匹配有多差。只有1个点是正确的匹配。我需要(至少)4个正确的匹配来完成我的任务。以下是我使用的代码:

这是从每个图像中提取SIFT描述符的函数。

void extract_sift(const Mat &img, vector<KeyPoint> &keypoints, Mat &descriptors, Rect* face_rec) {

// Create masks for ROI on the original image

Mat mask1 = Mat::zeros(img.size(), CV_8U); // type of mask is CV_8U

Mat roi1(mask1, *face_rec);

roi1 = Scalar(255, 255, 255);

// Extracts keypoints in ROIs only

Ptr<DescriptorExtractor> featExtractor;

Ptr<FeatureDetector> featDetector;

Ptr<DescriptorMatcher> featMatcher;

featExtractor = new SIFT();

featDetector = FeatureDetector::create("SIFT");

featDetector->detect(img,keypoints,mask1);

featExtractor->compute(img,keypoints,descriptors);

}

这是匹配两张图像描述符的函数。

void match_sift(const Mat &img1, const Mat &img2, const vector<KeyPoint> &kp1,

const vector<KeyPoint> &kp2, const Mat &descriptors1, const Mat &descriptors2,

vector<Point2f> &p_im1, vector<Point2f> &p_im2) {

// Matching descriptor vectors using FLANN matcher

Ptr<DescriptorMatcher> matcher = DescriptorMatcher::create("FlannBased");

std::vector< DMatch > matches;

matcher->match( descriptors1, descriptors2, matches );

double max_dist = 0; double min_dist = 100;

// Quick calculation of max and min distances between keypoints

for( int i = 0; i < descriptors1.rows; ++i ){

double dist = matches[i].distance;

if( dist < min_dist ) min_dist = dist;

if( dist > max_dist ) max_dist = dist;

}

// Draw only the 4 best matches

std::vector< DMatch > good_matches;

// XXX: DMatch has no sort method, maybe a more efficent min extraction algorithm can be used here?

double min=matches[0].distance;

int min_i = 0;

for( int i = 0; i < (matches.size()>4?4:matches.size()); ++i ) {

for(int j=0;j<matches.size();++j)

if(matches[j].distance < min) {

min = matches[j].distance;

min_i = j;

}

good_matches.push_back( matches[min_i]);

matches.erase(matches.begin() + min_i);

min=matches[0].distance;

min_i = 0;

}

Mat img_matches;

drawMatches( img1, kp1, img2, kp2,

good_matches, img_matches, Scalar::all(-1), Scalar::all(-1),

vector<char>(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS );

imwrite("imgMatch.jpeg",img_matches);

imshow("",img_matches);

waitKey();

for( int i = 0; i < good_matches.size(); i++ )

{

// Get the points from the best matches

p_im1.push_back( kp1[ good_matches[i].queryIdx ].pt );

p_im2.push_back( kp2[ good_matches[i].trainIdx ].pt );

}

}

然后这些函数在此处被调用:

extract_sift(dataset[i].img,dataset[i].keypoints,dataset[i].descriptors,face_rec);

[...]

// Extract keypoints from i+1 image and calculate homography

extract_sift(dataset[i+1].img,dataset[i+1].keypoints,dataset[i+1].descriptors,face_rec);

dataset[front].points_r.clear(); // XXX: dunno if clearing the points every time is the best way to do it..

match_sift(dataset[front].img,dataset[i+1].img,dataset[front].keypoints,dataset[i+1].keypoints,

dataset[front].descriptors,dataset[i+1].descriptors,dataset[front].points_r,dataset[i+1].points_r);

dataset[i+1].H = findHomography(dataset[front].points_r,dataset[i+1].points_r, RANSAC);

任何关于如何提高匹配性能的帮助都将不胜感激,谢谢。

FeatureDetector::create()中使用了"DENSE",会发生什么? - LovaBillcreate()中使用“Dense”没有显著的改进。 - powder