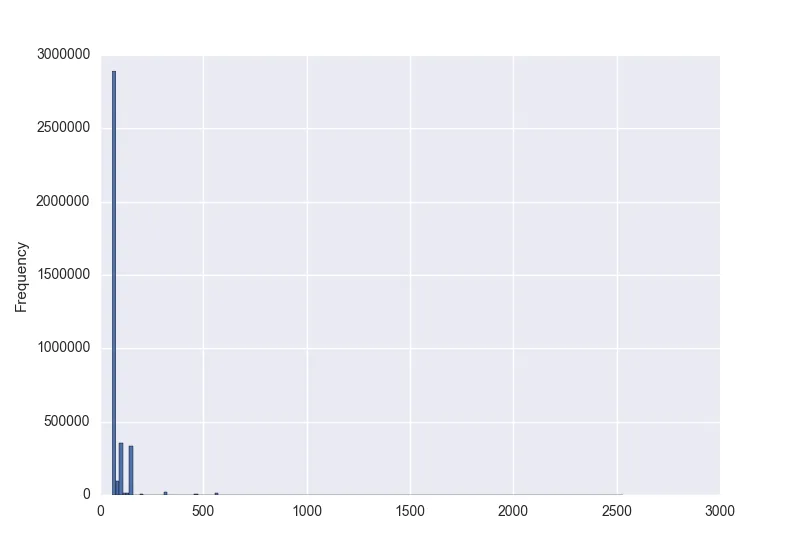

由于你似乎没有特定的分布在脑海中,但可能有很多数据样本,我建议使用非参数密度估计方法。 你描述的其中一种数据类型(以毫秒为单位的时间)显然是连续的,而连续随机变量的概率密度函数(PDF)的非参数估计方法之一是直方图,这是你已经提到过的。 然而,如下所示,核密度估计(KDE)可能更好。 你描述的第二种数据类型(序列中的字符数)是离散型的。 在这里,核密度估计也可以很有用,并且可以看作是一种平滑技术,适用于离散变量所有值的样本不足的情况。

估算密度

下面的例子展示了如何首先从两个高斯分布混合中生成数据样本,然后应用核密度估计来找到概率密度函数:

import numpy as np

import matplotlib.pyplot as plt

import matplotlib.mlab as mlab

from sklearn.neighbors import KernelDensity

data = np.concatenate((5 + np.random.randn(10, 1),

10 + np.random.randn(30, 1)))

x = np.linspace(0, 16, 1000)[:, np.newaxis]

norm_vals = mlab.normpdf(x, 5, 1) * 0.25 + mlab.normpdf(x, 10, 1) * 0.75

plt.plot(x, norm_vals)

plt.hist(data, 50, normed=True)

kd = KernelDensity(kernel='gaussian', bandwidth=0.75).fit(data)

kd_vals = np.exp(kd.score_samples(x))

plt.plot(x, kd_vals)

plt.show()

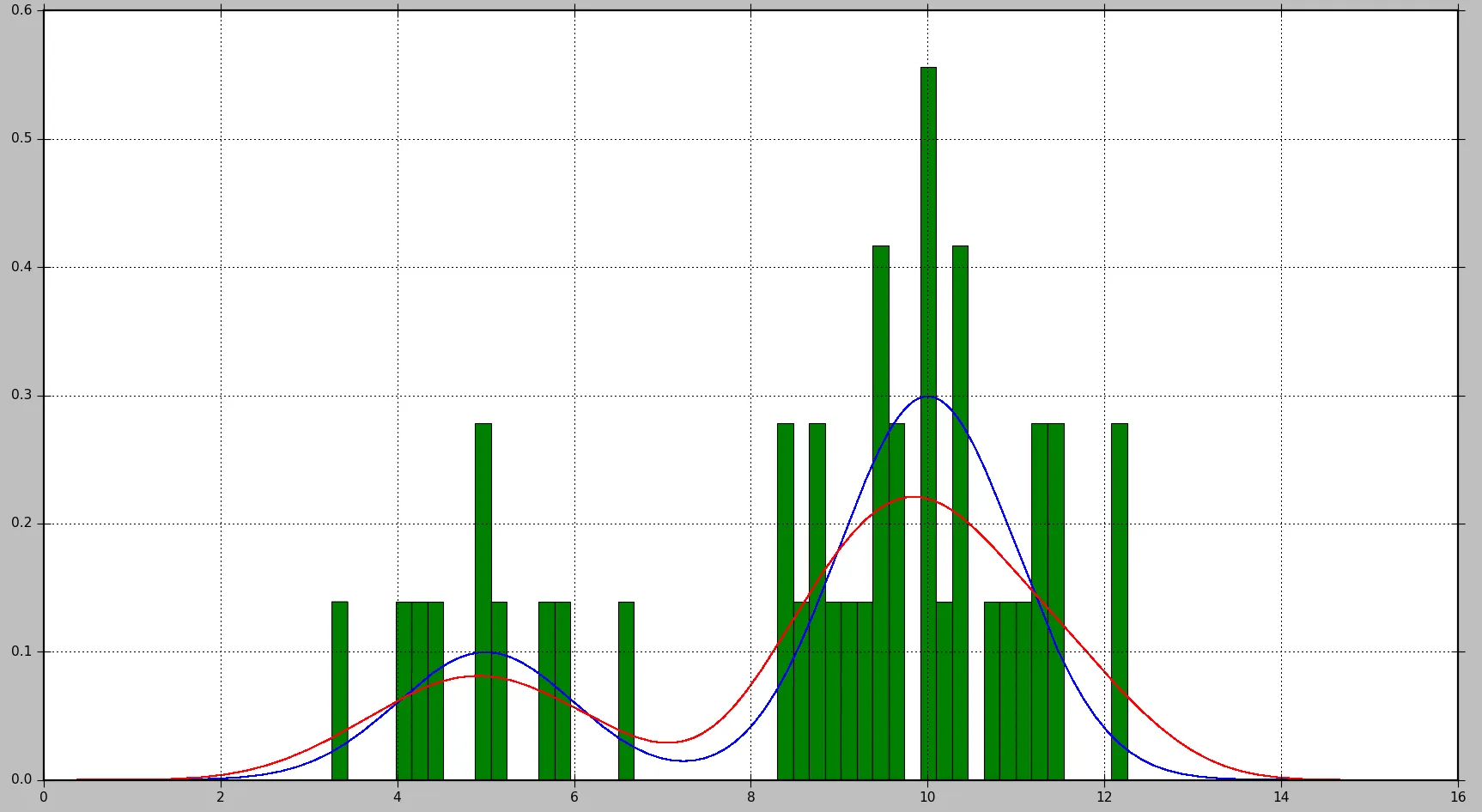

这将生成以下图表,其中真实分布显示为蓝色,直方图显示为绿色,使用KDE估计的PDF显示为红色:

可以看出,在这种情况下,由直方图近似的PDF并不是非常有用,而KDE提供了更好的估计。但是,对于更多的数据样本和适当的bin大小选择,直方图也可能产生良好的估计。

在KDE的情况下,您可以调整的参数是内核(kernel)和带宽(bandwidth)。您可以把kernel视为估计PDF的构建块,在Scikit Learn中提供了几个核函数:高斯(gaussian)、tophat、epanechnikov、指数(exponential)、线性(linear)、余弦(cosine)。改变带宽允许您调整偏差-方差权衡。较大的带宽将导致增加偏差(如果数据样本较少,则效果很好)。较小的带宽将增加方差(估计中包括较少的样本),但在有更多样本可用时会给出更好的估计。

计算概率

对于PDF,概率是通过计算一定值范围内的积分来获得的。正如您注意到的那样,这将导致特定值的概率为0。

Scikit Learn似乎没有内置的计算概率的函数。但是,在范围内估计PDF的积分很容易。我们可以通过在范围内多次评估PDF并通过每个评估点之间的步长乘以获得的值来进行求和。在下面的示例中,使用步骤(step)获取N个样本。

# Get probability for range of values

start = 5 # Start of the range

end = 6 # End of the range

N = 100 # Number of evaluation points

step = (end - start) / (N - 1) # Step size

x = np.linspace(start, end, N)[:, np.newaxis] # Generate values in the range

kd_vals = np.exp(kd.score_samples(x)) # Get PDF values for each x

probability = np.sum(kd_vals * step) # Approximate the integral of the PDF

print(probability)

请注意,

kd.score_samples 生成数据样本的对数似然。 因此,需要使用

np.exp 来获取似然。

可以使用内置的SciPy集成方法执行相同的计算,这将给出更准确的结果:

from scipy.integrate import quad

probability = quad(lambda x: np.exp(kd.score_samples(x)), start, end)[0]

例如,对于一次运行,第一个方法计算出的概率为

0.0859024655305,而第二个方法产生的结果为

0.0850974209996139。