数据框:

c_os_family_ss c_os_major_is l_customer_id_i

0 Windows 7 90418

1 Windows 7 90418

2 Windows 7 90418

代码:

print df

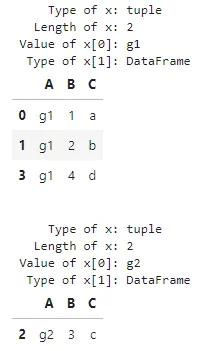

for name, group in df.groupby('l_customer_id_i').agg(lambda x: ','.join(x)):

print name

print group

我只想遍历聚合后的数据,但是我收到了错误信息:

ValueError: too many values to unpack

@EdChum,这里是预期的输出:

c_os_family_ss \

l_customer_id_i

131572 Windows 7,Windows 7,Windows 7,Windows 7,Window...

135467 Windows 7,Windows 7,Windows 7,Windows 7,Window...

c_os_major_is

l_customer_id_i

131572 ,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,...

135467 ,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,...

输出并不是问题,我希望能够循环遍历每个组。

for row, data in group.iterrows()迭代遍历一个单独的group! - tatlar