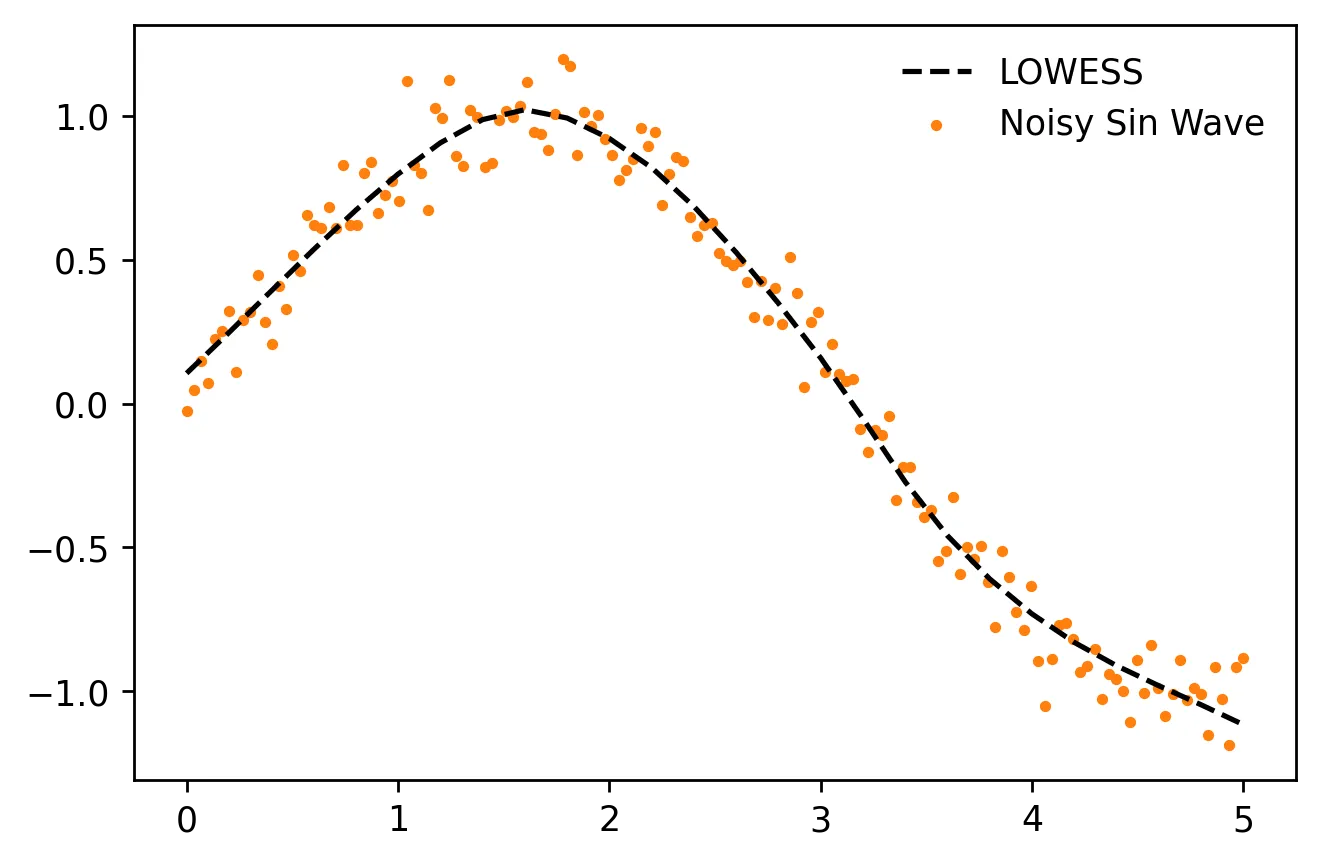

如何在Python中拟合局部加权回归,以便可以用于对新数据进行预测?

有一个名为

有一个名为

statsmodels.nonparametric.smoothers_lowess.lowess的方法,但它仅返回原始数据集的估计值;因此它似乎只能同时执行fit和predict,而不能像我期望的那样分别执行。

scikit-learn总是有一个fit方法,允许对象稍后用predict来处理新数据;但它没有实现lowess。