我已经查看了许多stackoverflow上的代码,并在同一行上编写了自己的代码。但是存在一些问题,我无法理解。为了分析目的,我正在存储theta1和theta2的值以及成本函数。可以从这个Openclassroom页面下载x和Y数据,它们以.dat文件的形式提供,您可以在记事本中打开。

%Single Variate Gradient Descent Algorithm%%

clc

clear all

close all;

% Step 1 Load x series/ Input data and Output data* y series

x=load('D:\Office Docs_Jay\software\ex2x.dat');

y=load('D:\Office Docs_Jay\software\ex2y.dat');

%Plot the input vectors

plot(x,y,'o');

ylabel('Height in meters');

xlabel('Age in years');

% Step 2 Add an extra column of ones in input vector

[m n]=size(x);

X=[ones(m,1) x];%Concatenate the ones column with x;

% Step 3 Create Theta vector

theta=zeros(n+1,1);%theta 0,1

% Create temporary values for storing summation

temp1=0;

temp2=0;

% Define Learning Rate alpha and Max Iterations

alpha=0.07;

max_iterations=1;

% Step 4 Iterate over loop

for i=1:1:max_iterations

%Calculate Hypothesis for all training example

for k=1:1:m

h(k)=theta(1,1)+theta(2,1)*X(k,2); %#ok<AGROW>

temp1=temp1+(h(k)-y(k));

temp2=temp2+(h(k)-y(k))*X(k,2);

end

% Simultaneous Update

tmp1=theta(1,1)-(alpha*1/(2*m)*temp1);

tmp2=theta(2,1)-(alpha*(1/(2*m))*temp2);

theta(1,1)=tmp1;

theta(2,1)=tmp2;

theta1_history(i)=theta(2,1); %#ok<AGROW>

theta0_history(i)=theta(1,1); %#ok<AGROW>

% Step 5 Calculate cost function

tmp3=0;

tmp4=0;

for p=1:m

tmp3=tmp3+theta(1,1)+theta(2,1)*X(p,1);

tmp4=tmp4+theta(1,1)+theta(2,1)*X(p,2);

end

J1_theta0(i)=tmp3*(1/(2*m)); %#ok<AGROW>

J2_theta1(i)=tmp4*(1/(2*m)); %#ok<AGROW>

end

theta

hold on;

plot(X(:,2),theta(1,1)+theta(2,1)*X);

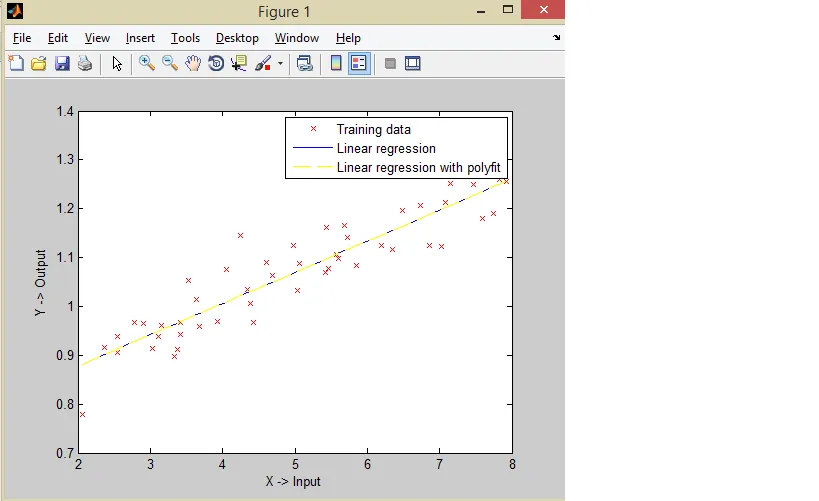

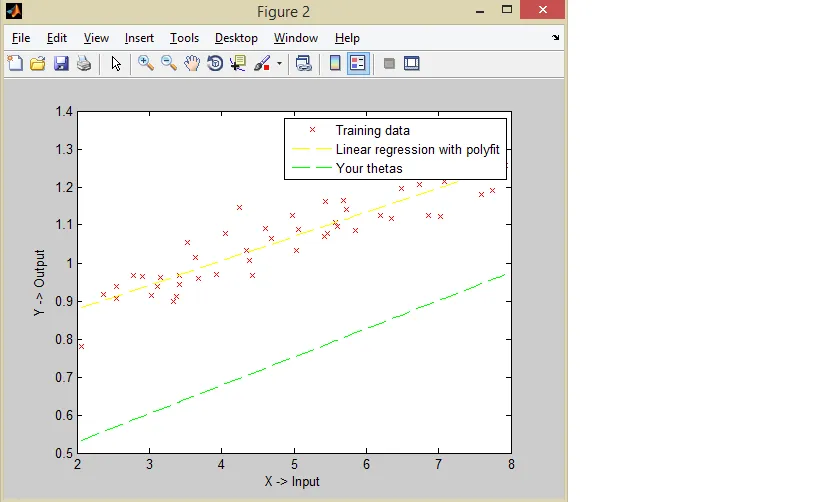

我正在获取值为theta的内容。

在0.0373和0.1900时,它应该是0.0745和0.3800。

这个值大约是我期望值的两倍。