我使用rf方法训练了一个数据集。例如:

ctrl <- trainControl(

method = "LGOCV",

repeats = 3,

savePred=TRUE,

verboseIter = TRUE,

preProcOptions = list(thresh = 0.95)

)

preProcessInTrain<-c("center", "scale")

metric_used<-"Accuracy"

model <- train(

Output ~ ., data = training,

method = "rf",

trControl = ctrl,

metric=metric_used,

tuneLength = 10,

preProc = preProcessInTrain

)

之后,我想绘制决策树,但是当我写

plot(model)时,我得到了这个:plot(model)。如果我写

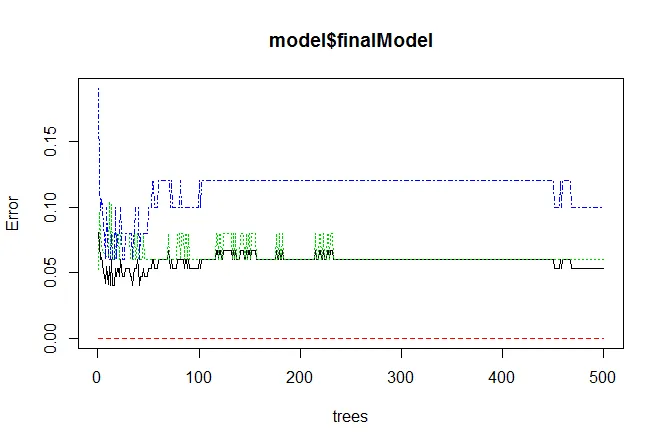

plot(model$finalModel),我得到的是这个:plot(model$finalModel)

我想要绘制决策树……

如何做到这一点?

谢谢 :)