我正在尝试测量相机的姿态,并已完成以下操作。

- 在平面表面的正方形角落上标记世界三维点(假设z=0,因为它是平的),并假定一个世界坐标系。(以厘米为单位)

已将正方形的左上角作为原点,并按以下顺序(x,y)或(col,row)给出了世界点: (0,0),(-12.8,0),(-12.8,12.8),(0,12.8) - 以厘米为单位

2. 检测我的图像中的点(以像素为单位)。 图像点和世界点按相同顺序排列。 3. 我已经校准了相机的内部矩阵和畸变系数。 4. 我使用SolvePnP函数获取rvec和tvec。 5. 我使用Rodrigues函数获取旋转矩阵。 6. 为了检查rvec和tvec是否正确,我使用ProjectPoints将三维点(z=0)投影回图像平面,我在我的图像上正确地获得了点,X轴误差为3个像素。 7. 现在,我使用公式计算相机在世界坐标系中的位置: cam_worl_pos = -inverse(R) * tvec。 (我在许多博客中验证了这个公式,也很有道理) 8. 但是我的cam_worl_pos x、y和z在厘米上似乎不正确。我的疑惑是,如果我能够使用rvec和tvec将3D世界点投影回图像平面(X轴上有3个像素的误差,Y轴上几乎没有误差,希望不会太糟),那么为什么我没有得到正确的相机位置。

此外,我对SolvPnP rvec和tvec解决方案有疑问,它们可能是多个解决方案之一,但不是我想要的。

如何从SolvPnp获取正确的rvec和tvec,或者任何其他获得rvec和tvec的建议也将有所帮助。

编辑:

图像尺寸 - 720(行)* 1280(列)

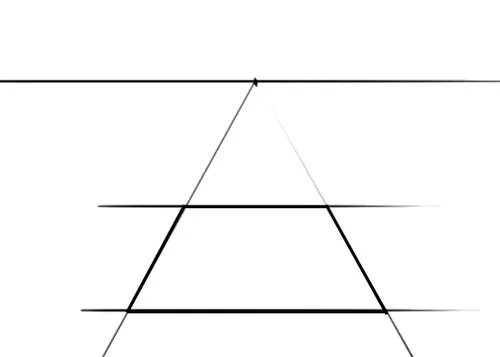

相机看到的校准图案

新编辑:

遵循右手定则的世界坐标系及其在图像中对应的点

左侧正方形是我的世界坐标系,边长为12.8厘米,左上角是世界原点(0,0)。红色点是在图像中检测到的三维世界点。

所看到的图像是鱼眼镜头相机径向畸变校正后的结果。

相机参数

cameraMatrix_Front=[908.65 0 642.88

0 909.28 364.95

0 0 1]

distCoeffs_Front=[-0.4589, 0.09462, -1.46*10^-3, 1.23*10^-3]

OpenCV C++ 代码:

vector<Point3f> front_object_pts;

Mat rvec_front;

Mat tvec_front;

Mat rotation_front;

Mat world_position_front_cam;

//Fill front object points(x-y-z order in cms)

//It is square of side 12.8cms on Z=0 plane

front_object_pts.push_back(Point3f(0, 0, 0));

front_object_pts.push_back(Point3f(-12.8, 0, 0));

front_object_pts.push_back(Point3f(-12.8,12.8,0));

front_object_pts.push_back(Point3f(0, 12.8, 0));

//Corresponding Image points detected in the same order as object points

front_image_pts.push_back(points_front[0]);

front_image_pts.push_back(points_front[1]);

front_image_pts.push_back(points_front[2]);

front_image_pts.push_back(points_front[3]);

//Detected points in image matching the 3-D points in the same order

//(467,368)

//(512,369)

//(456,417)

//(391,416)

//Get rvec and tvec using Solve PnP

solvePnP(front_object_pts, front_image_pts, cameraMatrix_Front,

Mat(4,1,CV_64FC1,Scalar(0)), rvec_front, tvec_front, false, CV_ITERATIVE);

//Output of SolvePnP

//tvec=[-26.951,0.6041,134.72] (3 x 1 matrix)

//rvec=[-1.0053,0.6691,0.3752] (3 x 1 matrix)

//Check rvec and tvec is correct or not by projecting the 3-D object points to image

vector<Point2f>check_front_image_pts

projectPoints(front_object_pts, rvec_front, tvec_front,

cameraMatrix_Front, distCoeffs_Front, check_front_image_pts);

//Here to note that I have made **distCoefficents**,

//a 0 vector since my image points are detected after radial distortion is removed

//Get rotation matrix

Rodrigues(rvec_front, rotation_front);

//Get rotation matrix inverse

Mat rotation_inverse;

transpose(rotation_front, rotation_inverse);

//Get camera position in world cordinates

world_position_front_cam = -rotation_inverse * tvec_front;

//相机的实际位置(手动测量近似值)

X=-47厘米

Y=18厘米

Z=25厘米

//获取的位置

X=-110厘米

Y=71厘米

Z=40厘米

提前致谢。