2个回答

3

当您不平衡设置这样一个不平衡的数据集时,显然目标值将始终下降 - 可能会达到将所有预测分类为多数类别的点,同时具有极好的目标值。

平衡课程是必要的,但并不意味着您应该停留在 is_unbalanced - 您可以使用 sample_pos_weight,自定义指标,或对样本应用权重,如以下所示:

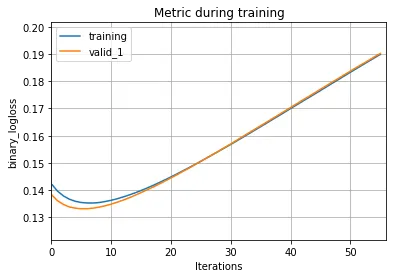

此外,优化其他超参数应该解决增加“log_loss”的问题。

平衡课程是必要的,但并不意味着您应该停留在 is_unbalanced - 您可以使用 sample_pos_weight,自定义指标,或对样本应用权重,如以下所示:

WEIGHTS = y_train.value_counts(normalize = True).min() / y_train.value_counts(normalize = True)

TRAIN_WEIGHTS = pd.DataFrame(y_train.rename('old_target')).merge(WEIGHTS, how = 'left', left_on = 'old_target', right_on = WEIGHTS.index).target.values

train_data = lgb.Dataset(X_train, label=y_train, weight = TRAIN_WEIGHTS)

此外,优化其他超参数应该解决增加“log_loss”的问题。

- Rafa

1

当你设置Is_unbalace: True时,算法会尝试自动平衡被支配标签的权重(在训练集中具有正/负分数)。 如果你想在不平衡的数据集情况下改变scale_pos_weight(默认为1,意味着假设正负标签相等),你可以使用以下公式(基于lightgbm存储库上的此问题)来正确设置它。 sample_pos_weight = 负样本数量 / 正样本数量

- AKSHAY KUMAR RAY

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

- 相关问题

- 4 访问LightGBM模型参数

- 5 LightGbm: 如何使用 eval_sample_weight

- 20 LightGBM中的'Dataset中使用categorical_feature'警告?

- 4 LightGBM超参数调优随机搜索CV

- 5 LightGBM的'class_weight'参数:在二元分类中使用还是不使用?

- 23 LightGBM中的交叉验证

- 3 如何在LightGBM中使用"is_unbalance"和"scale_pos_weight"参数进行不平衡的二元分类项目(80:20)的处理。

- 9 lightgbm的Python Dataset参考参数是什么意思?

- 3 lightgbm中的pred_leaf参数

- 3 无法在mlflow/hyperopt中使用log_params记录lightGBM参数的日志。