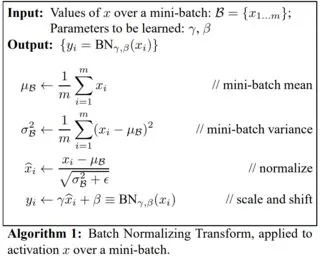

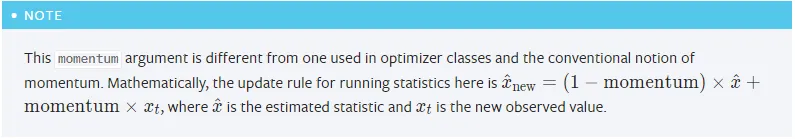

我想知道从nn.BatchNorm2d中调用的running_mean和running_var是什么。

以下是示例代码,其中bn代表nn.BatchNorm2d。

vector = torch.cat([

torch.mean(self.conv3.bn.running_mean).view(1), torch.std(self.conv3.bn.running_mean).view(1),

torch.mean(self.conv3.bn.running_var).view(1), torch.std(self.conv3.bn.running_var).view(1),

torch.mean(self.conv5.bn.running_mean).view(1), torch.std(self.conv5.bn.running_mean).view(1),

torch.mean(self.conv5.bn.running_var).view(1), torch.std(self.conv5.bn.running_var).view(1)

])

我在Pytorch官方文档和用户社区中都无法理解running_mean和running_var的含义。

nn.BatchNorm2.running_mean和nn.BatchNorm2.running_var是什么意思?