我知道Spark Sql和Hive几乎相同。现在我已经创建了一张表,但是当我尝试用Spark sql查询来创建表的索引时,总是会出现以下错误:

"Error in SQL statement: AnalysisException: mismatched input '' expecting AS near ')' in create index statement" 我使用的Spark SQL查询是:

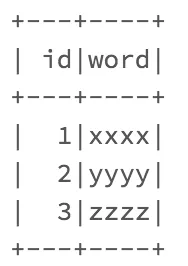

id的数据类型是bigint。 在此之前,我也尝试在此表的“word”列上创建表索引,但出现了相同的错误。 那么,是否有通过Spark SQL查询创建索引的方法呢?

"Error in SQL statement: AnalysisException: mismatched input '' expecting AS near ')' in create index statement" 我使用的Spark SQL查询是:

CREATE INDEX word_idx ON TABLE t (id)

id的数据类型是bigint。 在此之前,我也尝试在此表的“word”列上创建表索引,但出现了相同的错误。 那么,是否有通过Spark SQL查询创建索引的方法呢?

mLib的StringIndexer? - David Griffin