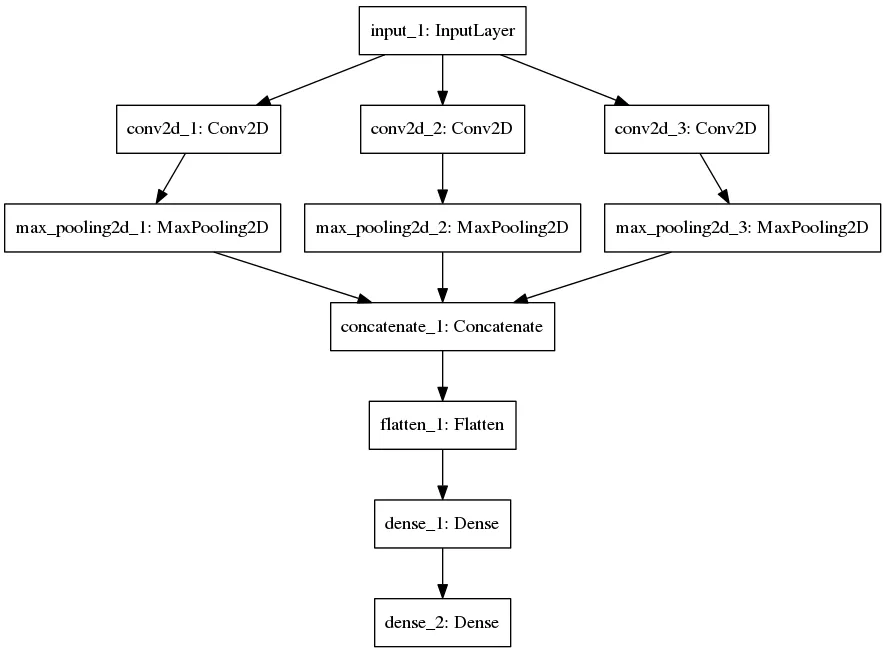

我对神经网络和Keras还不是很熟悉。我有一些尺寸为6*7的图像,过滤器的大小为15。我想要几个过滤器,然后分别在每个上训练卷积层,最后将它们组合起来。我已经看了这里的一个例子:

model = Sequential()

model.add(Convolution2D(nb_filters, kernel_size[0], kernel_size[1],

border_mode='valid',

input_shape=input_shape))

model.add(Activation('relu'))

model.add(Convolution2D(nb_filters, kernel_size[0], kernel_size[1]))

model.add(Activation('relu'))

model.add(MaxPooling2D(pool_size=pool_size))

model.add(Dropout(0.25))

model.add(Flatten(input_shape=input_shape))

model.add(Dense(128))

model.add(Activation('relu'))

model.add(Dense(128))

model.add(Activation('relu'))

model.add(Dropout(0.5))

model.add(Dense(nb_classes))

model.add(Activation('tanh'))

这个模型只使用了一个卷积核。有没有人可以给我一些提示,如何修改模型以使用平行的卷积层。

谢谢