一般情况下,我们会在卷积层之间插入最大池化层。主要的想法是“总结”卷积层中的特征。但是很难确定何时插入。我有一些问题如下:

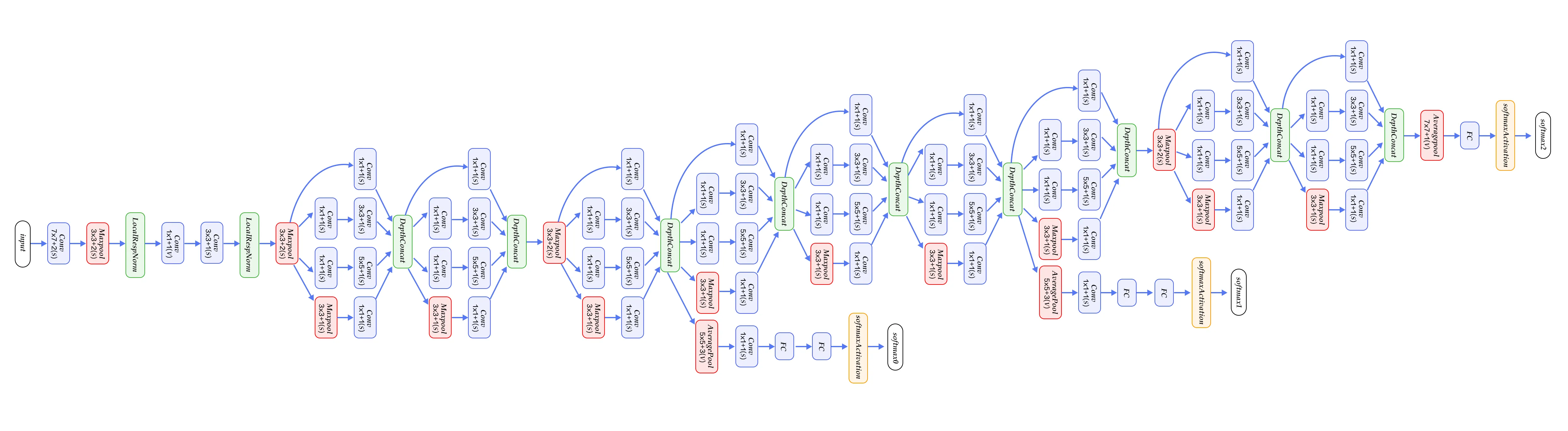

- 如何决定在插入最大池化之前有多少个卷积层?太多或太少的卷积层会产生什么影响?

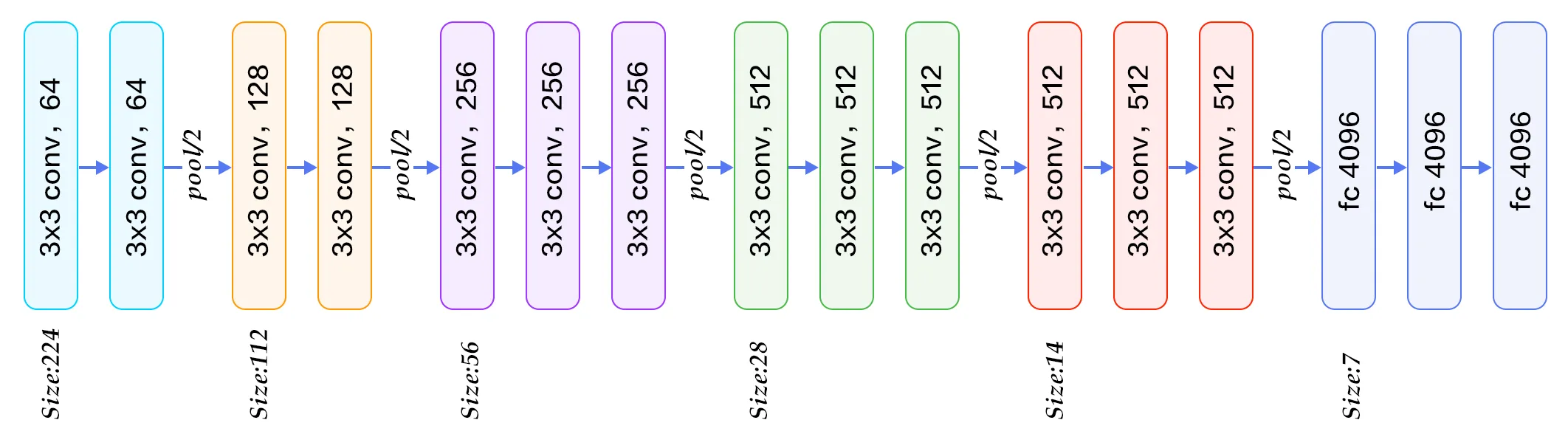

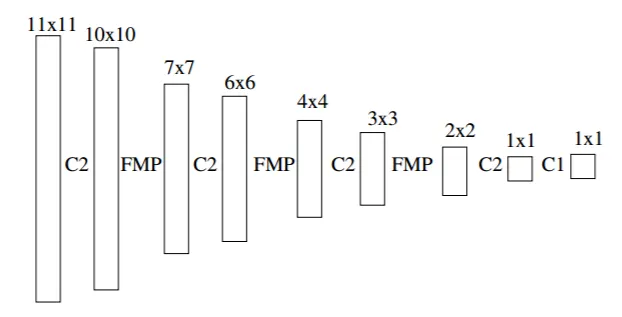

- 由于最大池化会减小尺寸,所以如果我们想使用非常深的网络,则不能进行太多的最大池化,否则尺寸会变得太小。例如,MNIST只有28x28的输入,但我确实看到有些人使用非常深的网络进行实验,因此他们可能最终得到非常小的尺寸?实际上,当尺寸太小时(极端情况下,1x1),它就像一个全连接层,似乎对它们进行卷积没有任何意义。