我只是想找出如何使用Caffe。为此,我仅查看了示例文件夹中不同的.prototxt文件。有一个选项我不理解:

# The learning rate policy

lr_policy: "inv"

可能的取值如下:

"fixed""inv""step""multistep""stepearly""poly"

能否有人解释一下这些选项?

我只是想找出如何使用Caffe。为此,我仅查看了示例文件夹中不同的.prototxt文件。有一个选项我不理解:

# The learning rate policy

lr_policy: "inv"

可能的取值如下:

"fixed""inv""step""multistep""stepearly""poly"能否有人解释一下这些选项?

这是一种常见的做法,随着优化/学习过程的进行,降低学习率(lr)。然而,如何根据迭代次数精确地降低学习率尚不清楚。

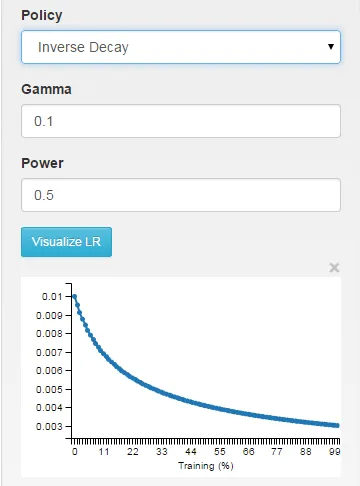

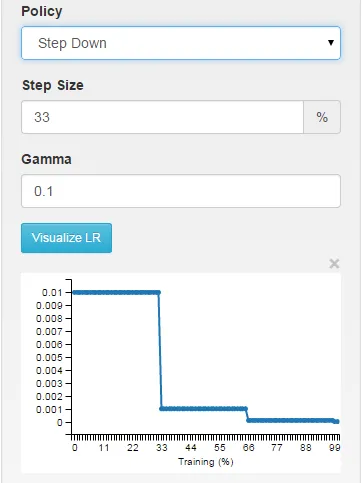

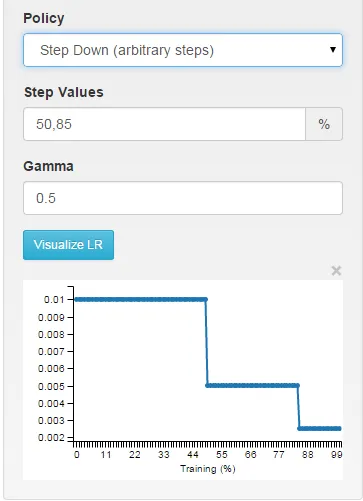

如果您使用DIGITS作为接口来使用Caffe,您将能够直观地看到不同选择对学习率的影响。

fixed: 学习率在整个学习过程中保持不变。

inv:学习速率随着 ~1/T 衰减

您可以在函数 SGDSolver<Dtype>::GetLearningRate(solvers/sgd_solver.cpp 第 ~30 行)中精确查看学习率是如何计算的。

lr_policy来交替减小和增加学习率。他的作品还提供了如何在Caffe中实现这个策略的建议。如果你查看 /caffe-master/src/caffe/proto/caffe.proto 文件(你可以在这里找到它 here),你会看到以下描述:

// The learning rate decay policy. The currently implemented learning rate

// policies are as follows:

// - fixed: always return base_lr.

// - step: return base_lr * gamma ^ (floor(iter / step))

// - exp: return base_lr * gamma ^ iter

// - inv: return base_lr * (1 + gamma * iter) ^ (- power)

// - multistep: similar to step but it allows non uniform steps defined by

// stepvalue

// - poly: the effective learning rate follows a polynomial decay, to be

// zero by the max_iter. return base_lr (1 - iter/max_iter) ^ (power)

// - sigmoid: the effective learning rate follows a sigmod decay

// return base_lr ( 1/(1 + exp(-gamma * (iter - stepsize))))

//

// where base_lr, max_iter, gamma, step, stepvalue and power are defined

// in the solver parameter protocol buffer, and iter is the current iteration.