首先,@MaxU的答案是正确的,对于向量化的pd.series/dataframe并行应用非常高效和理想。

将比较两个流行库的性能,以返回给定IP地址信息的位置数据。简而言之:使用geolite2方法。

1. geolite2包来自geolite2库

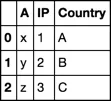

输入

import time

from geolite2 import geolite2

geo = geolite2.reader()

df_1 = train_data.loc[:50,['IP_Address']]

def IP_info_1(ip):

try:

x = geo.get(ip)

except ValueError:

return np.nan

try:

return x['country']['names']['en'] if x is not None else np.nan

except KeyError:

return np.nan

s_time = time.time()

df_1['country'] = df_1.loc[:,'IP_Address'].apply(IP_info_1)

print(df_1.head(), '\n')

print('Time:',str(time.time()-s_time)+'s \n')

print(type(geo.get('48.151.136.76')))

输出

IP_Address country

0 48.151.136.76 United States

1 94.9.145.169 United Kingdom

2 58.94.157.121 Japan

3 193.187.41.186 Austria

4 125.96.20.172 China

Time: 0.09906983375549316s

<class 'dict'>

2. ip2geotools 库中的 DbIpCity 包

输入

import time

s_time = time.time()

from ip2geotools.databases.noncommercial import DbIpCity

df_2 = train_data.loc[:50,['IP_Address']]

def IP_info_2(ip):

try:

return DbIpCity.get(ip, api_key = 'free').country

except:

return np.nan

df_2['country'] = df_2.loc[:, 'IP_Address'].apply(IP_info_2)

print(df_2.head())

print('Time:',str(time.time()-s_time)+'s')

print(type(DbIpCity.get('48.151.136.76',api_key = 'free')))

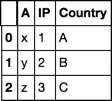

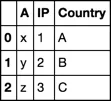

输出

IP_Address country

0 48.151.136.76 US

1 94.9.145.169 GB

2 58.94.157.121 JP

3 193.187.41.186 AT

4 125.96.20.172 CN

Time: 80.53318452835083s

<class 'ip2geotools.models.IpLocation'>

一个可能导致巨大时间差异的原因是输出的数据结构,即直接从字典中进行子集提取似乎比从专门的ip2geotools.models.IpLocation对象进行索引更有效率。

此外,第一种方法的输出是包含地理位置数据的字典,可以分别对其进行子集提取以获取所需信息:

x = geolite2.reader().get('48.151.136.76')

print(x)

>>>

{'city': {'geoname_id': 5101798, 'names': {'de': 'Newark', 'en': 'Newark', 'es': 'Newark', 'fr': 'Newark', 'ja': 'ニューアーク', 'pt-BR': 'Newark', 'ru': 'Ньюарк'}},

'continent': {'code': 'NA', 'geoname_id': 6255149, 'names': {'de': 'Nordamerika', 'en': 'North America', 'es': 'Norteamérica', 'fr': 'Amérique du Nord', 'ja': '北アメリカ', 'pt-BR': 'América do Norte', 'ru': 'Северная Америка', 'zh-CN': '北美洲'}},

'country': {'geoname_id': 6252001, 'iso_code': 'US', 'names': {'de': 'USA', 'en': 'United States', 'es': 'Estados Unidos', 'fr': 'États-Unis', 'ja': 'アメリカ合衆国', 'pt-BR': 'Estados Unidos', 'ru': 'США', 'zh-CN': '美国'}},

'location': {'accuracy_radius': 1000, 'latitude': 40.7355, 'longitude': -74.1741, 'metro_code': 501, 'time_zone': 'America/New_York'},

'postal': {'code': '07102'},

'registered_country': {'geoname_id': 6252001, 'iso_code': 'US', 'names': {'de': 'USA', 'en': 'United States', 'es': 'Estados Unidos', 'fr': 'États-Unis', 'ja': 'アメリカ合衆国', 'pt-BR': 'Estados Unidos', 'ru': 'США', 'zh-CN': '美国'}},

'subdivisions': [{'geoname_id': 5101760, 'iso_code': 'NJ', 'names': {'en': 'New Jersey', 'es': 'Nueva Jersey', 'fr': 'New Jersey', 'ja': 'ニュージャージー州', 'pt-BR': 'Nova Jérsia', 'ru': 'Нью-Джерси', 'zh-CN': '新泽西州'}}]}

apply函数并将自定义函数重写为一些pandas向量化函数。 - jezraelfind_country_from_ip的所有功能? - jezraelsubprocess.Popen("mmdblookup --file GeoIP2-Country.mmdb --ip {} country names en".format(ip).split(" "), stdout=subprocess.PIPE).stdout.read()吗?还是只需要对每个唯一的IP调用一次?是否存在重复的IP? - jezraelprint(len(df.IP.drop_duplicates()))是什么意思? - jezrael