编辑:更新。无论用户数量如何,都会发生这种情况。

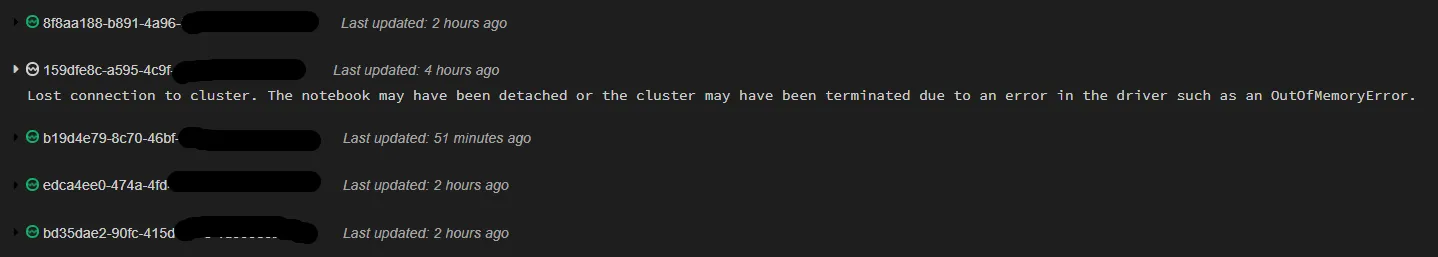

Databricks笔记本在使用过程中反复分离。

我们的数据科学家来自Jupyter背景,并且由于Koalas存在一些差距,他继续使用Pandas并采用了一些解决方法,这意味着驱动程序负载更重,但笔记本似乎是功能齐备的。

我寻找有类似问题的人,但没有看到这个问题。

这是我的spark配置:

spark.driver.extraJavaOptions -XX:+UseG1GC

spark.driver.cores 8

spark.driver.memory 16g

spark.executor.extraJavaOptions -XX:+UseG1GC

当数据科学家分离时看到的两个错误:

笔记本分离

Notebook detached

Exception when creating execution context:

java.util.concurrent.TimeoutException: Exchange timed out after 15 seconds.

The spark context has been stopped or the cluster has been terminated.

Please restart the cluster or attach this notebook to a different cluster.

这个群集似乎没问题,因为我可以连接另一个笔记本电脑并运行命令。

我期望的情况是笔记本不会在任何时候随机断开连接并且失去所有工作。

当我查看驱动程序日志时,只有这些信息比较突出:

19/10/08 18:02:59 INFO TaskSchedulerImpl: Killing all running tasks in stage 82: Stage finished

19/10/08 18:02:59 INFO DAGScheduler: Job 57 finished: collectResult at OutputAggregator.scala:149, took 9.157699 s

19/10/08 18:02:59 INFO SQLAppStatusListener: Execution ID: 28 Total Executor Run Time: 21250

19/10/08 18:02:59 INFO CodeGenerator: Code generated in 21.921114 ms

19/10/08 18:03:00 INFO ProgressReporter$: Removed result fetcher for 8919779546758574174_8732072469296650198_763335e3d46b4641ba75b3c6d4b4ffac

19/10/08 18:04:30 INFO DriverCorral$: Cleaning the wrapper ReplId-5231d-7b5c0-a6423-e (currently in status Idle(ReplId-5231d-7b5c0-a6423-e))

19/10/08 18:04:30 INFO DriverCorral$: sending shutdown signal for REPL ReplId-5231d-7b5c0-a6423-e

19/10/08 18:04:31 INFO PythonDriverLocal$Watchdog: Python shell exit code: 143

19/10/08 18:04:31 INFO PythonDriverLocal$RedirectThread: Python RedirectThread exit

19/10/08 18:04:31 INFO PythonDriverLocal$RedirectThread: Python RedirectThread exit

19/10/08 18:04:31 INFO PythonDriverLocal$Watchdog: No strace information recovered: /tmp/637654b25044473abae9a282b9564078.strace is missing

19/10/08 18:04:31 INFO DriverCorral$: sending the interrupt signal for REPL ReplId-5231d-7b5c0-a6423-e

19/10/08 18:04:31 INFO DriverCorral$: waiting for localThread to stop for REPL ReplId-5231d-7b5c0-a6423-e

19/10/08 18:04:31 INFO DriverCorral$: ReplId-5231d-7b5c0-a6423-e successfully discarded