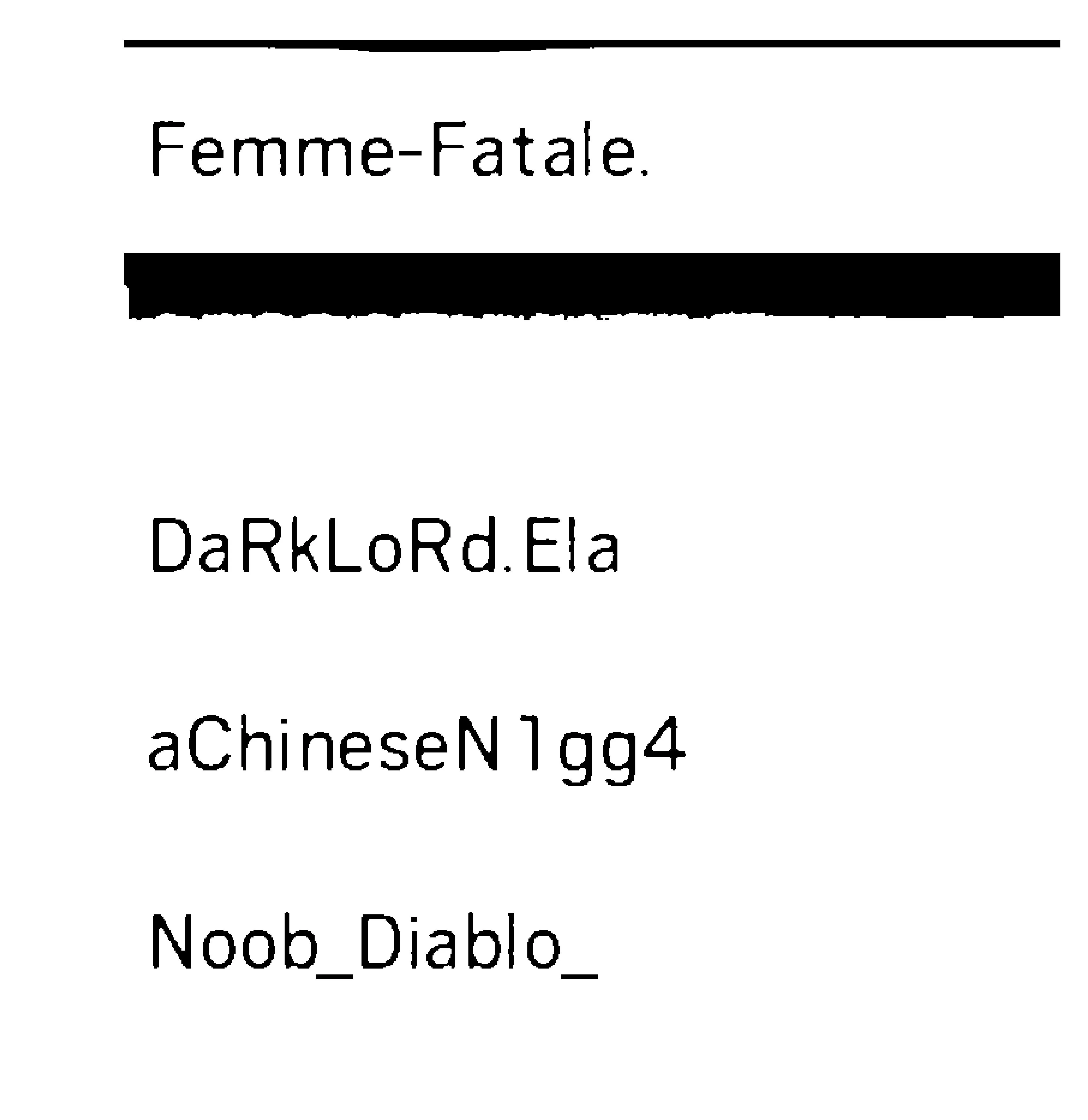

Femme—Fatale.

DaRkLoRdEIa

aChineseN1gg4

Noob_Diablo_

Kicked.

NosNoel

ChikiZD

Death_Eag|e_42

Chai—.

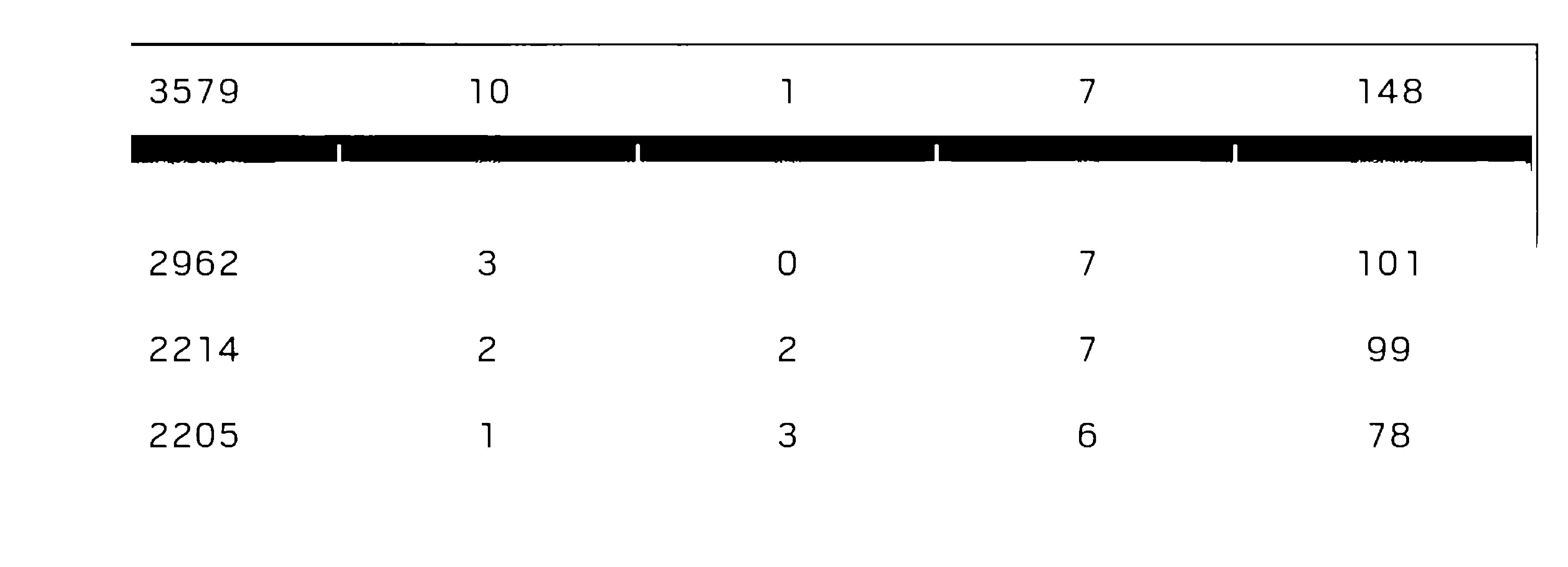

3579 10 1 7 148

2962 3 O 7 101

2214 2 2 7 99

2205 1 3 6 78

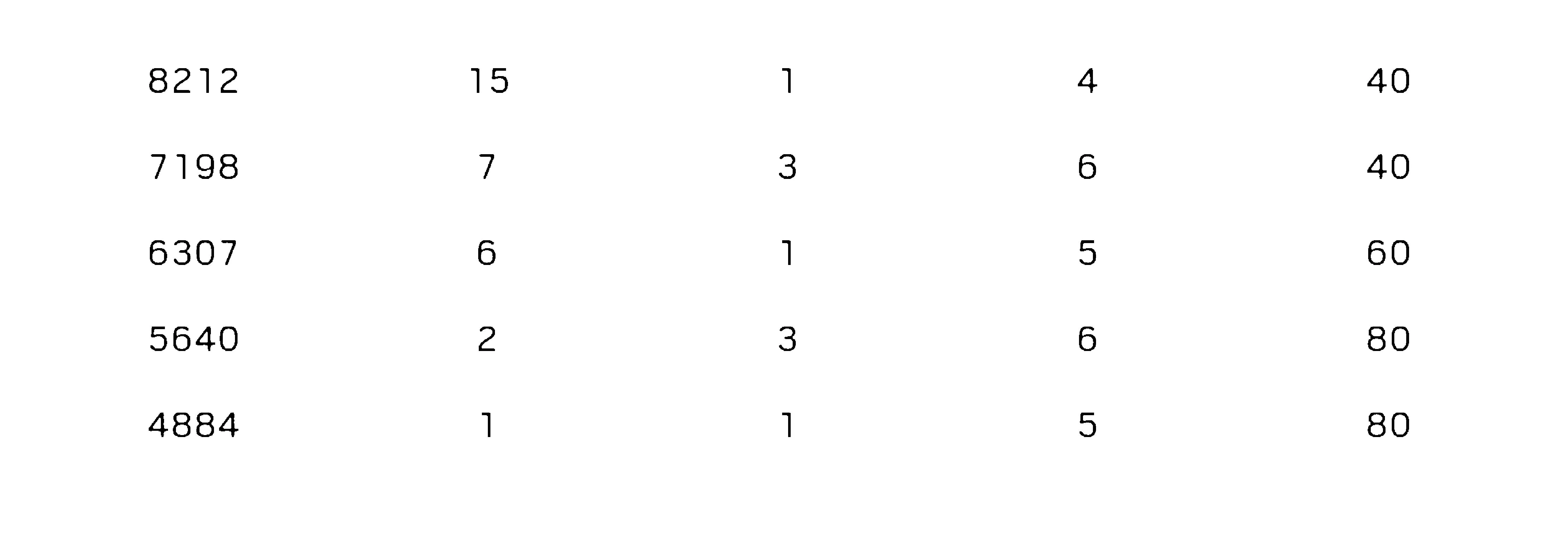

8212

7198

6307

5640

4884

15

40

40

6O

80

80

我只是在输出内容。

result = `pytesseract.image_to_string(Image.open("D:/newapproach/B&W"+str(i)+".jpg"),lang="New_Language")`

但我不知道如何继续以获得一致的结果。有没有办法让tesseract识别文本区域并使其扫描呢?因为在训练器(SunnyPage)中,tesseract默认识别扫描失败了一些区域,但是一旦我手动选择了所有内容,就可以正确地检测和转换为文本。