一般而言,

当我使用sklearn metrics包时,在文档页面上说:

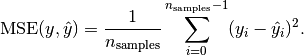

所有得分器对象都遵循高返回值优于低返回值的惯例。因此,像metrics.mean_squared_error这样测量模型与数据之间距离的指标可以作为neg_mean_squared_error使用,它返回指标的否定值。 http://scikit-learn.org/stable/modules/model_evaluation.html 并且 但是,如果我去这里:

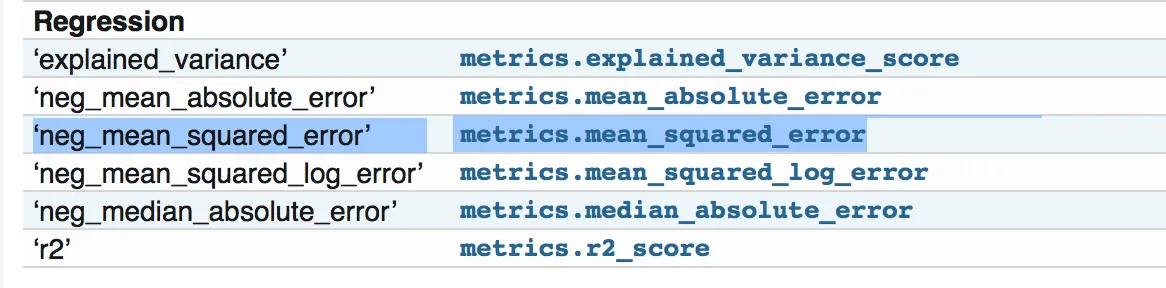

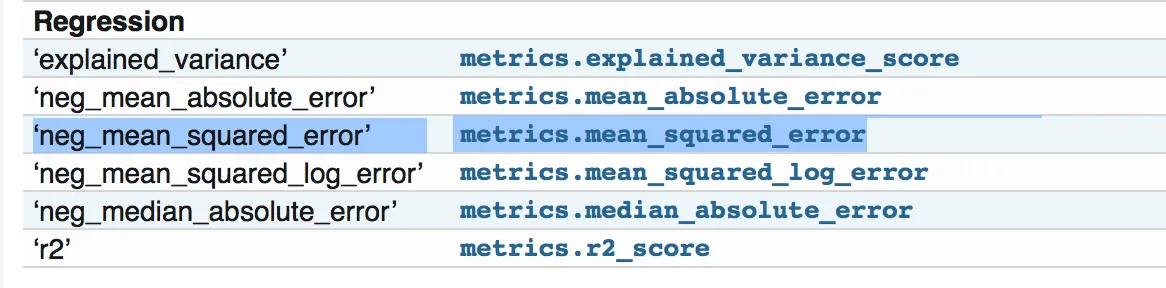

但是,如果我去这里:

它说它是

mean_squared_error越小越好。当我使用sklearn metrics包时,在文档页面上说:

所有得分器对象都遵循高返回值优于低返回值的惯例。因此,像metrics.mean_squared_error这样测量模型与数据之间距离的指标可以作为neg_mean_squared_error使用,它返回指标的否定值。 http://scikit-learn.org/stable/modules/model_evaluation.html 并且

但是,如果我去这里:

但是,如果我去这里:它说它是

均方误差回归损失,没有说它是否被否定。

http://scikit-learn.org/stable/modules/generated/sklearn.metrics.mean_squared_error.html#sklearn.metrics.mean_squared_error

如果我查看源代码并检查其中的示例:https://github.com/scikit-learn/scikit-learn/blob/a24c8b46/sklearn/metrics/regression.py#L183,它正在执行正常的均方误差,即越小越好。

所以我想知道我是否在文档中错过了否定部分。谢谢!