在https://keras.io/layers/recurrent/上,我发现LSTM层有一个

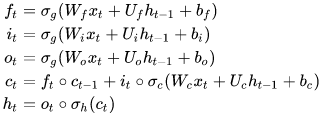

kernel和一个recurrent_kernel。它们的含义是什么?在我的理解中,我们需要为LSTM单元的4个门设置权重。然而,在Keras实现中,kernel的形状为(input_dim, 4*units),而recurrent_kernel的形状为(units, 4*units)。那么,它们两个是否都以某种方式实现了门控制呢?