I have a data frame (business_df) of schema:

|-- business_id: string (nullable = true)

|-- categories: array (nullable = true)

| |-- element: string (containsNull = true)

|-- city: string (nullable = true)

|-- full_address: string (nullable = true)

|-- hours: struct (nullable = true)

|-- name: string (nullable = true)

我希望创建一个新的数据框 (new_df),使得'name'列中的值不包含任何空格。

我的代码如下:

from pyspark import SparkContext

from pyspark.sql import SQLContext

from pyspark.sql import HiveContext

from pyspark.sql.functions import UserDefinedFunction

from pyspark.sql.types import StringType

udf = UserDefinedFunction(lambda x: x.replace(' ', ''), StringType())

new_df = business_df.select(*[udf(column).alias(name) if column == name else column for column in business_df.columns])

new_df.registerTempTable("vegas")

new_df.printSchema()

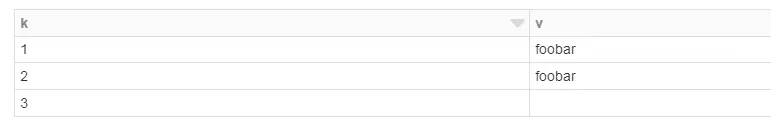

vegas_business = sqlContext.sql("SELECT stars, name from vegas limit 10").collect()

我一直收到这个错误:

NameError: 全局名称 'replace' 未定义

这段代码有什么问题?

UDF的 :( - Alberto Bonsanto