我是tensorflow的初学者,我想使用自己的数据(40x40大小的图像)调整MNIST教程https://www.tensorflow.org/tutorials/layers。这是我的模型函数:

def cnn_model_fn(features, labels, mode):

# Input Layer

input_layer = tf.reshape(features, [-1, 40, 40, 1])

# Convolutional Layer #1

conv1 = tf.layers.conv2d(

inputs=input_layer,

filters=32,

kernel_size=[5, 5],

# To specify that the output tensor should have the same width and height values as the input tensor

# value can be "same" ou "valid"

padding="same",

activation=tf.nn.relu)

# Pooling Layer #1

pool1 = tf.layers.max_pooling2d(inputs=conv1, pool_size=[2, 2], strides=2)

# Convolutional Layer #2 and Pooling Layer #2

conv2 = tf.layers.conv2d(

inputs=pool1,

filters=64,

kernel_size=[5, 5],

padding="same",

activation=tf.nn.relu)

pool2 = tf.layers.max_pooling2d(inputs=conv2, pool_size=[2, 2], strides=2)

# Dense Layer

pool2_flat = tf.reshape(pool2, [-1, 10 * 10 * 64])

dense = tf.layers.dense(inputs=pool2_flat, units=1024, activation=tf.nn.relu)

dropout = tf.layers.dropout(

inputs=dense, rate=0.4, training=mode == tf.estimator.ModeKeys.TRAIN)

# Logits Layer

logits = tf.layers.dense(inputs=dropout, units=2)

predictions = {

# Generate predictions (for PREDICT and EVAL mode)

"classes": tf.argmax(input=logits, axis=1),

# Add `softmax_tensor` to the graph. It is used for PREDICT and by the

# `logging_hook`.

"probabilities": tf.nn.softmax(logits, name="softmax_tensor")

}

if mode == tf.estimator.ModeKeys.PREDICT:

return tf.estimator.EstimatorSpec(mode=mode, predictions=predictions)

# Calculate Loss (for both TRAIN and EVAL modes)

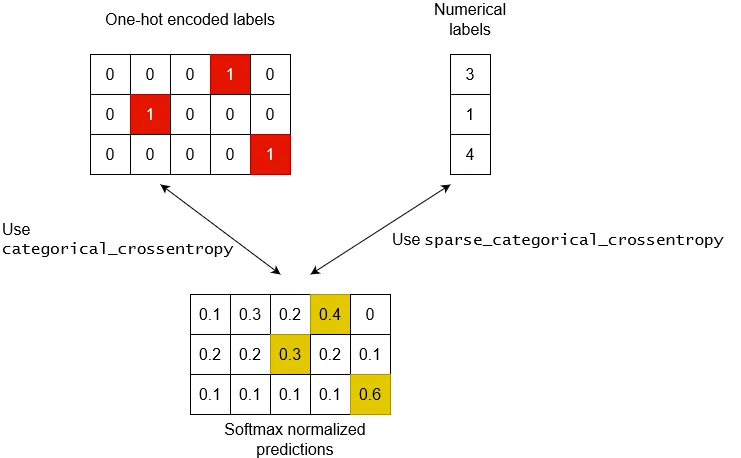

loss = tf.losses.sparse_softmax_cross_entropy(labels=labels, logits=logits)

# Configure the Training Op (for TRAIN mode)

if mode == tf.estimator.ModeKeys.TRAIN:

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.001)

train_op = optimizer.minimize(

loss=loss,

global_step=tf.train.get_global_step())

return tf.estimator.EstimatorSpec(mode=mode, loss=loss, train_op=train_op)

# Add evaluation metrics (for EVAL mode)

eval_metric_ops = {

"accuracy": tf.metrics.accuracy(

labels=labels, predictions=predictions["classes"])}

return tf.estimator.EstimatorSpec(

mode=mode, loss=loss, eval_metric_ops=eval_metric_ops)

InvalidArgumentError(有关详细信息,请参见上面的追溯):logits和labels必须具有相同的第一维,得到的logits形状为[3,2],标签形状为[1]

filenames_array是一个包含16个字符串的数组

["file1.png", "file2.png", "file3.png", ...]

并且 labels_array 是一个由16个整数组成的数组

[0,0,1,1,0,1,0,0,0,...]

主要功能是:

# Create the Estimator

mnist_classifier = tf.estimator.Estimator(model_fn=cnn_model_fn, model_dir="/tmp/test_convnet_model")

# Train the model

cust_train_input_fn = lambda: train_input_fn_custom(

filenames_array=filenames, labels_array=labels, batch_size=1)

mnist_classifier.train(

input_fn=cust_train_input_fn,

steps=20000,

hooks=[logging_hook])

我尝试重新调整logits的形状,但没有成功:

logits = tf.reshape(logits,[1, 2])

我需要你的帮助,谢谢

编辑

经过更多时间的搜索,在我的模型函数的第一行中:

input_layer = tf.reshape(features, [-1, 40, 40, 1])

“-1”代表批量大小的尺寸将动态计算,这里的值为“3”。这个“3”也出现在我的错误信息中:logits and labels must have the same first dimension, got logits shape [3,2] and labels shape [1]

如果我将这个值强制改为“1”,那么就会出现新的错误:

Input to reshape is a tensor with 4800 values, but the requested shape has 1600

可能是我的特征出了问题?

编辑2:

完整代码在此处:https://gist.github.com/geoffreyp/cc8e97aab1bff4d39e10001118c6322e

编辑3:

我已更新Gist。

logits = tf.layers.dense(inputs=dropout, units=1)

https://gist.github.com/geoffreyp/cc8e97aab1bff4d39e10001118c6322e

但是我并不完全理解您关于批次大小的答案,为什么批次大小可以是3,而我选择了批次大小为1?

如果我选择batch_size = 3,我会收到此错误: logits和labels必须具有相同的第一维,得到的logits形状为[9,1],标签形状为[3]

我尝试重新整形标签:

labels = tf.reshape(labels, [3, 1])

我更新了特征和标签的结构:

filenames_train = [['blackcorner-data/1.png', 'blackcorner-data/2.png', 'blackcorner-data/3.png',

'blackcorner-data/4.png', 'blackcorner-data/n1.png'],

['blackcorner-data/n2.png',

'blackcorner-data/n3.png', 'blackcorner-data/n4.png',

'blackcorner-data/11.png', 'blackcorner-data/21.png'],

['blackcorner-data/31.png',

'blackcorner-data/41.png', 'blackcorner-data/n11.png', 'blackcorner-data/n21.png',

'blackcorner-data/n31.png']

]

labels = [[0, 0, 0, 0, 1], [1, 1, 1, 0, 0], [0, 0, 1, 1, 1]]

但是没有成功...