这是我的代码。循环内的东西是有意义的。

library(foreach)

library(doParallel)

cl <- makeCluster(7)

registerDoParallel(cl)

elasticitylist = foreach(i=1:nhousehold) %dopar% {

pricedraws = out$betadraw[i,12,]

elasticitydraws[,,i]= probarray[,,i] %*% diag(pricedraws)

elasticitydraws[,,i] = elasticitydraws[,,i] * as.vector(medianpricemat)

}

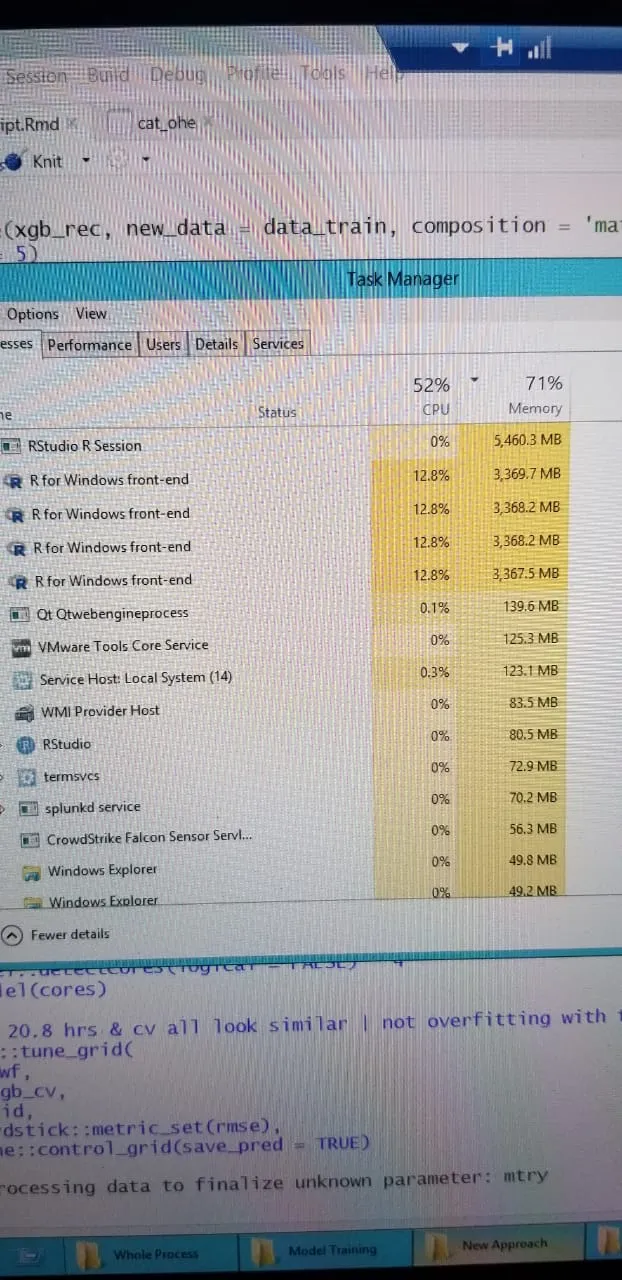

我一直收到这个错误:

Error in serialize(data, node$con) : error writing to connection

我知道我有足够的内核(有20个)。 有人能帮忙解决吗?看起来答案在文档中无处可寻!

当我在我的Unix服务器上运行ps -ef| grep user时,我会得到:

/apps/R.3.1.2/lib64/R/bin/exec/R --slave --no-restore -e parallel:::.slaveRSOCK() --args MASTER=localhost PORT=11025 OUT=/dev/null TIMEOUT=2592000 METHODS=TRUE XDR=TRUE