在训练两个不同的神经网络,一个使用Tensorflow,另一个使用Theano时,有时候会在随机时间(几小时或几分钟,通常是几小时)后执行冻结,并且我运行“nvidia-smi”时会收到以下消息:

"Unable to determine the device handle for GPU 0000:02:00.0: GPU is lost. Reboot the system to recover this GPU"

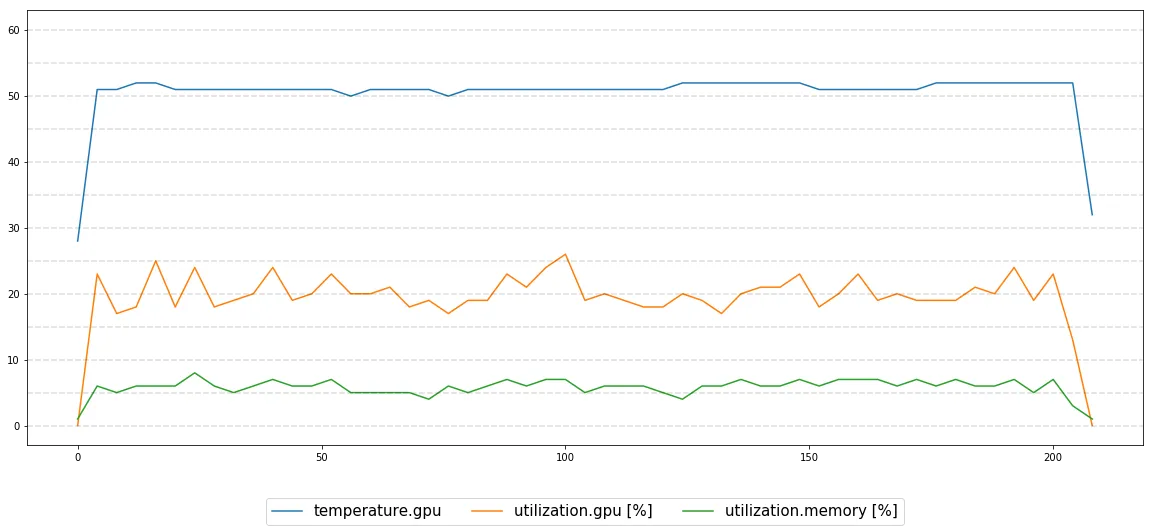

我尝试监控GPU性能进行了13小时的执行,一切似乎都很稳定:

我的工作环境如下:

- Ubuntu 14.04.5 LTS

- GPUs are Nvidia Titan Xp (在同一台机器上的另一个GPU上也有这种情况)

- CUDA 8.0

- CuDNN 5.1

- Tensorflow 1.3

- Theano 0.8.2

我不确定如何解决这个问题,请问有什么想法可以导致这种情况,并且如何诊断/解决这个问题?