假设这些ID是按照特定的宽度、高度、偏移量、间距等标准模板准备的,您可以尝试基于模板的方法来处理。检测MRZ会很容易。一旦您在图像中检测到它,找到将MRZ映射到您的模板的变换。当您知道这个变换时,您就可以将模板上的任何区域(例如个人的照片)映射到图像并提取该区域。

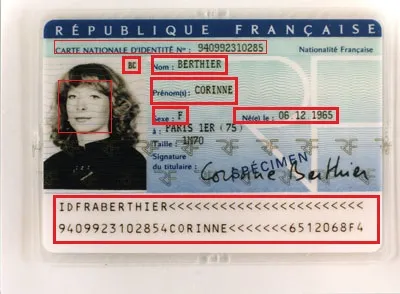

下面是一个非常简单的程序,遵循快乐路径。您需要进行更多的处理来普遍定位MRZ(例如,如果存在透视扭曲或旋转)。我只是通过测量图像来准备模板,它不适用于您的情况。我只想传达这个想法。图片来源于

维基百科。

Mat rgb = imread(INPUT_FILE);

Mat gray;

cvtColor(rgb, gray, CV_BGR2GRAY);

Mat grad;

Mat morphKernel = getStructuringElement(MORPH_ELLIPSE, Size(3, 3));

morphologyEx(gray, grad, MORPH_GRADIENT, morphKernel);

Mat bw;

threshold(grad, bw, 0.0, 255.0, THRESH_BINARY | THRESH_OTSU);

Mat connected;

morphKernel = getStructuringElement(MORPH_RECT, Size(9, 1));

morphologyEx(bw, connected, MORPH_CLOSE, morphKernel);

Mat mask = Mat::zeros(bw.size(), CV_8UC1);

vector<vector<Point>> contours;

vector<Vec4i> hierarchy;

findContours(connected, contours, hierarchy, CV_RETR_CCOMP, CV_CHAIN_APPROX_SIMPLE, Point(0, 0));

vector<Rect> mrz;

double r = 0;

for(int idx = 0; idx >= 0; idx = hierarchy[idx][0])

{

Rect rect = boundingRect(contours[idx]);

r = rect.height ? (double)(rect.width/rect.height) : 0;

if ((rect.width > connected.cols * .7) &&

(r > 25) &&

(r < 36)

)

{

mrz.push_back(rect);

rectangle(rgb, rect, Scalar(0, 255, 0), 1);

}

else

{

rectangle(rgb, rect, Scalar(0, 0, 255), 1);

}

}

if (2 == mrz.size())

{

CvRect max = cvMaxRect(&(CvRect)mrz[0], &(CvRect)mrz[1]);

rectangle(rgb, max, Scalar(255, 0, 0), 2);

vector<Point2f> mrzSrc;

vector<Point2f> mrzDst;

mrzDst.push_back(Point2f((float)max.x, (float)max.y));

mrzDst.push_back(Point2f((float)(max.x+max.width), (float)max.y));

mrzDst.push_back(Point2f((float)(max.x+max.width), (float)(max.y+max.height)));

mrzDst.push_back(Point2f((float)max.x, (float)(max.y+max.height)));

mrzSrc.push_back(Point2f(0.23f, 9.3f));

mrzSrc.push_back(Point2f(18.0f, 9.3f));

mrzSrc.push_back(Point2f(18.0f, 10.9f));

mrzSrc.push_back(Point2f(0.23f, 10.9f));

Mat t = getPerspectiveTransform(mrzSrc, mrzDst);

vector<Point2f> photoSrc;

photoSrc.push_back(Point2f(0.0f, 0.0f));

photoSrc.push_back(Point2f(5.66f, 0.0f));

photoSrc.push_back(Point2f(5.66f, 7.16f));

photoSrc.push_back(Point2f(0.0f, 7.16f));

vector<Point2f> surnameSrc;

surnameSrc.push_back(Point2f(6.4f, 0.7f));

surnameSrc.push_back(Point2f(8.96f, 0.7f));

surnameSrc.push_back(Point2f(8.96f, 1.2f));

surnameSrc.push_back(Point2f(6.4f, 1.2f));

vector<Point2f> photoDst(4);

vector<Point2f> surnameDst(4);

perspectiveTransform(photoSrc, photoDst, t);

perspectiveTransform(surnameSrc, surnameDst, t);

for (int i = 0; i < 4; i++)

{

line(rgb, photoDst[i], photoDst[(i+1)%4], Scalar(0,128,255), 2);

}

for (int i = 0; i < 4; i++)

{

line(rgb, surnameDst[i], surnameDst[(i+1)%4], Scalar(0,128,255), 2);

}

}

结果:照片和姓氏区域为橙色。MRZ为蓝色。