在将问题标记为复制或重复之前,请先阅读整个问题。

目前我能做到的如下:

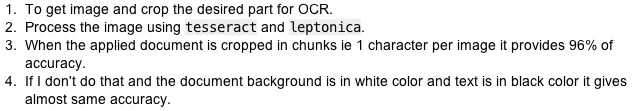

- 获取图像并裁剪所需的部分进行OCR。

- 使用

tesseract和leptonica处理图像。 - 当应用文档被裁剪成块,即每个图像1个字符时,提供96%的准确度。

- 如果我不这样做,并且文档背景是白色,文本是黑色,它会给出几乎相同的准确度。

例如,如果输入为此照片:

开始照片

结束照片

我想要的是能够获得相同的准确度,而无需生成块,就像这张照片一样

。

我用于初始化tesseract并从图像中提取文本的代码如下:

tesseract的init:

在 .h 文件中

tesseract::TessBaseAPI *tesseract;

uint32_t *pixels;

在 .m 文件中

tesseract = new tesseract::TessBaseAPI();

tesseract->Init([dataPath cStringUsingEncoding:NSUTF8StringEncoding], "eng");

tesseract->SetPageSegMode(tesseract::PSM_SINGLE_LINE);

tesseract->SetVariable("tessedit_char_whitelist", "0123456789ABCDEFGHIJKLMNOPQRSTUVWXYZ");

tesseract->SetVariable("language_model_penalty_non_freq_dict_word", "1");

tesseract->SetVariable("language_model_penalty_non_dict_word ", "1");

tesseract->SetVariable("tessedit_flip_0O", "1");

tesseract->SetVariable("tessedit_single_match", "0");

tesseract->SetVariable("textord_noise_normratio", "5");

tesseract->SetVariable("matcher_avg_noise_size", "22");

tesseract->SetVariable("image_default_resolution", "450");

tesseract->SetVariable("editor_image_text_color", "40");

tesseract->SetVariable("textord_projection_scale", "0.25");

tesseract->SetVariable("tessedit_minimal_rejection", "1");

tesseract->SetVariable("tessedit_zero_kelvin_rejection", "1");

- (void)processOcrAt:(UIImage *)image

{

[self setTesseractImage:image];

tesseract->Recognize(NULL);

char* utf8Text = tesseract->GetUTF8Text();

int conf = tesseract->MeanTextConf();

NSArray *arr = [[NSArray alloc]initWithObjects:[NSString stringWithUTF8String:utf8Text],[NSString stringWithFormat:@"%d%@",conf,@"%"], nil];

[self performSelectorOnMainThread:@selector(ocrProcessingFinished:)

withObject:arr

waitUntilDone:YES];

free(utf8Text);

}

- (void)ocrProcessingFinished0:(NSArray *)result

{

UIAlertView *alt = [[UIAlertView alloc]initWithTitle:@"Data" message:[result objectAtIndex:0] delegate:self cancelButtonTitle:nil otherButtonTitles:@"OK", nil];

[alt show];

}

但是我无法得到车牌图像的正确输出,它要么为空,要么为图像提供了一些垃圾数据。

如果我使用的是第一个图像,即白色背景和黑色文本,则输出结果的准确率为89%至95%。

请帮帮我。

任何建议都将不胜感激。

更新

感谢@jcesar提供链接,以及@konstantin pribluda提供宝贵信息和指导。

我能够将图像转换成适当的黑白形式(几乎),所以所有图像的识别效果更好了 :)

需要帮助处理图像的二值化。 有任何想法都将不胜感激。