我在Python中实现了Kosaraju的强连通分量(SCC)图搜索算法。

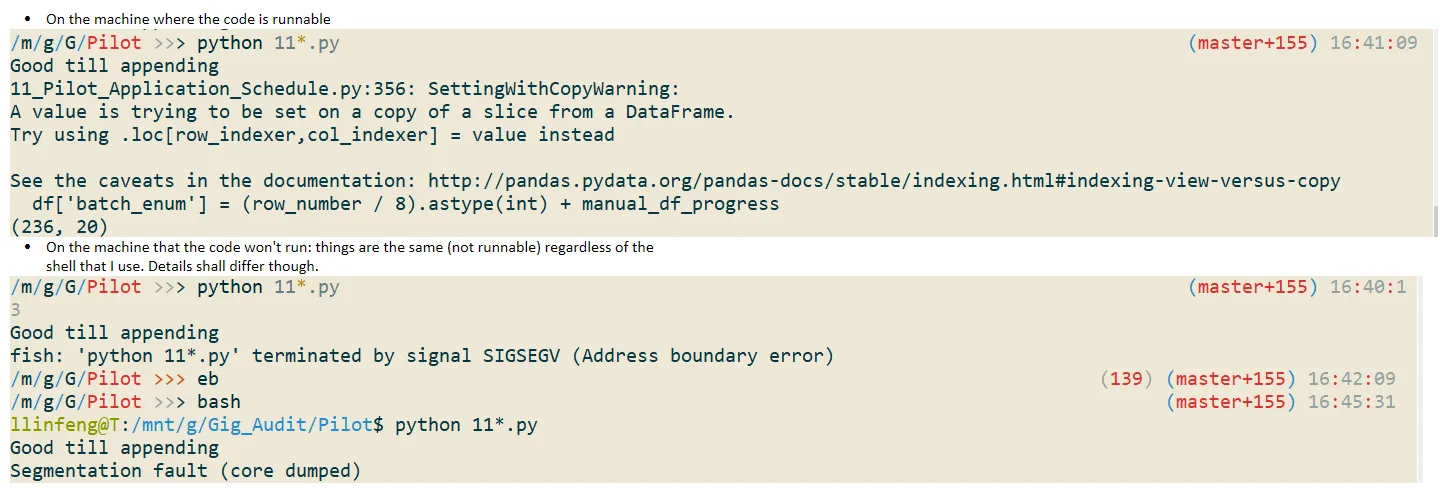

该程序对小数据集运行良好,但是当我在超大型图形上运行它(超过800,000个节点)时,会出现“分段错误”。

可能的原因是什么?谢谢!

附加信息: 当我在超大数据集上运行时,首先遇到了这个错误:

"RuntimeError: maximum recursion depth exceeded in cmp"

然后我使用以下代码重置递归限制:

sys.setrecursionlimit(50000)

但是出现了“分段错误”

相信我,这不是一个无限循环,在相对较小的数据上运行是正确的。可能是程序耗尽了资源吗?