有没有使用OpenCV进行反卷积的方法?

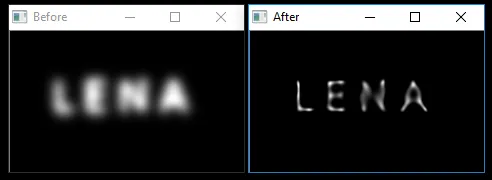

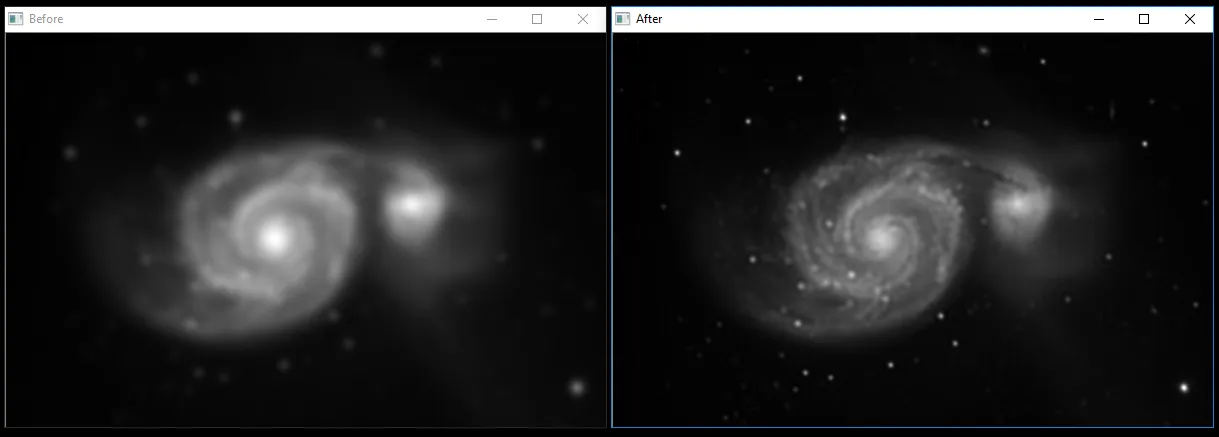

我对这里展示的改进印象深刻。

我希望将这个功能添加到我的软件中。编辑(奖励的额外信息):

我仍然没有弄清楚如何实现反卷积。这段代码帮助我锐化图像,但我认为反卷积可能会做得更好。

void ImageProcessing::sharpen(QImage & img)

{

IplImage* cvimg = createGreyFromQImage( img );

if ( !cvimg ) return;

IplImage* gsimg = cvCloneImage(cvimg );

IplImage* dimg = cvCreateImage( cvGetSize(cvimg), IPL_DEPTH_8U, 1 );

IplImage* outgreen = cvCreateImage( cvGetSize(cvimg), IPL_DEPTH_8U, 3 );

IplImage* zeroChan = cvCreateImage( cvGetSize(cvimg), IPL_DEPTH_8U, 1 );

cvZero(zeroChan);

cv::Mat smat( gsimg, false );

cv::Mat dmat( dimg, false );

cv::GaussianBlur(smat, dmat, cv::Size(0, 0), 3);

cv::addWeighted(smat, 1.5, dmat, -0.5 ,0, dmat);

cvMerge( zeroChan, dimg, zeroChan, NULL, outgreen);

img = IplImage2QImage( outgreen );

cvReleaseImage( &gsimg );

cvReleaseImage( &cvimg );

cvReleaseImage( &dimg );

cvReleaseImage( &outgreen );

cvReleaseImage( &zeroChan );

}

希望能得到有用的提示!