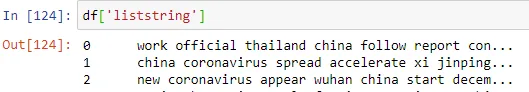

我正在尝试获取每个文档中TF-IDF得分最高的前10个单词。在我的数据框中,有一列包含了经过预处理的文本(没有标点符号、停用词等)来自于不同文档的。在这个例子中,每一行代表一个文档。

它有超过500行,我对每行中最重要的单词很好奇。

所以我运行了以下代码:

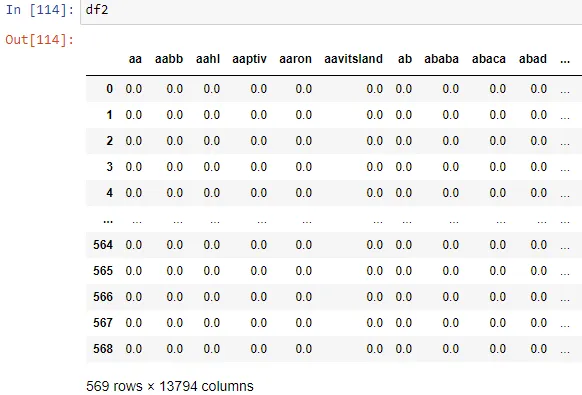

这给了我一个TF-IDF矩阵: 我的问题是,我如何收集具有最高TF-IDF值的前10个单词?在我的原始数据框(df)中创建一个包含每行前10个单词的列会很好,但也要知道哪些单词在总体上最重要。

所以我运行了以下代码:

from sklearn.feature_extraction.text import TfidfVectorizer

vectorizer = TfidfVectorizer()

vectors = vectorizer.fit_transform(df['liststring'])

feature_names = vectorizer.get_feature_names()

dense = vectors.todense()

denselist = dense.tolist()

df2 = pd.DataFrame(denselist, columns=feature_names)

这给了我一个TF-IDF矩阵: 我的问题是,我如何收集具有最高TF-IDF值的前10个单词?在我的原始数据框(df)中创建一个包含每行前10个单词的列会很好,但也要知道哪些单词在总体上最重要。