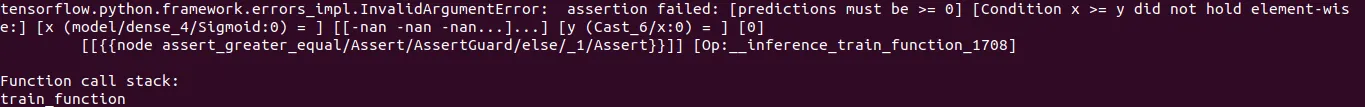

我正在运行一个多类模型(总共有40个类),共2000个epoch。这个模型在第828个epoch之前一直很好地运行,但是在第829个epoch时出现了InvalidArgumentError(如下面的屏幕截图所示)。

以下是我用来构建模型的代码。

n_cats = 40

input_bow = tf.keras.Input(shape=(40), name="bow")

hidden_1 = tf.keras.layers.Dense(200, activation="relu")(input_bow)

hidden_2 = tf.keras.layers.Dense(100, activation="relu")(hidden_1)

hidden_3 = tf.keras.layers.Dense(80, activation="relu")(hidden_2)

hidden_4 = tf.keras.layers.Dense(70, activation="relu")(hidden_3)

output = tf.keras.layers.Dense(n_cats, activation="sigmoid")(hidden_4)

model = tf.keras.Model(inputs=[input_bow], outputs=output)

METRICS = [

tf.keras.metrics.Accuracy(name="Accuracy"),

tf.keras.metrics.Precision(name="precision"),

tf.keras.metrics.Recall(name="recall"),

tf.keras.metrics.AUC(name="auc"),

tf.keras.metrics.BinaryAccuracy(name="binaryAcc")

]

checkpoint_cb = tf.keras.callbacks.ModelCheckpoint(

"my_keras_model.h5", save_best_only=True)

lr_schedule = tf.keras.optimizers.schedules.ExponentialDecay(initial_learning_rate=1e-2,

decay_steps=10000,

decay_rate=0.9)

adam_optimizer = tf.keras.optimizers.Adam(learning_rate=lr_schedule)

model.compile(loss="categorical_crossentropy",

optimizer="adam", metrics=METRICS)

training_history = model.fit(

(bow_train),

indus_cat_train,

epochs=2000,

batch_size=128,

callbacks=[checkpoint_cb],

validation_data=(bow_test, indus_cat_test))

请帮助我理解TensorFlow的这种行为。是什么导致了这个错误?我已经阅读了这篇文章和这篇文章,但在我的情况下,它们似乎都不是正确的解释。