我正在使用TensorFlow的全新目标检测API进行实验,并决定在其他公开可用的数据集上进行训练。我偶然发现了这个杂货数据集,其中包含超市货架上各种品牌香烟盒的图像,以及一个文本文件,列出了每个图像中每个香烟盒的边界框。该数据集标记了10个主要品牌,所有其他品牌都属于第11个“杂项”类别。

我按照他们的教程进行操作,并在此数据集上训练了模型。由于处理能力有限,我仅使用了数据集的三分之一,并将70:30拆分为训练和测试数据。我使用了faster_rcnn_resnet101模型。我的配置文件中的所有参数与TF提供的默认参数相同。

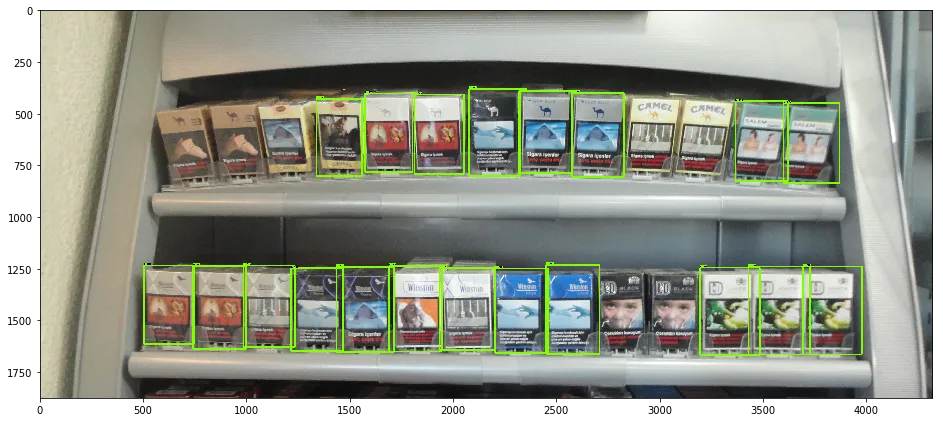

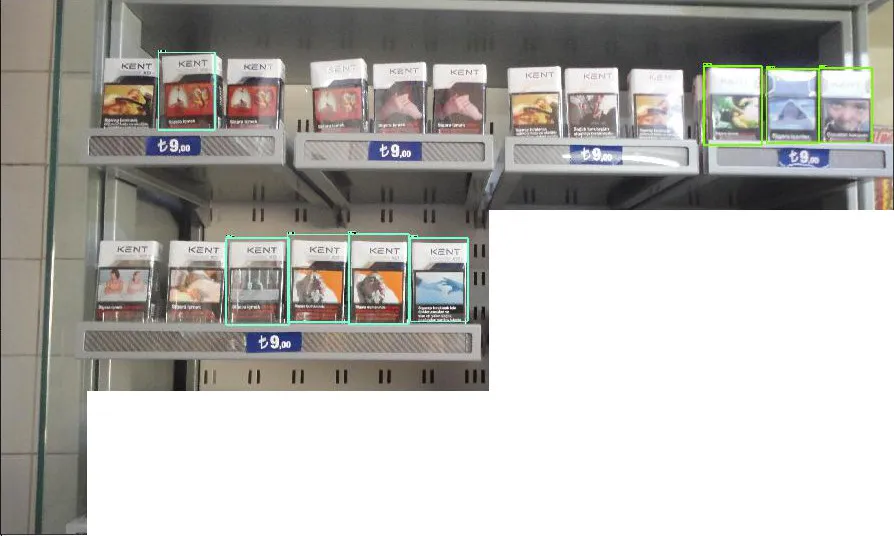

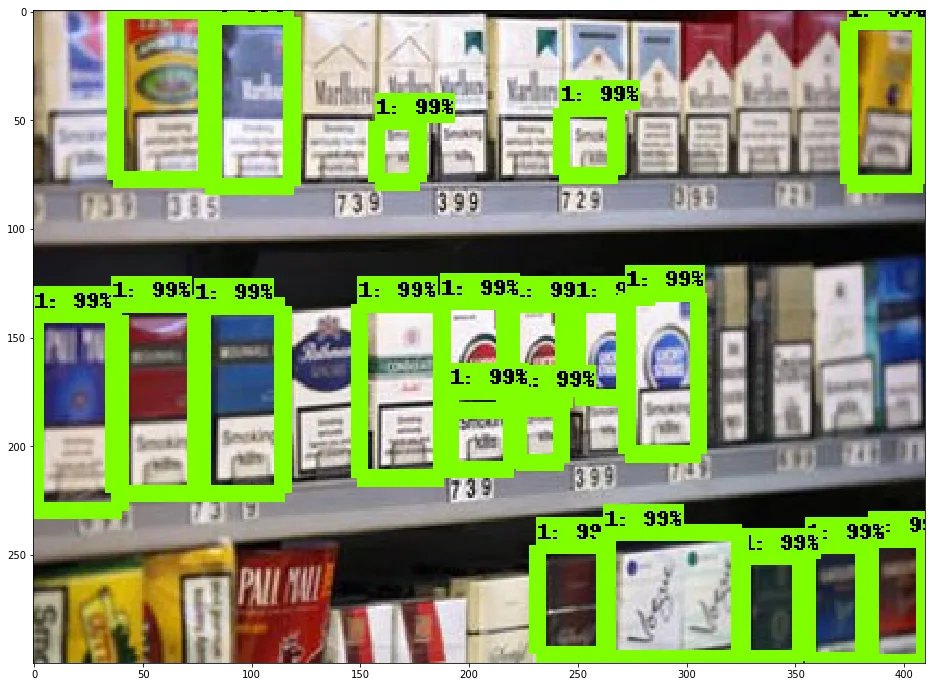

经过16491个全局步骤后,我对一些图像进行了测试,但结果并不太满意 -

我按照他们的教程进行操作,并在此数据集上训练了模型。由于处理能力有限,我仅使用了数据集的三分之一,并将70:30拆分为训练和测试数据。我使用了faster_rcnn_resnet101模型。我的配置文件中的所有参数与TF提供的默认参数相同。

经过16491个全局步骤后,我对一些图像进行了测试,但结果并不太满意 -

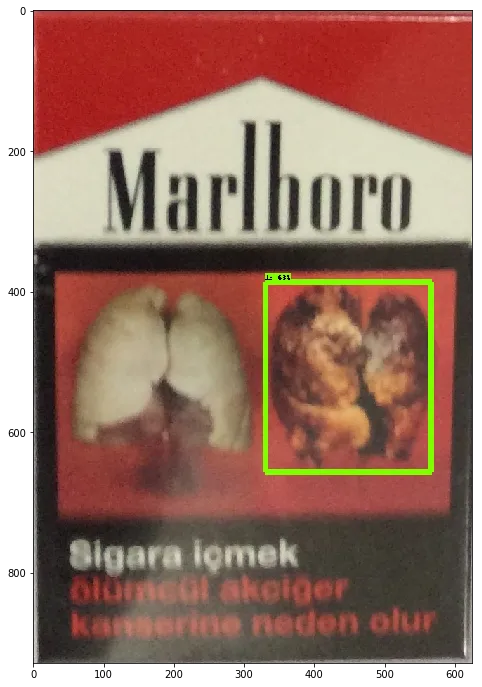

我遇到的另一个问题是该模型从未检测到除标签1以外的任何其他标签

我遇到的另一个问题是该模型从未检测到除标签1以外的任何其他标签

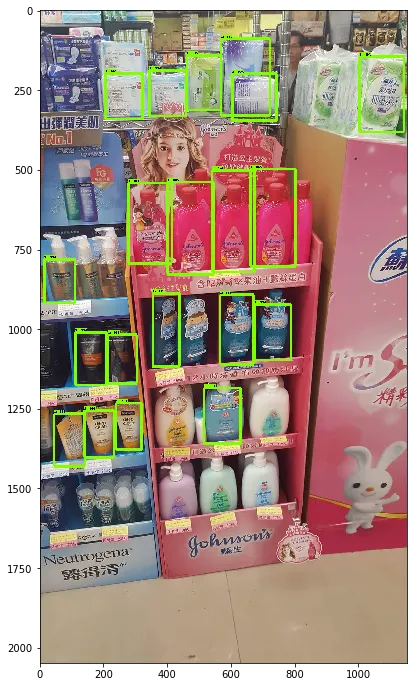

未在训练数据中检测到产品的任何种植实例

它即使在负面图像中也能以99%的置信度检测到香烟盒!有人能帮助我找出问题吗?我该怎么提高准确性?为什么它会将所有产品都检测为类别1,尽管我已经提到总共有11个类别?编辑:添加了我的标签映射:item {

id: 1

name: '1'

}

item {

id: 2

name: '2'

}

item {

id: 3

name: '3'

}

item {

id: 4

name: '4'

}

item {

id: 5

name: '5'

}

item {

id: 6

name: '6'

}

item {

id: 7

name: '7'

}

item {

id: 8

name: '8'

}

item {

id: 9

name: '9'

}

item {

id: 10

name: '10'

}

item {

id: 11

name: '11'

}