我在想:在多层前馈神经网络中,输入层是否应该包括偏置神经元,或者这仅对隐藏层有用?如果是这样,为什么?

1个回答

11

不需要将输入层连接到偏置神经元,因为它从偏置神经元接收的任何激活都将被实际输入完全覆盖。

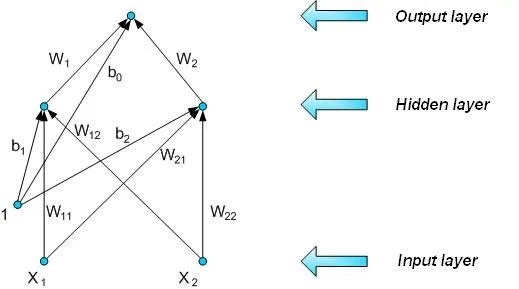

例如,想象一个使用以下架构(其中标记为1的神经元是偏置)来解决经典XOR问题的网络:

例如,想象一个使用以下架构(其中标记为1的神经元是偏置)来解决经典XOR问题的网络:

要在输入(1,0)上运行此网络,您只需夹紧神经元X1=1和X2=0的激活。现在,如果X1或X2也从偏置接收到输入,则该输入将被覆盖,使得这样的连接毫无意义。

- zergylord

4

1对不起,根据您的绘图,偏置神经元是输入层的一部分,因为它被传递到隐藏层,我理解得对吗? - tunnuz

嗯,有点吧。偏置神经元通常被描绘为在自己的小层中。我以为你的问题是关于是否将偏置单元连接到输入层中的单元。无论哪种情况,答案都是坚定的否定;你只需要一个具有恒定激活并位于自己层中的偏置单元。通常它连接到所有非输入层。 - zergylord

更多解释请参见此问题:https://dev59.com/pmw05IYBdhLWcg3wiybg。此外,这不是我的图表,而是我从这里获取的:http://home.agh.edu.pl/~vlsi/AI/xor_t/en/main.htm。 - zergylord

上图中的输入X1、X2实际上不是神经元,它们只是输入。每个真正的神经元(接收输入、具有权重、激活函数和计算能力)都应该有一个偏置。从数学上讲,每个神经元计算φ(b + x1 w1 + x2 w2 + ... + xn wn),其中b是偏置。但xi只是数字,你不能将它们“连接”到任何东西上。 - Panayiotis Karabassis

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接