我在使用Scikit-learn的GaussianProcessRegressor进行回归操作时,使用了平方指数核或RBF。此外,我还使用内部可用的优化器

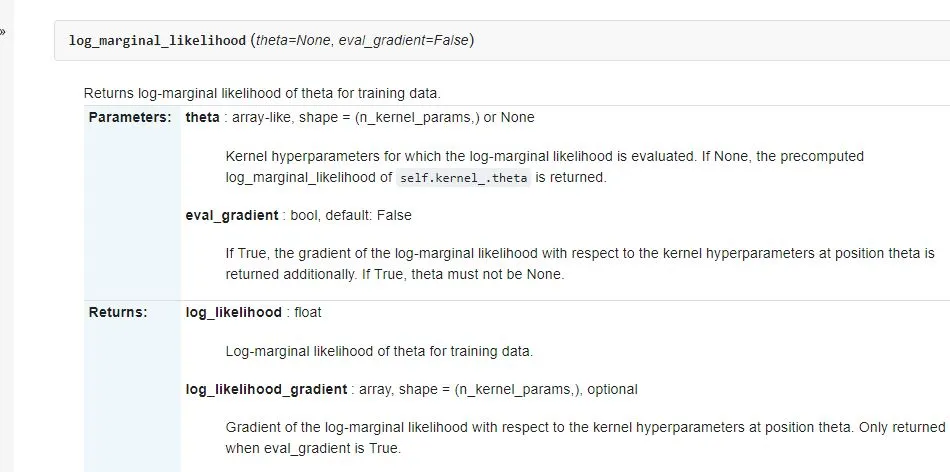

'fmin_l_bfgs_b'(L-BFGS-B算法)来优化核参数。在我的情况下,核参数是长度尺度和信号方差。关于log_marginal_likelihood的文档如下:

我按照这份文档打印了GPML kernel和log_marginal_likelihood。以下是代码片段:

print("GPML kernel: %s" % gp.kernel_)

print("Log-marginal-likelihood:",

gp.log_marginal_likelihood(gp.kernel_.theta, eval_gradient = True))

以下值将在控制台打印:

GPML kernel: 31.6**2 * RBF(length_scale=1.94)

Log-marginal-likelihood: (-115.33295413296841, array([ 1.01038168e+02, -2.16465175e-07]))

在这里,我无法理解Log-marginal-likelihood打印的值。数组中的值是什么?

我关于回归的代码片段如下:

x_train = np.array([[0,0],[2,2],[3,3]])

y_train = np.array([200,321,417])

xvalues = np.array([0,1,2,3])

yvalues = np.array([0,1,2,3])

a,b = np.meshgrid(xvalues,yvalues)

positions = np.vstack([a.ravel(), b.ravel()])

x_test = (np.array(positions)).T

kernel = C(1.0, (1e-3, 1e3)) * RBF(10)

gp = GaussianProcessRegressor(kernel=kernel, optimizer = 'fmin_l_bfgs_b',alpha = 1.5, n_restarts_optimizer=5)

gp.fit(x_train, y_train)

y_pred_test, sigma = gp.predict(x_test, return_std =True)

我的打印内核参数的方法正确吗?

谢谢!