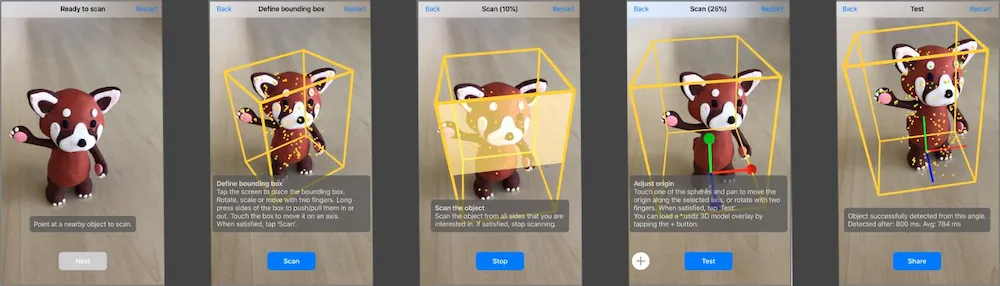

ARKit应用程序允许我们创建 ARReferenceObject ,并使用它,我们可以可靠地识别现实世界对象的位置和方向。但是我们也可以保存完成的 .arobject 文件。

然而, ARReferenceObject 仅包含ARKit识别现实世界对象所需的空间特征信息,并不是该对象的可显示3D重建。

func createReferenceObject(transform: simd_float4x4,

center: simd_float3,

extent: simd_float3,

completionHandler: (ARReferenceObject?, Error?) -> Void)

我的问题:

是否有一种方法可以使用Poisson面重建或摄影测量法从.arobject文件中重构数字3D几何(低细节或高细节)?