我使用GCC和Clang的向量扩展,将OP的代码向量化。在展示如何进行向量化之前,让我先展示以下硬件的性能:

Skylake (SKL) at 3.1 GHz with 4 cores

Knights Landing (KNL) at 1.5 GHz with 68 cores

ARMv8 Cortex-A57 arch64 (Nvidia Jetson TX1) 4 cores at ? GHz

nb_iter = 1000000

GCC Clang

SKL_scalar 6m5,422s

SKL_SSE41 3m18,058s

SKL_AVX2 1m37,843s 1m39,943s

SKL_scalar_omp 0m52,237s

SKL_SSE41_omp 0m29,624s 0m31,356s

SKL_AVX2_omp 0m14,156s 0m16,783s

ARM_scalar 15m28.285s

ARM_vector 9m26.384s

ARM_scalar_omp 3m54.242s

ARM_vector_omp 2m21.780s

KNL_scalar 19m34.121s

KNL_SSE41 11m30.280s

KNL_AVX2 5m0.005s 6m39.568s

KNL_AVX512 2m40.934s 6m20.061s

KNL_scalar_omp 0m9.108s

KNL_SSE41_omp 0m6.666s 0m6.992s

KNL_AVX2_omp 0m2.973s 0m3.988s

KNL_AVX512_omp 0m1.761s 0m3.335s

KNL相对于SKL的理论加速比为

(68 cores/4 cores)*(1.5 GHz/3.1 Ghz)*

(8 doubles per lane/4 doubles per lane) = 16.45

我详细介绍了GCC和Clang的向量扩展功能

在这里。为了将OP的代码向量化,我们需要定义三个额外的向量操作。

1. 广播

对于向量

v和标量

s,GCC无法执行

v = s,但Clang可以。但我发现了一种不错的解决方案,适用于GCC和Clang

在这里。例如:

vsi v = s - (vsi){}

2. 一个类似于OpenCL中的any()函数或者像R中的。

我想到的最好的方式是创建一个通用函数。

static bool any(vli const & x) {

for(int i=0; i<VLI_SIZE; i++) if(x[i]) return true;

return false;

}

Clang实际上使用

ptest指令为此生成相对

高效的代码(但

不适用于AVX512),但GCC则不是这样。

3. 压缩

计算使用64位双精度浮点数完成,但结果会写成32位整数。因此,使用64位整数进行了两次计算,然后将这两个计算压缩成一个32位整数向量。我想出了一种通用解决方案,Clang做得很好。

static vsi compress(vli const & lo, vli const & hi) {

vsi lo2 = (vsi)lo, hi2 = (vsi)hi, z;

for(int i=0; i<VLI_SIZE; i++) z[i+0*VLI_SIZE] = lo2[2*i];

for(int i=0; i<VLI_SIZE; i++) z[i+1*VLI_SIZE] = hi2[2*i];

return z;

}

以下解决方案在GCC上效果更好,但对于Clang来说并没有改善。但由于此函数不是关键性的,我只使用通用版本。

static vsi compress(vli const & low, vli const & high) {

#if defined(__clang__)

return __builtin_shufflevector((vsi)low, (vsi)high, MASK);

#else

return __builtin_shuffle((vsi)low, (vsi)high, (vsi){MASK});

#endif

}

这些定义不依赖于任何x86特定的内容,下面定义的代码也可以在ARM处理器上使用GCC和Clang编译。

现在这些已经定义好了,下面是代码。

#include <string.h>

#include <inttypes.h>

#include <Rcpp.h>

using namespace Rcpp;

#ifdef _OPENMP

#include <omp.h>

#endif

#if defined ( __AVX512F__ ) || defined ( __AVX512__ )

static const int SIMD_SIZE = 64;

#elif defined ( __AVX2__ )

static const int SIMD_SIZE = 32;

#else

static const int SIMD_SIZE = 16;

#endif

static const int VSI_SIZE = SIMD_SIZE/sizeof(int32_t);

static const int VLI_SIZE = SIMD_SIZE/sizeof(int64_t);

static const int VDF_SIZE = SIMD_SIZE/sizeof(double);

#if defined(__clang__)

typedef int32_t vsi __attribute__ ((ext_vector_type(VSI_SIZE)));

typedef int64_t vli __attribute__ ((ext_vector_type(VLI_SIZE)));

typedef double vdf __attribute__ ((ext_vector_type(VDF_SIZE)));

#else

typedef int32_t vsi __attribute__ ((vector_size (SIMD_SIZE)));

typedef int64_t vli __attribute__ ((vector_size (SIMD_SIZE)));

typedef double vdf __attribute__ ((vector_size (SIMD_SIZE)));

#endif

static bool any(vli const & x) {

for(int i=0; i<VLI_SIZE; i++) if(x[i]) return true;

return false;

}

static vsi compress(vli const & lo, vli const & hi) {

vsi lo2 = (vsi)lo, hi2 = (vsi)hi, z;

for(int i=0; i<VLI_SIZE; i++) z[i+0*VLI_SIZE] = lo2[2*i];

for(int i=0; i<VLI_SIZE; i++) z[i+1*VLI_SIZE] = hi2[2*i];

return z;

}

IntegerVector frac(double x_min, double x_max, double y_min, double y_max, int res_x, int res_y, int nb_iter) {

IntegerVector out(res_x*res_y);

vdf x_minv = x_min - (vdf){}, y_minv = y_min - (vdf){};

vdf x_stepv = (x_max - x_min)/res_x - (vdf){}, y_stepv = (y_max - y_min)/res_y - (vdf){};

double a[VDF_SIZE] __attribute__ ((aligned(SIMD_SIZE)));

for(int i=0; i<VDF_SIZE; i++) a[i] = 1.0*i;

vdf vi0 = *(vdf*)a;

#pragma omp parallel for schedule(dynamic) collapse(2)

for (int r = 0; r < res_y; r++) {

for (int c = 0; c < res_x/(VSI_SIZE); c++) {

vli nv[2] = {0 - (vli){}, 0 - (vli){}};

for(int j=0; j<2; j++) {

vdf c2 = 1.0*VDF_SIZE*(2*c+j) + vi0;

vdf zx = 0.0 - (vdf){}, zy = 0.0 - (vdf){}, new_zx;

vdf cx = x_minv + c2*x_stepv, cy = y_minv + r*y_stepv;

vli t = -1 - (vli){};

for (int n = 0; any(t = zx*zx + zy*zy < 4.0) && n < nb_iter; n++, nv[j] -= t) {

new_zx = zx*zx - zy*zy + cx;

zy = 2.0*zx*zy + cy;

zx = new_zx;

}

}

vsi sp = compress(nv[0], nv[1]);

memcpy(&out[r*res_x + VSI_SIZE*c], (int*)&sp, SIMD_SIZE);

}

}

return out;

}

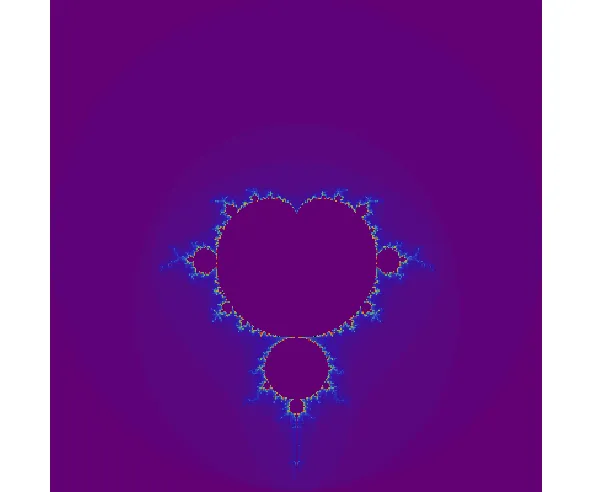

这段 R 代码几乎与原帖作者的代码相同

library(Rcpp)

sourceCpp("frac.cpp", verbose=TRUE, rebuild=TRUE)

xlims=c(-0.74877,-0.74872);

ylims=c(0.065053,0.065103);

x_res=y_res=1080L; nb_iter=100000L;

t = system.time(m <- frac(xlims[[1]], xlims[[2]], ylims[[1]], ylims[[2]], x_res, y_res, nb_iter))

print(t)

m2 = matrix(m, ncol = x_res)

rainbow = c(

rgb(0.47, 0.11, 0.53),

rgb(0.27, 0.18, 0.73),

rgb(0.25, 0.39, 0.81),

rgb(0.30, 0.57, 0.75),

rgb(0.39, 0.67, 0.60),

rgb(0.51, 0.73, 0.44),

rgb(0.67, 0.74, 0.32),

rgb(0.81, 0.71, 0.26),

rgb(0.89, 0.60, 0.22),

rgb(0.89, 0.39, 0.18),

rgb(0.86, 0.13, 0.13)

)

cols = c(colorRampPalette(rainbow)(100),

rev(colorRampPalette(rainbow)(100)),"black")

par(mar = c(0, 0, 0, 0))

image(m2^(1/7), col=cols, asp=diff(ylims)/diff(xlims), axes=F, useRaster=T)

如需为GCC或Clang编译,请更改文件~/.R/Makevars中的内容为:

CXXFLAGS= -Wall -std=c++14 -O3 -march=native -ffp-contract=fast -fopenmp

如果您在Clang上无法使用OpenMP,请参见this。

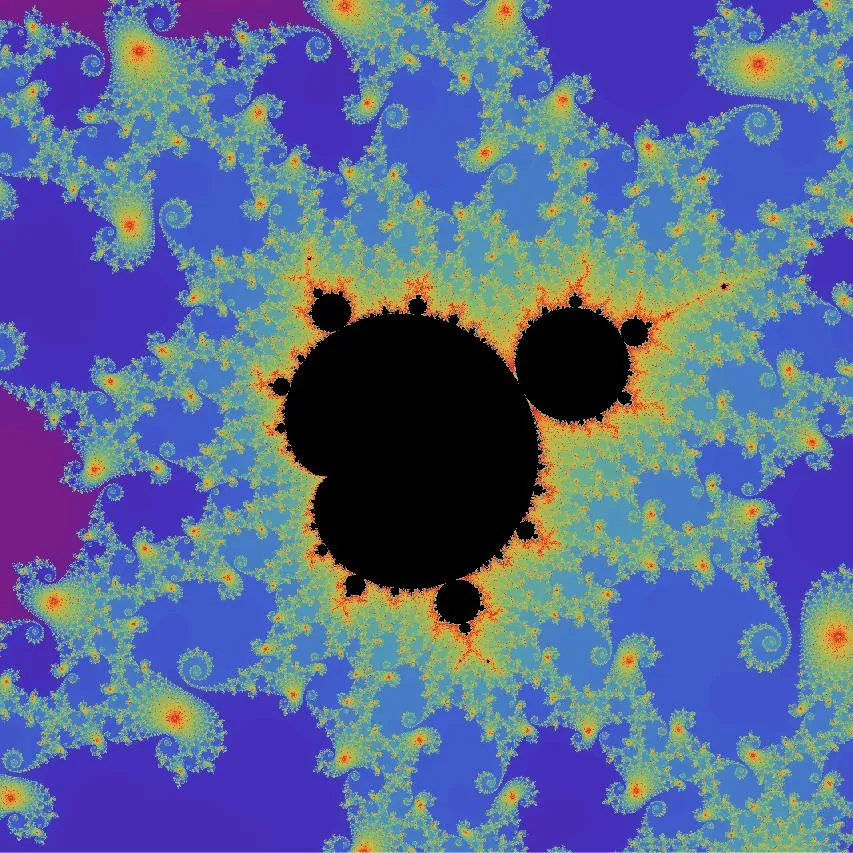

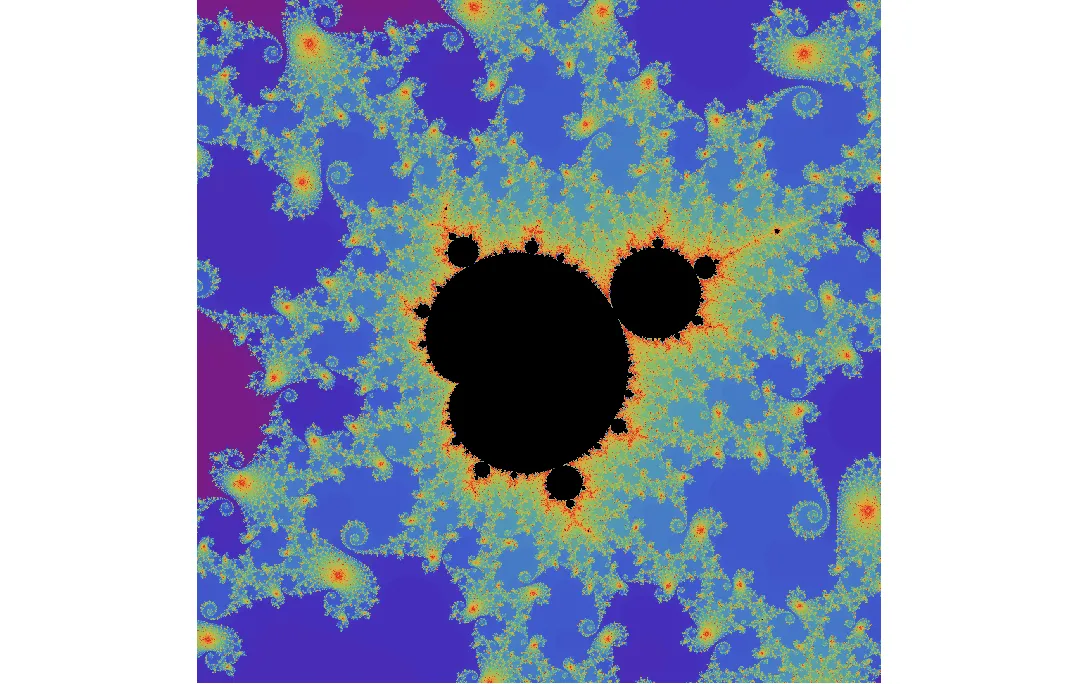

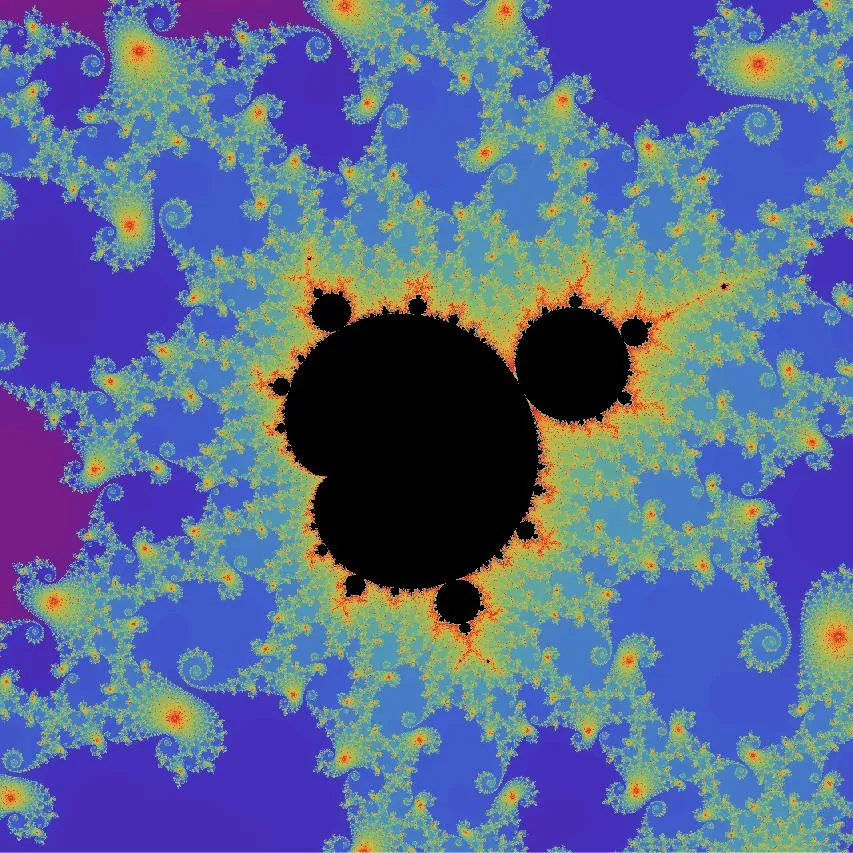

这段代码生成的图像与原图几乎相同。