Lighthouse读取我的网站主页而非robots.txt文件

5

- Pierre Olivier Tran

2

你是否正在使用服务器端渲染你的应用? - Lazar Nikolic

@LazarNikolic 是的 - Pierre Olivier Tran

1个回答

1

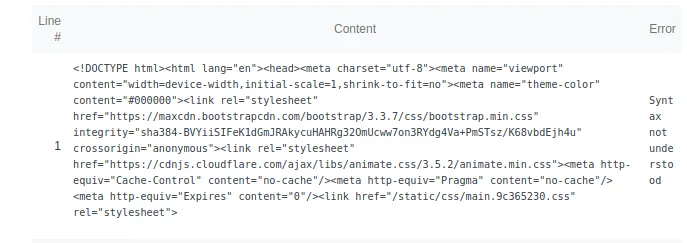

如果您使用Node和Express来在生产环境中运行React应用程序项目,并且您的服务器文件代码如下片段所示,那么这意味着您为所有请求(路由)提供相同的文件。在Lighthouse审核期间,浏览器会向http://localhost:5000/robots.txt发出GET请求,然后返回index.html。

为解决这个问题,您可以在上述代码片段之前添加如下路由以处理robots.txt文件。

app.get('/*', function (req, res) {

res.sendFile(path.join(__dirname, 'build', 'index.html'));

});

为解决这个问题,您可以在上述代码片段之前添加如下路由以处理robots.txt文件。

app.get('/robots.txt', function (req, res) {

res.sendFile(path.join(__dirname, 'build', 'robots.txt'));

});

app.get('/*', function (req, res) {

res.sendFile(path.join(__dirname, 'build', 'index.html'));

});

- Hanuman Singh

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

- 相关问题

- 4 Umbraco的Robots.txt文件

- 3 Nuxt3 Robots.txt - @nuxtjs/robots未生成robots.txt文件

- 7 虽然文件可访问,但"Lighthouse无法下载robots.txt文件"

- 5 我该如何修改Plone中的robots.txt文件?

- 4 谷歌无法读取我在S3上的robots.txt文件

- 3 谷歌忽略我的robots.txt文件

- 24 同一网站不同域名的robots.txt文件

- 4 如何在Puppeteer登录后运行Lighthouse以评估主页

- 7 在我的ASP.NET MVC网站中创建robots.txt文件的最佳实践

- 3 网站地图索引和robots.txt文件中的.gz文件引用