当涉及元素的实例化和检索时,元组和列表之间是否有性能差异?

Python中,元组是否比列表更高效?

2

概述

在几乎所有方面,元组比列表表现更好。

元组可以进行常量折叠。

元组可以被重复使用而不是被复制。

元组紧凑且不会过度分配内存。

元组直接引用其元素。

元组可以进行常量折叠

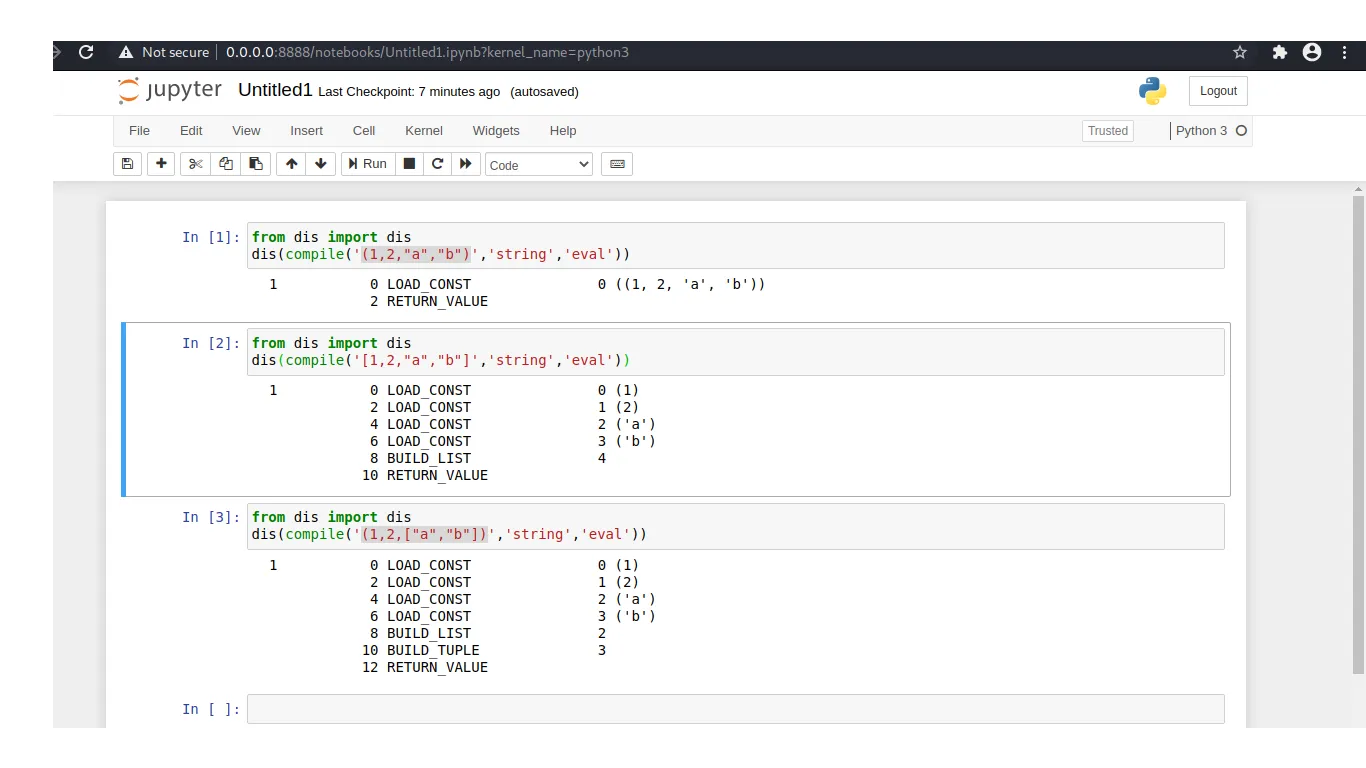

Python的Peephole优化器或AST优化器可以预计算常量元组。相反,列表则需要从头开始构建:

>>> from dis import dis

>>> dis(compile("(10, 'abc')", '', 'eval'))

1 0 LOAD_CONST 2 ((10, 'abc'))

3 RETURN_VALUE

>>> dis(compile("[10, 'abc']", '', 'eval'))

1 0 LOAD_CONST 0 (10)

3 LOAD_CONST 1 ('abc')

6 BUILD_LIST 2

9 RETURN_VALUE

元组不需要被复制

运行tuple(some_tuple)会立即返回它本身。由于元组是不可变的,所以不需要复制:

>>> a = (10, 20, 30)

>>> b = tuple(a)

>>> a is b

True

相比之下,list(some_list) 需要将所有数据复制到一个新的列表中:

>>> a = [10, 20, 30]

>>> b = list(a)

>>> a is b

False

元组不会过度分配

由于元组的大小是固定的,因此可以比需要过度分配以使append()操作高效的列表更紧凑地存储。

这使得元组具有很好的空间优势:

>>> import sys

>>> sys.getsizeof(tuple(iter(range(10))))

128

>>> sys.getsizeof(list(iter(range(10))))

200

下面是位于Objects/listobject.c的注释,解释了列表的作用:

/* This over-allocates proportional to the list size, making room

* for additional growth. The over-allocation is mild, but is

* enough to give linear-time amortized behavior over a long

* sequence of appends() in the presence of a poorly-performing

* system realloc().

* The growth pattern is: 0, 4, 8, 16, 25, 35, 46, 58, 72, 88, ...

* Note: new_allocated won't overflow because the largest possible value

* is PY_SSIZE_T_MAX * (9 / 8) + 6 which always fits in a size_t.

*/

元组直接引用它们的元素

元组对象中直接包含了对象的引用。相比之下,列表具有额外的间接层来指向外部指针数组。

这使得元组在索引查找和解包方面具有较小的速度优势:

$ python3.6 -m timeit -s 'a = (10, 20, 30)' 'a[1]'

10000000 loops, best of 3: 0.0304 usec per loop

$ python3.6 -m timeit -s 'a = [10, 20, 30]' 'a[1]'

10000000 loops, best of 3: 0.0309 usec per loop

$ python3.6 -m timeit -s 'a = (10, 20, 30)' 'x, y, z = a'

10000000 loops, best of 3: 0.0249 usec per loop

$ python3.6 -m timeit -s 'a = [10, 20, 30]' 'x, y, z = a'

10000000 loops, best of 3: 0.0251 usec per loop

这里是元组(10, 20)的存储方式:

typedef struct {

Py_ssize_t ob_refcnt;

struct _typeobject *ob_type;

Py_ssize_t ob_size;

PyObject *ob_item[2]; /* store a pointer to 10 and a pointer to 20 */

} PyTupleObject;

这里是列表[10, 20]的存储方式:

PyObject arr[2]; /* store a pointer to 10 and a pointer to 20 */

typedef struct {

Py_ssize_t ob_refcnt;

struct _typeobject *ob_type;

Py_ssize_t ob_size;

PyObject **ob_item = arr; /* store a pointer to the two-pointer array */

Py_ssize_t allocated;

} PyListObject;

请注意,元组对象直接包含两个数据指针,而列表对象具有一个额外的间接层,指向保存两个数据指针的外部数组。

8

t+=i时,您认为发生的是将元素添加到同一元素中,但实际上,您正在通过添加先前元组的元素来创建一个新元组,这就是为什么此操作很慢,而使用列表版本时,您是在向同一列表中添加元素。 - RohitPyTupleObject 的 PyObject *ob_item[2]; 存储了两个对象的指针,即指针数量被硬编码为 2,那么如何有包含超过两个元素的元组呢?这里似乎有些问题。甚至由 @ead 链接的版本只有 PyObject *ob_item[1];。那这是怎么工作的呢? - Kelly Bundy通常情况下,元组可能会稍微快一些。但是您应该确实测试您的特定情况(如果差异可能会影响程序的性能-请记住“过早优化是万恶之源”)。

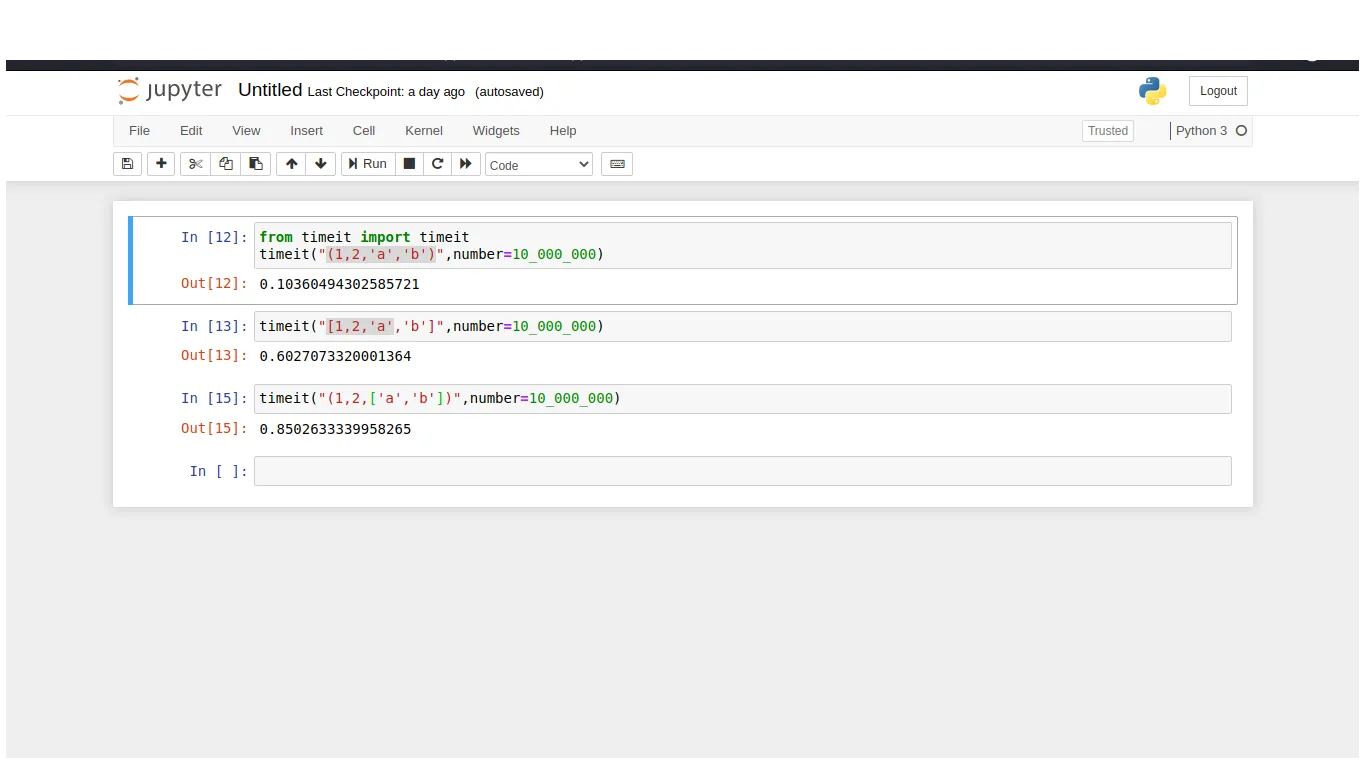

Python使这非常容易:timeit是您的好朋友。

$ python -m timeit "x=(1,2,3,4,5,6,7,8)"

10000000 loops, best of 3: 0.0388 usec per loop

$ python -m timeit "x=[1,2,3,4,5,6,7,8]"

1000000 loops, best of 3: 0.363 usec per loop

而且...

$ python -m timeit -s "x=(1,2,3,4,5,6,7,8)" "y=x[3]"

10000000 loops, best of 3: 0.0938 usec per loop

$ python -m timeit -s "x=[1,2,3,4,5,6,7,8]" "y=x[3]"

10000000 loops, best of 3: 0.0649 usec per loop

因此,在这种情况下,对于元组来说,实例化速度几乎比列表快一个数量级,但是对于项访问来说,列表实际上略快一些!因此,如果您创建了几个元组并多次访问它们,实际上使用列表可能会更快。

当然,如果您想要更改项目,则列表肯定会更快,因为您需要创建一个全新的元组来更改其中一个项目(因为元组是不可变的)。

14

dis 模块可以反汇编函数的字节码,并且对于查看元组和列表之间的区别很有用。

在这种情况下,您可以看到访问元素会生成相同的代码,但是分配元组比分配列表要快得多。

>>> def a():

... x=[1,2,3,4,5]

... y=x[2]

...

>>> def b():

... x=(1,2,3,4,5)

... y=x[2]

...

>>> import dis

>>> dis.dis(a)

2 0 LOAD_CONST 1 (1)

3 LOAD_CONST 2 (2)

6 LOAD_CONST 3 (3)

9 LOAD_CONST 4 (4)

12 LOAD_CONST 5 (5)

15 BUILD_LIST 5

18 STORE_FAST 0 (x)

3 21 LOAD_FAST 0 (x)

24 LOAD_CONST 2 (2)

27 BINARY_SUBSCR

28 STORE_FAST 1 (y)

31 LOAD_CONST 0 (None)

34 RETURN_VALUE

>>> dis.dis(b)

2 0 LOAD_CONST 6 ((1, 2, 3, 4, 5))

3 STORE_FAST 0 (x)

3 6 LOAD_FAST 0 (x)

9 LOAD_CONST 2 (2)

12 BINARY_SUBSCR

13 STORE_FAST 1 (y)

16 LOAD_CONST 0 (None)

19 RETURN_VALUE

6

ListLike 的类,并使用一个非常慢的 __getitem__ 方法,然后反汇编 x = ListLike((1, 2, 3, 4, 5)); y = x[2]。生成的字节码会更像上面的元组示例而不是列表示例,但你真的认为这意味着性能会相似吗? - mzzlist和tuple的整个项目将存储在一个LOAD_CONST操作符中。 - Reza K Ghazi元组是不可变的,因此更加节省内存;列表为了速度效率会过度分配内存来允许在没有常量 realloc 的情况下进行附加操作。因此,如果您想在代码中迭代常量序列的值(例如for direction in 'up','right','down','left'),则应优先选择元组,因为这些元组在编译时被预计算。

读取访问速度应该相同(它们都被存储为连续的数组在内存中)。

但是,在处理可变数据时,alist.append(item) 比 atuple+= (item,) 更受欢迎。请记住,元组旨在作为没有字段名称的记录来处理。

3

这里有另一个小基准测试,只是为了好玩而已。

In [11]: %timeit list(range(100))

749 ns ± 2.41 ns per loop (mean ± std. dev. of 7 runs, 1000000 loops each)

In [12]: %timeit tuple(range(100))

781 ns ± 3.34 ns per loop (mean ± std. dev. of 7 runs, 1000000 loops each)

In [1]: %timeit list(range(1_000))

13.5 µs ± 466 ns per loop (mean ± std. dev. of 7 runs, 100000 loops each)

In [2]: %timeit tuple(range(1_000))

12.4 µs ± 182 ns per loop (mean ± std. dev. of 7 runs, 100000 loops each)

In [7]: %timeit list(range(10_000))

182 µs ± 810 ns per loop (mean ± std. dev. of 7 runs, 10000 loops each)

In [8]: %timeit tuple(range(10_000))

188 µs ± 2.38 µs per loop (mean ± std. dev. of 7 runs, 10000 loops each)

In [3]: %timeit list(range(1_00_000))

2.76 ms ± 30.5 µs per loop (mean ± std. dev. of 7 runs, 100 loops each)

In [4]: %timeit tuple(range(1_00_000))

2.74 ms ± 31.8 µs per loop (mean ± std. dev. of 7 runs, 100 loops each)

In [10]: %timeit list(range(10_00_000))

28.1 ms ± 266 µs per loop (mean ± std. dev. of 7 runs, 10 loops each)

In [9]: %timeit tuple(range(10_00_000))

28.5 ms ± 447 µs per loop (mean ± std. dev. of 7 runs, 10 loops each)

让我们求这些的平均值:

In [3]: l = np.array([749 * 10 ** -9, 13.5 * 10 ** -6, 182 * 10 ** -6, 2.76 * 10 ** -3, 28.1 * 10 ** -3])

In [2]: t = np.array([781 * 10 ** -9, 12.4 * 10 ** -6, 188 * 10 ** -6, 2.74 * 10 ** -3, 28.5 * 10 ** -3])

In [11]: np.average(l)

Out[11]: 0.0062112498000000006

In [12]: np.average(t)

Out[12]: 0.0062882362

In [17]: np.average(t) / np.average(l) * 100

Out[17]: 101.23946713590554

你可以说这几乎是没有结论的。

但是,当然,与列表相比,元组需要花费101.239%的时间,或者额外花费1.239%的时间来完成工作。

1

如果你的列表或元组中的所有项都是相同的C类型,那么还应考虑使用标准库中的array模块。它将占用更少的内存并且可能更快。

1

-- 内存分配

当创建可变容器对象,如列表、集合、字典等时,在它们的生命周期中,这些容器的分配容量(它们可以包含的项数)大于容器中元素的数量。这样做是为了使向集合添加元素更有效率,并称为超额分配。因此,列表的大小不会在每次附加元素时增长 - 它只会偶尔增长。调整列表的大小非常昂贵,因此不要在每次添加项目时调整大小有所帮助,但不要过度分配,因为这会有一个内存成本。

另一方面,由于不可变容器一旦创建其项数就固定了,所以它们不需要这种超额分配 - 因此它们的存储效率更高。随着元组变得越来越大,它们的大小也会增加。

-- 复制

对于不可变序列来说,进行浅层复制没有意义,因为您无论如何都不能对其进行改变。因此,复制元组只返回它本身,具有相同的内存地址。这就是为什么复制元组更快的原因。

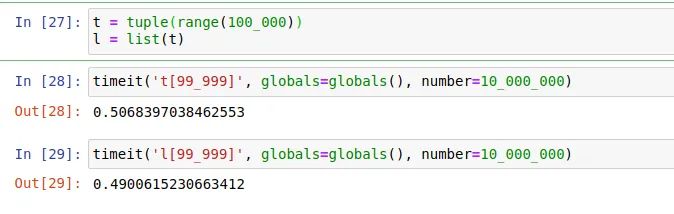

检索元素

我比较了从元组和列表中检索元素所花费的时间:

从元组中检索元素比从列表中稍微快一些。因为在CPython中,元组直接访问(指针)其元素,而列表需要先访问另一个包含列表元素指针的数组。2

元组应该比列表更有效,因为它们是不可变的,所以更快。

3

Tuple之所以在读取时非常高效,主要是因为它是不可变的。

为什么不可变对象易于读取?

原因在于元组可以存储在内存缓存中,而列表则不行。程序总是从列表的内存位置读取,因为它是可变的(随时可以更改)。

原文链接

- 相关问题

- 6 当array.array比lists更高效?

- 4 如何让Array.indexOf比Array.some更高效?

- 19 Stream.toList() 是否比 Collectors.toList() 更高效?

- 100 为什么在Python中元组比列表更快?

- 4 比双重嵌套的ArrayList更高效?

- 5 为什么在Python中元组比列表更大?

- 47 EXISTS比COUNT(*)>0更高效吗?

- 4 在Grails和Groovy中,单引号字符串是否比GString更高效?

- 10 为什么Document.querySelector比Element.querySelector更高效

- 3 在Python中高效地合并重叠的元组列表