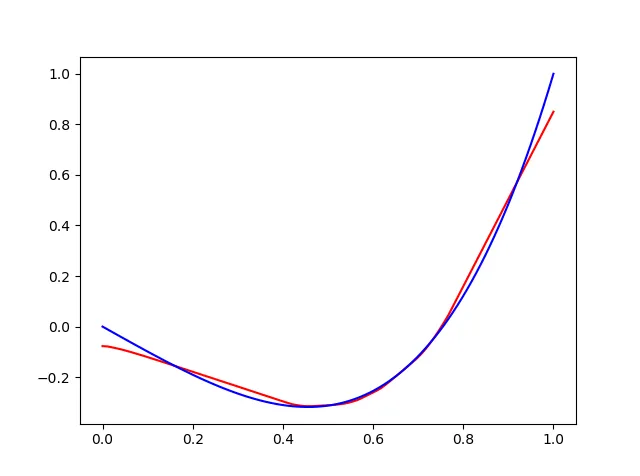

我从一个四次多项式中生成了一些数据,并希望创建一个Keras回归模型来拟合这个多项式。问题在于,拟合后的预测结果似乎基本上是线性的。由于这是我第一次使用神经网络,我认为我可能犯了一个非常微小和愚蠢的错误。

以下是我的代码:

model = Sequential()

model.add(Dense(units=200, input_dim=1))

model.add(Activation('relu'))

model.add(Dense(units=45))

model.add(Activation('relu'))

model.add(Dense(units=1))

model.compile(loss='mean_squared_error',

optimizer='sgd')

model.fit(x_train, y_train, epochs=20, batch_size=50)

loss_and_metrics = model.evaluate(x_test, y_test, batch_size=100)

classes = model.predict(x_test, batch_size=1)

x_train和y_train是包含第前9900个条目的numpy数组此文件。

我尝试了不同的batch_sizes、epochs数、层大小和训练数据量。什么都没有帮助。

请指出您发现的任何不合理之处!