我有一个Spark集群,其中一个Master和4个Workers在一个3节点的Kubernetes集群中运行。Spark UI和Master通过Ingress/NodePort公开,并因此可以从Kubernetes集群外访问。

但是,Worker端口没有公开。因此,无法通过UI访问Worker日志(stdout和stderr)。日志URL被重定向到,等。

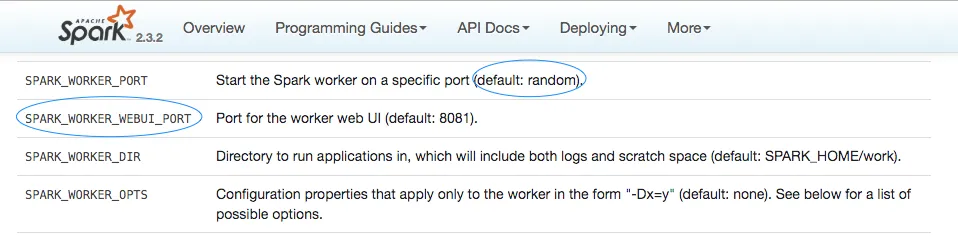

我的设置是两个Worker Pod在同一台机器上运行。因此,即使我NodePort公开Workers,也会存在端口冲突,因为相同的端口将被分配给机器上的两个Workers。Spark历史服务器仅提供事件日志,而不是Worker日志。

如何解决这个问题?是否有一种方法可以动态分配Workers的NodePort值?

但是,Worker端口没有公开。因此,无法通过UI访问Worker日志(stdout和stderr)。日志URL被重定向到,等。

我的设置是两个Worker Pod在同一台机器上运行。因此,即使我NodePort公开Workers,也会存在端口冲突,因为相同的端口将被分配给机器上的两个Workers。Spark历史服务器仅提供事件日志,而不是Worker日志。

如何解决这个问题?是否有一种方法可以动态分配Workers的NodePort值?