faster_rcnn_inception_resnet_v2_atrous_coco 模型(可在此处找到:链接)。在预测时,我使用了物体检测演示jupyter笔记本文件来处理我的图像。同时,我检查了每个步骤所消耗的时间,并发现sess.run占用了所有时间。但是,在GPU上对于一张大小为(3000 x 2000)像素(大约1-2 [MB])的图片进行预测需要25-40 [秒]。 有人能找出问题所在吗? 我已经进行了分析,下载链接如下:分析文件。

完整的分析报告。 系统信息:

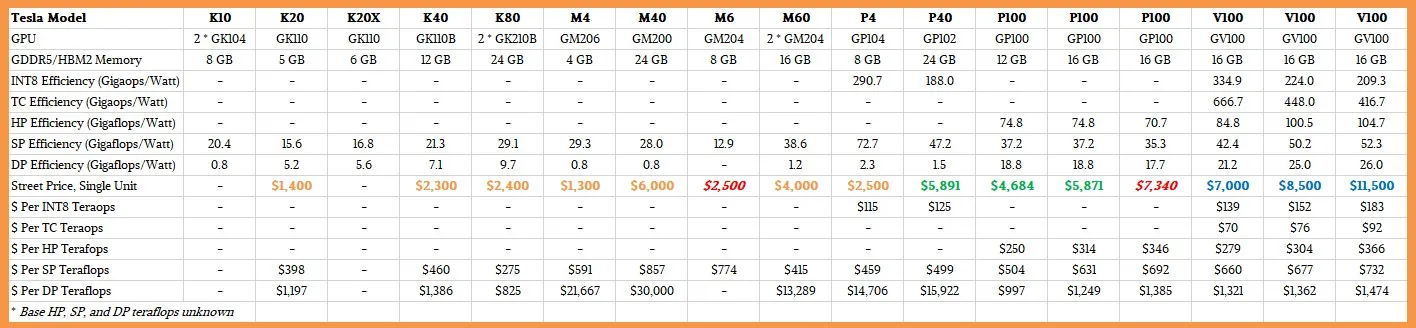

在Azure门户中创建的虚拟机上进行训练和预测,使用了Standard_NV6(详见此处),该虚拟机使用了NVIDIA Tesla M60 GPU。

- 操作系统及版本 - Windows 10

- TensorFlow 安装方式 - 使用pip安装

pip3 install --upgrade tensorflow-gpu - TensorFlow 版本 - 1.8.0

- Python 版本 - 3.6.5

- GPU/CPU - GPU

- CUDA/cuDNN 版本 - CUDA 9/cuDNN 7

python -m cProfile yourscript.py- Lukasz Tracewski