由于执行的一些限制,我们在Airflow 1.10.0中放弃了Celery Executor,并使用KubernetesExecutor。

现在,即使我们直接在代码中更改subdag_operator,有些DAG中的所有任务仍无法并行化:

https://github.com/apache/incubator-airflow/blob/v1-10-stable/airflow/operators/subdag_operator.py#L38我们的期望是通过这些修改和使用Kubernetes Executors,我们可以同时扇出所有任务的执行,但我们具有相同的SequentialExecutor行为。

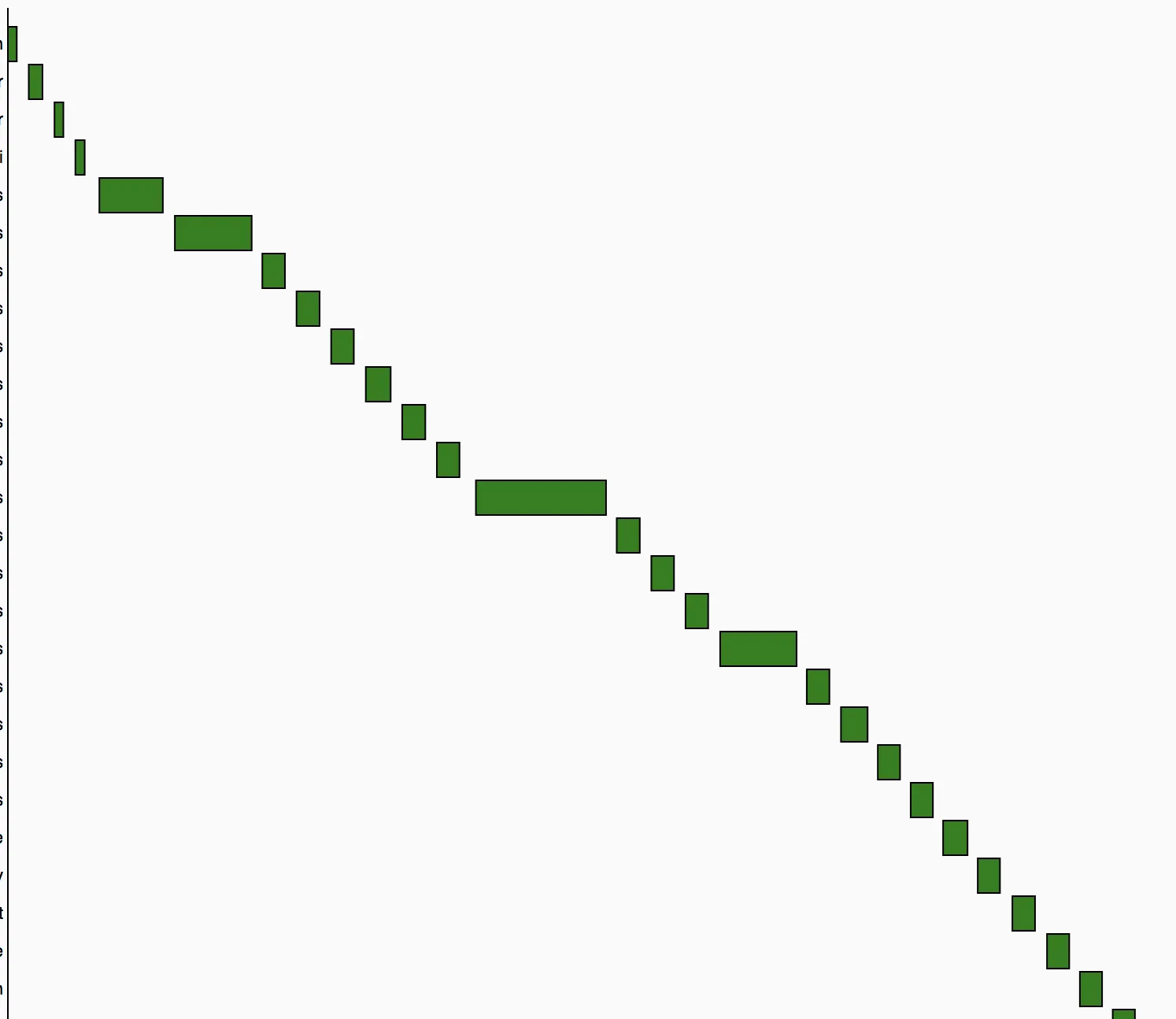

这是我们现在拥有的行为:

我们希望使用KubernetesExecutor同时执行所有任务。