1个回答

2

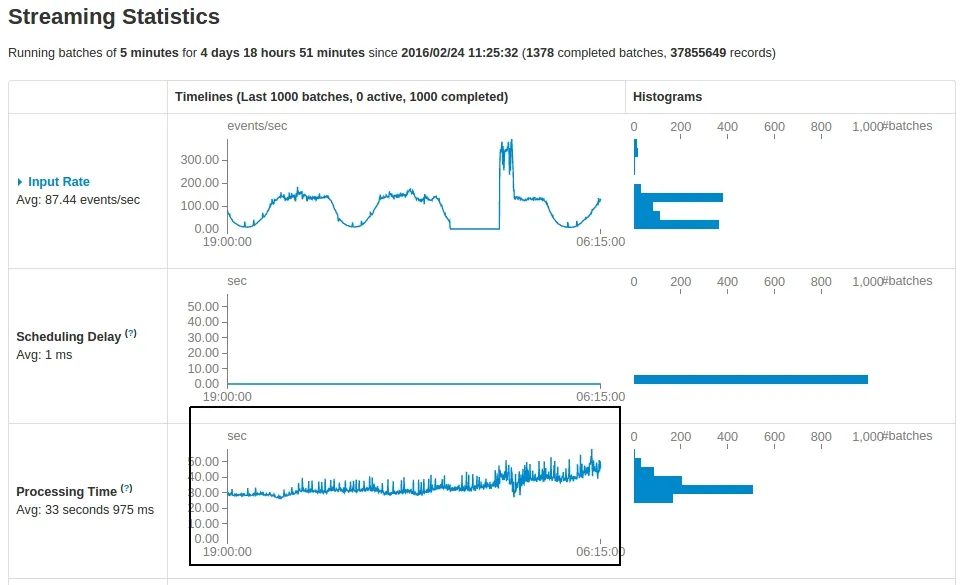

这真的取决于应用程序。我在调试此问题时的方法如下:

- 在存储选项卡下查看存储大小是否不断增长。如果有增长,这可能表明存在某种缓存资源泄漏。检查

spark.cleaner.ttl的值,但最好确保在不再需要资源时取消缓存所有资源。 - 检查正在运行的作业的DAG可视化,并查看谱系是否不断增长。如果是这种情况,请确保执行检查点以削减谱系。

- 减少UI中保留的批次数量(

spark.streaming.ui.retainedBatches参数)。 - 即使事件数相同,请查看任务处理的数据量是否随时间增长(Stages标签 -> 输入列)。这可能指向应用程序级别的问题。

- Michael Spector

1

1对我来说罪魁祸首是:“减少UI中保留的批次数量(spark.streaming.ui.retainedBatches参数)”。 - Mohitt

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

- 相关问题

- 3 Drools Spark Streaming集成用于有状态kiesession

- 3 Spark Streaming 的状态存储在哪里?

- 3 Spark Streaming:HDFS

- 23 Spark Streaming:无状态重叠窗口 vs. 保持状态

- 4 Spark Streaming 共享状态两个流之间

- 3 暂停/限流Spark/Spark Streaming应用程序。

- 7 Spark Streaming历史状态

- 5 Spark Streaming UpdateStateByKey

- 4 Spark Streaming:Spark Structured Streaming中不允许Kafka组ID。

- 12 如何优雅地停止运行Spark Streaming应用程序?