2个回答

1

在第二个数据框上使用coalesce的Left join将适用于这种情况。

示例:

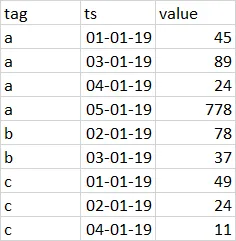

df.show()

#---+--------+-----+

#tag| ts|value|

#---+--------+-----+

# a|01-01-19| 45|

# a|03-01-19| 89|

# a|04-01-19| 24|

# a|05-01-19| 778|

#---+--------+-----+

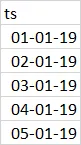

df1.show()

#+--------+

#| ts|

#+--------+

#|01-01-19|

#|02-01-19|

#|03-01-19|

#|04-01-19|

#|05-01-19|

#+--------+

df1.alias("t1").join(df.alias("t2"),col("t1.ts")==col("t2.ts"),"left").\

selectExpr("coalesce(t1.ts,t2.ts) as ts","tag","value").\

orderBy("ts").\

show()

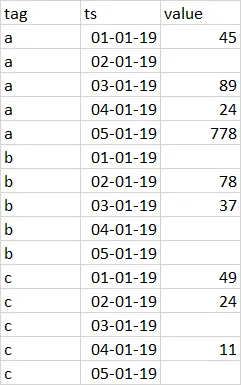

#+--------+----+-----+

#| ts| tag|value|

#+--------+----+-----+

#|01-01-19| a| 45|

#|02-01-19|null| null|

#|03-01-19| a| 89|

#|04-01-19| a| 24|

#|05-01-19| a| 778|

#+--------+----+-----+

- notNull

1

复杂度在于将df1加入n次作为标签数量。在您的示例中,您没有考虑到这种复杂性。 - Joey

0

这是我会这样做的:

如果你想要动态生成一个标签列表,可以从 df1 中创建它。

df2 = (

df2

.withColumn("tag", F.array([F.lit("a"), F.lit("b"), F.lit("c")]))

.withColumn("ts", F.explode("ts"))

)

df_out = df1.join(df2, ["tag","ts"], "outer")

如果你想要动态生成一个标签列表,可以从 df1 中创建它。

- aturc

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

- 相关问题

- 3 Pyspark Levenshtein Join 错误

- 55 在pyspark中进行groupBy后的列别名

- 15 使用pyspark计算groupBy的总数百分比

- 66 在pyspark中groupBy后如何计算唯一ID数量

- 81 使用groupby的pyspark collect_set或collect_list

- 3 PySpark多时间窗口分组(groupby)

- 30 Pyspark:isin与join的区别

- 3 使用Pyspark的Groupby聚合,将值舍入到小数点后两位

- 3 PySpark: 在 join 后 count() 的结果不一致

- 4 从Pandas的groupBy到PySpark的groupBy