在机器学习中,从灰度图像中提取特征存在问题。

我有一张由彩色图像转换而来的灰度图像。

from PIL import Image

img = Image.open('source.png').convert('LA')

img.save('greyscalesource.png')

image2 = imread('greyscalesource.png')

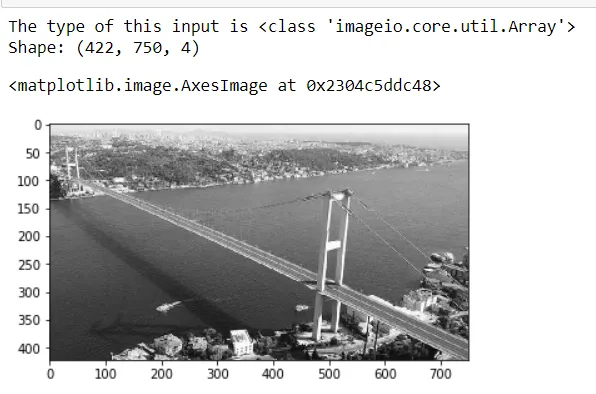

print("The type of this input is {}".format(type(image)))

print("Shape: {}".format(image2.shape))

plt.imshow(image2)

输出为:

我需要从这张灰度图片中提取特征,因为接下来的部分是用这些特征来训练模型,以预测图像的彩色形式。

我们不能使用任何深度学习库。

有一些方法,如SIFT、ORB、FAST等......但我真的不知道如何提取符合我的目标的特征。

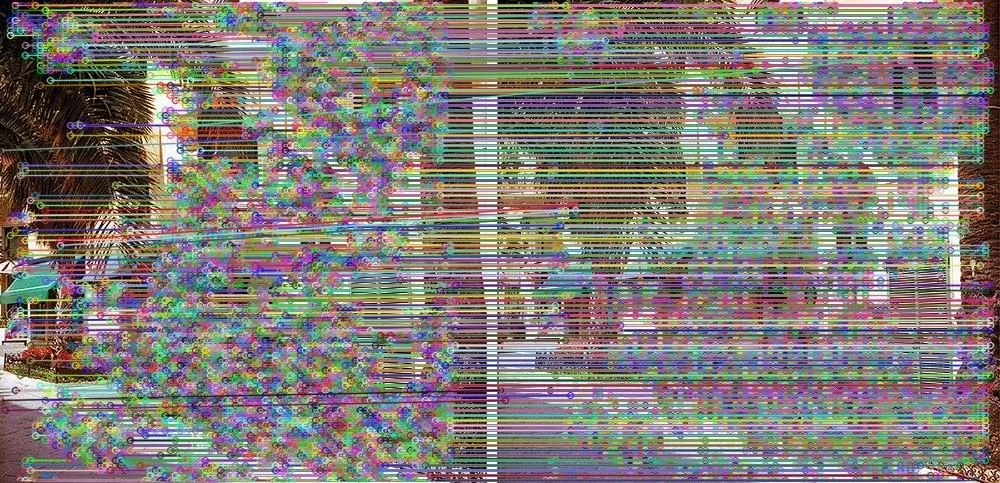

#ORB

orb = cv2.ORB_create()

#keypoints and descriptors

kpO, desO = orb.detectAndCompute(img, None)

img7 = cv2.drawKeypoints(img, kpO, 1, flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS)

cv2.imwrite('_ORB.jpg',img7)

上述代码的输出结果只是True。

有没有什么解决方案或想法,我该怎么做?

des0作为输入传递给你的机器学习模型。上面的例子只是说明了它的使用方法。 - Abhi25t