使用Keras和Tensorflow从头训练自己的数据集上的卷积神经网络。

学习率=0.0001,

需要分类5类,

未使用Dropout,

数据集已经检查两次,没有错误标签。

模型:

model = models.Sequential()

model.add(layers.Conv2D(16,(2,2),activation='relu',input_shape=(75,75,3)))

model.add(layers.MaxPooling2D((2,2)))

model.add(layers.Conv2D(16,(2,2),activation='relu'))

model.add(layers.MaxPooling2D((2,2)))

model.add(layers.Conv2D(32,(2,2),activation='relu'))

model.add(layers.MaxPooling2D((2,2)))

model.add(layers.Flatten())

model.add(layers.Dense(128,activation='relu'))

model.add(layers.Dense(5,activation='sigmoid'))

model.compile(optimizer=optimizers.adam(lr=0.0001),

loss='categorical_crossentropy',

metrics=['acc'])

history = model.fit_generator(train_generator,

steps_per_epoch=100,

epochs=50,

validation_data=val_generator,

validation_steps=25)

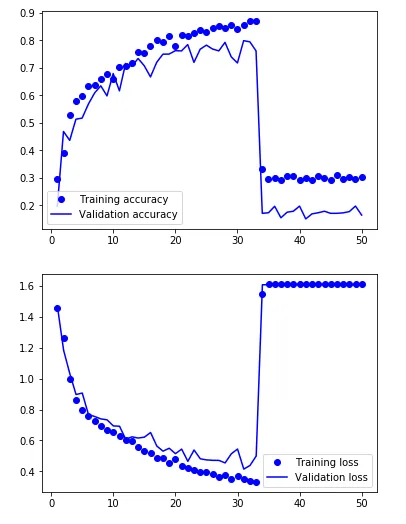

每当模型达到25-35个时期(80-90%准确率)时,就会发生以下情况:

Epoch 31/50

100/100 [==============================] - 3s 34ms/step - loss: 0.3524 - acc: 0.8558 - val_loss: 0.4151 - val_acc: 0.7992

Epoch 32/50

100/100 [==============================] - 3s 34ms/step - loss: 0.3393 - acc: 0.8700 - val_loss: 0.4384 - val_acc: 0.7951

Epoch 33/50

100/100 [==============================] - 3s 34ms/step - loss: 0.3321 - acc: 0.8702 - val_loss: 0.4993 - val_acc: 0.7620

Epoch 34/50

100/100 [==============================] - 3s 33ms/step - loss: 1.5444 - acc: 0.3302 - val_loss: 1.6062 - val_acc: 0.1704

Epoch 35/50

100/100 [==============================] - 3s 34ms/step - loss: 1.6094 - acc: 0.2935 - val_loss: 1.6062 - val_acc: 0.1724

有一些类似的问题和答案,但大多数建议降低学习率,但这根本没有帮助。

更新:网络中几乎所有权重和偏差都变成了 NaN 。 网络在某种程度上死亡了

nan值吗? - X. Wsigmoid激活作为最后一个密集层有特定的原因吗? - Vladsoftmax。 - desertnaut