Q-learning在强化学习中如何与值迭代不同?

我知道Q-learning是无模型的,训练样本是转换(s,a,s',r)。但既然我们知道Q-learning中每个转换的转移和奖励,那么它不就是一种基于模型的学习吗?其中我们知道了状态和动作对的奖励,以及从一个状态进行每个动作的转换(无论是随机还是确定性)?我不明白区别在哪里。

Q-learning在强化学习中如何与值迭代不同?

我知道Q-learning是无模型的,训练样本是转换(s,a,s',r)。但既然我们知道Q-learning中每个转换的转移和奖励,那么它不就是一种基于模型的学习吗?其中我们知道了状态和动作对的奖励,以及从一个状态进行每个动作的转换(无论是随机还是确定性)?我不明白区别在哪里。

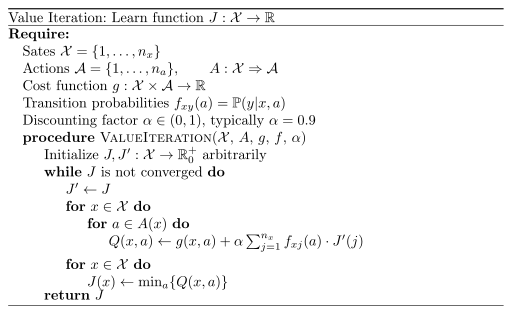

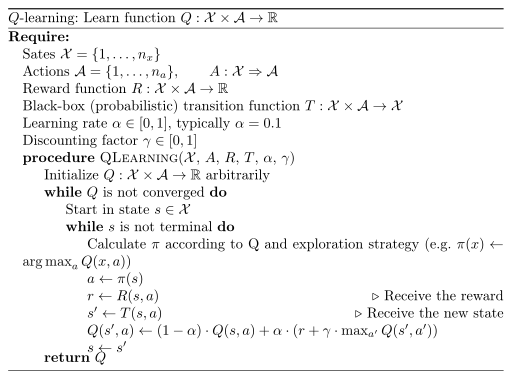

当你拥有转移概率时,使用价值迭代。这意味着当你知道通过动作a从状态x进入状态x'的概率时,可以使用价值迭代。相反,你可能有一个黑盒子,允许你模拟它,但实际上并没有给出概率。所以你是无模型的。这就是应用Q学习的时候。

学到的东西也不同。使用价值迭代时,你学到的是当给定状态x时的预期成本。而使用Q学习时,你获得在状态x下应用动作a时预期折扣成本。

以下是算法:

我目前正在为考试写关于强化学习的一些内容。你可能也对我的讲义笔记感兴趣。然而,它们大多是德语。