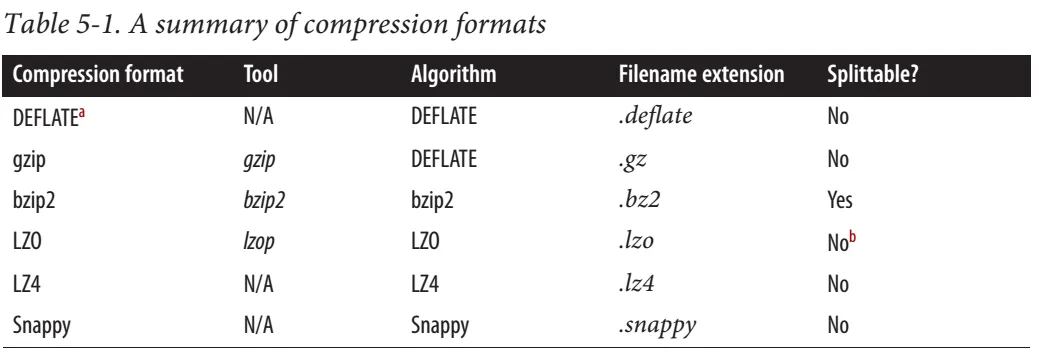

根据此 Cloudera 帖子,Snappy 是可分割的。

对于 MapReduce,如果您需要压缩的数据可以被分割,则 BZip2、LZO 和 Snappy 格式是可以分割的,但 GZip 不行。可分割性与 HBase 数据无关。

但从 hadoop definitive guide 中可以看到,Snappy 不能被分割。 网上也有一些相互矛盾的信息。有些人说它是可分割的,有些人说不是。

网上也有一些相互矛盾的信息。有些人说它是可分割的,有些人说不是。

对于 MapReduce,如果您需要压缩的数据可以被分割,则 BZip2、LZO 和 Snappy 格式是可以分割的,但 GZip 不行。可分割性与 HBase 数据无关。

但从 hadoop definitive guide 中可以看到,Snappy 不能被分割。

网上也有一些相互矛盾的信息。有些人说它是可分割的,有些人说不是。

网上也有一些相互矛盾的信息。有些人说它是可分割的,有些人说不是。